- Двоичная кодировка символов windows

- Таблица кодов кириллицы в Unicode, UTF-8 и Windows-1251

- Представление символов, таблицы кодировок

- Содержание

- Представление символов в вычислительных машинах [ править ]

- Таблицы кодировок [ править ]

- Кодировки стандарта ASCII [ править ]

- Структурные свойства таблицы [ править ]

- Кодировки стандарта UNICODE [ править ]

- Кодовое пространство [ править ]

- Модифицирующие символы [ править ]

- Способы представления [ править ]

- UTF-8 [ править ]

- Принцип кодирования [ править ]

- UTF-16 [ править ]

- UTF-16LE и UTF-16BE [ править ]

- UTF-32 [ править ]

- Порядок байт [ править ]

- Варианты записи [ править ]

- Маркер последовательности байт [ править ]

- Проблемы Юникода [ править ]

- Примеры [ править ]

Двоичная кодировка символов windows

БлогNot. Таблица кодов кириллицы в Unicode, UTF-8 и Windows-1251

Таблица кодов кириллицы в Unicode, UTF-8 и Windows-1251

Во-первых, напомню, что Юникод — не кодировка, а стандарт кодирования, кодировки — это UTF-8, UTF-16 и т.д., но, в силу инерции, разработчики и пользователи часто говорят о «кодировке Юникод», имея в виду распространённую именно в их деревне форму представления символов 🙂

Во-вторых, на самом деле кодирование там довольно замудрённое, возьмём, скажем русскую заглавную «Ж».

Представляемые в Юникоде символы кодируются целыми числами без знака, их можно называть «кодами символов Unicode».

Так, для буквы «Ж» Unicode = 104610 или 041616 или 10000 0101102. Unicode в двоичном виде разбивается на две части: пять левых бит и шесть правых. Левая часть в старших разрядах дополняется до байта признаком 110 двухбайтного кода UTF-8, получаем 11010000. К правой части в старших разрядах приписываются два бита 10 признака продолжения многобайтного кода, получаем 10010110. Окончательно код буквы «Ж» в UTF-8 будет иметь вид 11010000 100101102 или D0 9616.

Именно последний код мы увидим в любом 16-ричном вьюере файла, например, создав в текстовом редакторе файл со словом «Жора» и сохранив его в UTF-8 (только не из Блокнотика Windows, который добавит в начало файла 3-байтовую метку BOM):

То есть, каждая буква кодируется как бы дважды, сначала в 11-битный Unicode, затем в 16-битный UTF-8.

Ниже приведена таблица кодов кириллицы в Unicode, UTF-8 и однобайтовой кодировке Windows-1251.

| Символ | Unicode | UTF-8 | Windows-1251 | ||

|---|---|---|---|---|---|

| 16-ричн. | 10-тичн. | 16-ричн. | 10-тичн. | ||

| А | 0410 | 1040 | D090 | 208 144 | 192 |

| Б | 0411 | 1041 | D091 | 208 145 | 193 |

| В | 0412 | 1042 | D092 | 208 146 | 194 |

| Г | 0413 | 1043 | D093 | 208 147 | 195 |

| Д | 0414 | 1044 | D094 | 208 148 | 196 |

| Е | 0415 | 1045 | D095 | 208 149 | 197 |

| Ж | 0416 | 1046 | D096 | 208 150 | 198 |

| З | 0417 | 1047 | D097 | 208 151 | 199 |

| И | 0418 | 1048 | D098 | 208 152 | 200 |

| Й | 0419 | 1049 | D099 | 208 153 | 201 |

| К | 041A | 1050 | D09A | 208 154 | 202 |

| Л | 041B | 1051 | D09B | 208 155 | 203 |

| М | 041C | 1052 | D09C | 208 156 | 204 |

| Н | 041D | 1053 | D09D | 208 157 | 205 |

| О | 041E | 1054 | D09E | 208 158 | 206 |

| П | 041F | 1055 | D09F | 208 159 | 207 |

| Р | 0420 | 1056 | D0A0 | 208 160 | 208 |

| С | 0421 | 1057 | D0A1 | 208 161 | 209 |

| Т | 0422 | 1058 | D0A2 | 208 162 | 210 |

| У | 0423 | 1059 | D0A3 | 208 163 | 211 |

| Ф | 0424 | 1060 | D0A4 | 208 164 | 212 |

| Х | 0425 | 1061 | D0A5 | 208 165 | 213 |

| Ц | 0426 | 1062 | D0A6 | 208 166 | 214 |

| Ч | 0427 | 1063 | D0A7 | 208 167 | 215 |

| Ш | 0428 | 1064 | D0A8 | 208 168 | 216 |

| Щ | 0429 | 1065 | D0A9 | 208 169 | 217 |

| Ъ | 042A | 1066 | D0AA | 208 170 | 218 |

| Ы | 042B | 1067 | D0AB | 208 171 | 219 |

| Ь | 042C | 1068 | D0AC | 208 172 | 220 |

| Э | 042D | 1069 | D0AD | 208 173 | 221 |

| Ю | 042E | 1070 | D0AE | 208 174 | 222 |

| Я | 042F | 1071 | D0AF | 208 175 | 223 |

| а | 0430 | 1072 | D0B0 | 208 176 | 224 |

| б | 0431 | 1073 | D0B1 | 208 177 | 225 |

| в | 0432 | 1074 | D0B2 | 208 178 | 226 |

| г | 0433 | 1075 | D0B3 | 208 179 | 227 |

| д | 0434 | 1076 | D0B4 | 208 180 | 228 |

| е | 0435 | 1077 | D0B5 | 208 181 | 229 |

| ж | 0436 | 1078 | D0B6 | 208 182 | 230 |

| з | 0437 | 1079 | D0B7 | 208 183 | 231 |

| и | 0438 | 1080 | D0B8 | 208 184 | 232 |

| й | 0439 | 1081 | D0B9 | 208 185 | 233 |

| к | 043A | 1082 | D0BA | 208 186 | 234 |

| л | 043B | 1083 | D0BB | 208 187 | 235 |

| м | 043C | 1084 | D0BC | 208 188 | 236 |

| н | 043D | 1085 | D0BD | 208 189 | 237 |

| о | 043E | 1086 | D0BE | 208 190 | 238 |

| п | 043F | 1087 | D0BF | 208 191 | 239 |

| р | 0440 | 1088 | D180 | 209 128 | 240 |

| с | 0441 | 1089 | D181 | 209 129 | 241 |

| т | 0442 | 1090 | D182 | 209 130 | 242 |

| у | 0443 | 1091 | D183 | 209 131 | 243 |

| ф | 0444 | 1092 | D184 | 209 132 | 244 |

| х | 0445 | 1093 | D185 | 209 133 | 245 |

| ц | 0446 | 1094 | D186 | 209 134 | 246 |

| ч | 0447 | 1095 | D187 | 209 135 | 247 |

| ш | 0448 | 1096 | D188 | 209 136 | 248 |

| щ | 0449 | 1097 | D189 | 209 137 | 249 |

| ъ | 044A | 1098 | D18A | 209 138 | 250 |

| ы | 044B | 1099 | D18B | 209 139 | 251 |

| ь | 044C | 1100 | D18C | 209 140 | 252 |

| э | 044D | 1101 | D18D | 209 141 | 253 |

| ю | 044E | 1102 | D18E | 209 142 | 254 |

| я | 044F | 1103 | D18F | 209 143 | 255 |

| Символы вне общего правила | |||||

| Ё | 0401 | 1025 | D081 | 208 129 | 168 |

| ё | 0451 | 1105 | D191 | 209 145 | 184 |

23.09.2018, 12:37; рейтинг: 43047

Представление символов, таблицы кодировок

Содержание

Представление символов в вычислительных машинах [ править ]

В вычислительных машинах символы не могут храниться иначе, как в виде последовательностей бит (как и числа). Для передачи символа и его корректного отображения ему должна соответствовать уникальная последовательность нулей и единиц. Для этого были разработаны таблицы кодировок.

Количество символов, которые можно задать последовательностью бит длины [math]n[/math] , задается простой формулой [math]C(n) = 2^n[/math] . Таким образом, от нужного количества символов напрямую зависит количество используемой памяти.

Таблицы кодировок [ править ]

На заре компьютерной эры на каждый символ было отведено по пять бит. Это было связано с малым количеством оперативной памяти на компьютерах тех лет. В эти [math]32[/math] символа входили только управляющие символы и строчные буквы английского алфавита.

С ростом производительности компьютеров стали появляться таблицы кодировок с большим количеством символов. Первой семибитной кодировкой стала ASCII7. В нее уже вошли прописные буквы английского алфавита, арабские цифры, знаки препинания. Затем на ее базе была разработана ASCII8, в которым уже стало возможным хранение [math]256[/math] символов: [math]128[/math] основных и еще столько же расширенных. Первая часть таблицы осталась без изменений, а вторая может иметь различные варианты (каждый имеет свой номер). Эта часть таблицы стала заполняться символами национальных алфавитов.

Но для многих языков (например, арабского, японского, китайского) [math]256[/math] символов недостаточно, поэтому развитие кодировок продолжалось, что привело к появлению UNICODE.

Кодировки стандарта ASCII [ править ]

| Определение: |

| ASCII — таблицы кодировок, в которых содержатся основные символы (английский алфавит, цифры, знаки препинания, символы национальных алфавитов(свои для каждого региона), служебные символы) и длина кода каждого символа [math]n = 8[/math] бит. |

- ASCII7 — первая кодировка, пригодная для работы с текстом. Помимо маленьких букв английского алфавита и служебных символов, содержит большие буквы английского языка, цифры, знаки препинания и другие символы.

Кодировки стандарта ASCII ( [math]8[/math] бит):

- ASCII — первая кодировка, в которой стало возможно использовать символы национальных алфавитов.

- КОИ8-R — первая русская кодировка. Символы кириллицы расположены не в алфавитном порядке. Их разместили в верхнюю половину таблицы так, чтобы позиции кириллических символов соответствовали их фонетическим аналогам в английском алфавите. Это значит, что даже при потере старшего бита каждого символа, например, при проходе через устаревший семибитный модем, текст остается «читаемым».

- CP866 — русская кодировка, использовавшаяся на компьютерах IBM в системе DOS.

- Windows-1251 — русская кодировка, использовавшаяся в русскоязычных версиях операционной системы Windows в начале 90-х годов. Кириллические символы идут в алфавитном порядке. Содержит все символы, встречающиеся в типографике обычного текста (кроме знака ударения).

Структурные свойства таблицы [ править ]

- Цифры 0-9 представляются своими двоичными значениями (например, [math]5=0101_2[/math] ), перед которыми стоит [math]0011_2[/math] . Таким образом, двоично-десятичные числа (BCD) превращаются в ASCII-строку с помощью простого добавления слева [math]0011_2[/math] к каждому двоично-десятичному полубайту.

- Буквы A-Z верхнего и нижнего регистров различаются в своём представлении только одним битом, что упрощает преобразование регистра и проверку на диапазон. Буквы представляются своими порядковыми номерами в алфавите, записанными в двоичной системе счисления, перед которыми стоит [math]0100_2[/math] (для букв верхнего регистра) или [math]0110_2[/math] (для букв нижнего регистра).

| 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | A | B | C | D | E | F | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | NUL | SOH | STX | ETX | EOT | ENQ | ACK | BEL | BS | TAB | LF | VT | FF | CR | SO | SI | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 1 | DLE | DC1 | DC2 | DC3 | DC4 | NAK | SYN | ETB | CAN | EM | SUB | ESC | FS | GS | RS | US | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 2 | ! | « | # | $ | % | & | ‘ | ( | ) | * | + | , | — | . | / | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 3 | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | : | ; | ? | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 4 | @ | A | B | C | D | E | F | G | H | I | J | K | L | M | N | O | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 5 | P | Q | R | S | T | U | V | W | X | Y | Z | [ | \ | ] | ^ | _ | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| 6 | ` | a | b | c | d | e | f | g | h | i | j | k | l | m | n | o | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

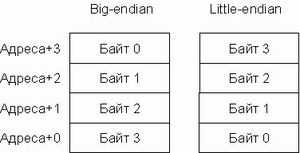

| 7 | p | q | r | s | t | u | v | w | x | y | z | < | | | > | Кодировки стандарта UNICODE [ править ]Юникод или Уникод (англ. Unicode) — это промышленный стандарт обеспечивающий цифровое представление символов всех письменностей мира, и специальных символов. Стандарт предложен в 1991 году некоммерческой организацией «Консорциум Юникода» (англ. Unicode Consortium, Unicode Inc.). Применение этого стандарта позволяет закодировать очень большое число символов из разных письменностей. Стандарт состоит из двух основных разделов: универсальный набор символов (англ. UCS, universal character set) и семейство кодировок (англ. UTF, Unicode transformation format). Универсальный набор символов задаёт однозначное соответствие символов кодам — элементам кодового пространства, представляющим неотрицательные целые числа.Семейство кодировок определяет машинное представление последовательности кодов UCS. Коды в стандарте Unicode разделены на несколько областей. Область с кодами от U+0000 до U+007F содержит символы набора ASCII с соответствующими кодами. Далее расположены области знаков различных письменностей, знаки пунктуации и технические символы. Под символы кириллицы выделены области знаков с кодами от U+0400 до U+052F, от U+2DE0 до U+2DFF, от U+A640 до U+A69F. Часть кодов зарезервирована для использования в будущем. Кодовое пространство [ править ]Хотя формы записи UTF-8 и UTF-32 позволяют кодировать до [math]2^<31>[/math] [math](2\ 147\ 483\ 648)[/math] кодовых позиций, было принято решение использовать лишь [math]1\ 112\ 064[/math] для совместимости с UTF-16. Впрочем, даже и этого на текущий момент более чем достаточно — в версии 6.0 используется чуть менее [math]110\ 000[/math] кодовых позиций ( [math]109\ 242[/math] графических и [math]273[/math] прочих символов). Кодовое пространство разбито на [math]17[/math] плоскостей (англ. planes) по [math]2^<16>[/math] [math](65\ 536)[/math] символов. Нулевая плоскость называется базовой, в ней расположены символы наиболее употребительных письменностей. Первая плоскость используется, в основном, для исторических письменностей, вторая — для для редко используемых иероглифов китайского письма, третья зарезервирована для архаичных китайских иероглифов. Плоскости [math]15[/math] и [math]16[/math] выделены для частного употребления. Для обозначения символов Unicode используется запись вида «U+xxxx» (для кодов [math]0000_<16>..FFFF_<16>[/math] ) или «U+xxxxx» (для кодов [math]10000_<16>..FFFFF_<16>[/math] ) или «U+xxxxxx» (для кодов [math]100000_<16>..10FFFF_<16>[/math] ), где xxx — шестнадцатеричные цифры. Например, символ «я» (U+044F) имеет код [math]044F_ <16>= 1103_<10>[/math] .

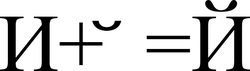

Модифицирующие символы [ править ]Графические символы в Юникоде делятся на протяжённые и непротяжённые. Непротяжённые символы при отображении не занимают дополнительного места в строке. К примеру, к ним относятся знак ударения. Протяжённые и непротяжённые символы имеют собственные коды, но последние не могут встречаться самостоятельно. Протяжённые символы называются базовыми (англ. base characters), а непротяженные — модифицирующими (англ. combining characters). Например символ «Й» (U+0419) может быть представлен в виде базового символа «И» (U+0418) и модифицирующего символа « ̆» (U+0306). Способы представления [ править ]Юникод имеет несколько форм представления (англ. Unicode Transformation Format, UTF): UTF-8, UTF-16 (UTF-16BE, UTF-16LE) и UTF-32 (UTF-32BE, UTF-32LE). Была разработана также форма представления UTF-7 для передачи по семибитным каналам, но из-за несовместимости с ASCII она не получила распространения и не включена в стандарт. UTF-8 [ править ]UTF-8 — представление Юникода, обеспечивающее наилучшую совместимость со старыми системами, использовавшими [math]8[/math] -битные символы. Текст, состоящий только из символов с номером меньше [math]128[/math] , при записи в UTF-8 превращается в обычный текст ASCII. И наоборот, в тексте UTF-8 любой байт со значением меньше [math]128[/math] изображает символ ASCII с тем же кодом. Остальные символы Юникода изображаются последовательностями длиной от двух до шести байт (на деле, только до четырех байт, поскольку в Юникоде нет символов с кодом больше [math]10FFFF_<16>[/math] , и вводить их в будущем не планируется), в которых первый байт всегда имеет вид [math]11xxxxxx[/math] , а остальные — [math]10xxxxxx[/math] . Символы UTF-8 получаются из Unicode cледующим образом:

Несмотря на то, что UTF-8 позволяет указать один и тот же символ несколькими способами, только наиболее короткий из них правильный. Остальные формы, называемые overlong sequence, отвергаются по соображениям безопасности. Принцип кодирования [ править ]Правила записи кода одного символа в UTF-8 [ править ]1. Если размер символа в кодировке UTF-8 = [math]1[/math] байт Код имеет вид (0aaa aaaa), где «0» — просто ноль, остальные биты «a» — это код символа в кодировке ASCII; 2. Если размер символа в кодировке в UTF-8 [math]\gt 1[/math] байт (то есть от [math]2[/math] до [math]6[/math] ): 2.1 Первый байт содержит количество байт символа, закодированное в единичной системе счисления; 2.2 «0» — бит терминатор, означающий завершение кода размера 2.3 далее идут значащие байты кода, которые имеют вид (10xx xxxx), где «10» — биты признака продолжения, а «x» — значащие биты. В общем случае варианты представления одного символа в кодировке UTF-8 выглядят так: Определение длины кода в UTF-8 [ править ]

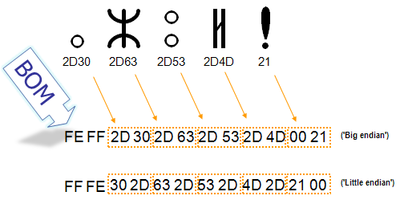

В общем случае количество значащих бит [math]C[/math] , кодируемых [math]n[/math] байтами UTF-8, определяется по формуле: [math]C = 7[/math] при [math]n=1[/math] [math]C = n\cdot5+1[/math] при [math]n\gt 1[/math] UTF-16 [ править ]UTF-16 — один из способов кодирования символов (англ. code point) из Unicode в виде последовательности [math]16[/math] -битных слов (англ. code unit). Данная кодировка позволяет записывать символы Юникода в диапазонах U+0000..U+D7FF и U+E000..U+10FFFF (общим количеством [math]1\ 112\ 064[/math] ), причем [math]2[/math] -байтные символы представляются как есть, а более длинные — с помощью суррогатных пар (англ. surrogate pair), для которых и вырезан диапазон [math]D800_<16>..DFFF_<16>[/math] . В UTF-16 символы кодируются двухбайтовыми словами с использованием всех возможных диапазонов значений (от [math]0000_<16>[/math] до [math]FFFF_<16>[/math] ). При этом можно кодировать символы Unicode в диапазонах [math]0000_<16>..D7FF_<16>[/math] и [math]E000_<16>..10FFFF_<16>[/math] . Исключенный отсюда диапазон [math]D800_<16>..DFFF_<16>[/math] используется как раз для кодирования так называемых суррогатных пар — символов, которые кодируются двумя [math]16[/math] -битными словами. Символы Unicode до [math]FFFF_<16>[/math] включительно (исключая диапазон для суррогатов) записываются как есть [math]16[/math] -битным словом. Символы же в диапазоне [math]10000_<16>..10FFFF_<16>[/math] (больше [math]16[/math] бит) уже кодируются парой [math]16[/math] -битных слов. Для этого их код арифметически сдвигается до нуля (из него вычитается минимальное число [math]10000_<16>[/math] ). В результате получится значение от нуля до [math]FFFFF_<16>[/math] , которое занимает до [math]20[/math] бит. Старшие [math]10[/math] бит этого значения идут в лидирующее (первое) слово, а младшие [math]10[/math] бит — в последующее (второе). При этом в обоих словах старшие [math]6[/math] бит используются для обозначения суррогата. Биты с [math]11[/math] по [math]15[/math] имеют значения [math]11011_2[/math] , а [math]10[/math] -й бит содержит [math]0[/math] у лидирующего слова и [math]1[/math] — у последующего. В связи с этим можно легко определить к чему относится каждое слово. UTF-16LE и UTF-16BE [ править ]Один символ кодировки UTF-16 представлен последовательностью двух байт или двух пар байт. Который из двух байт в словах идёт впереди, старший или младший, зависит от порядка байт. Подробнее об этом будет сказано ниже. UTF-32 [ править ]UTF-32 — один из способов кодирования символов из Юникод, использующий для кодирования любого символа ровно [math]32[/math] бита. Остальные кодировки, UTF-8 и UTF-16, используют для представления символов переменное число байт. Символ UTF-32 является прямым представлением его кодовой позиции (англ. code point). Главное преимущество UTF-32 перед кодировками переменной длины заключается в том, что символы Юникод непосредственно индексируемы. Получение [math]n[/math] -ой кодовой позиции является операцией, занимающей одинаковое время. Напротив, коды с переменной длиной требует последовательного доступа к [math]n[/math] -ой кодовой позиции. Это делает замену символов в строках UTF-32 простой, для этого используется целое число в качестве индекса, как обычно делается для строк ASCII. Главный недостаток UTF-32 — это неэффективное использование пространства, так как для хранения символа используется четыре байта. Символы, лежащие за пределами нулевой (базовой) плоскости кодового пространства редко используются в большинстве текстов. Поэтому удвоение, в сравнении с UTF-16, занимаемого строками в UTF-32 пространства не оправдано. Хотя использование неменяющегося числа байт на символ удобно, но не настолько, как кажется. Операция усечения строк реализуется легче в сравнении с UTF-8 и UTF-16. Но это не делает более быстрым нахождение конкретного смещения в строке, так как смещение может вычисляться и для кодировок фиксированного размера. Это не облегчает вычисление отображаемой ширины строки, за исключением ограниченного числа случаев, так как даже символ «фиксированной ширины» может быть получен комбинированием обычного символа с модифицирующим, который не имеет ширины. Например, буква «й» может быть получена из буквы «и» и диакритического знака «крючок над буквой». Сочетание таких знаков означает, что текстовые редакторы не могут рассматривать [math]32[/math] -битный код как единицу редактирования. Редакторы, которые ограничиваются работой с языками с письмом слева направо и составными символами (англ. Precomposed character), могут использовать символы фиксированного размера. Но такие редакторы вряд ли поддержат символы, лежащие за пределами нулевой (базовой) плоскости кодового пространства и вряд ли смогут работать одинаково хорошо с символами UTF-16. Порядок байт [ править ]В современной вычислительной технике и цифровых системах связи информация обычно представлена в виде последовательности байт. В том случае, если число не может быть представлено одним байтом, имеет значение в каком порядке байты записываются в памяти компьютера или передаются по линиям связи. Часто выбор порядка записи байт произволен и определяется только соглашениями. В общем случае, для представления числа [math]M[/math] , большего [math]255[/math] (здесь [math]255=2^8-1[/math] — максимальное целое число, записываемое одним байтом), приходится использовать несколько байт. При этом число [math]M[/math] записывается в позиционной системе счисления по основанию [math]256[/math] : [math]M = \sum_ Набор целых чисел [math]A_0,\dots,A_n[/math] , каждое из которых лежит в интервале от [math]0[/math] до [math]255[/math] , является последовательностью байт, составляющих [math]M[/math] . При этом [math]A_0[/math] называется младшим байтом, а [math]A_n[/math] — старшим байтом числа [math]M[/math] . Варианты записи [ править ]Порядок от старшего к младшему [ править ]Порядок от старшего к младшему (англ. big-endian): [math]A_n,\dots,A_0[/math] , запись начинается со старшего и заканчивается младшим. Этот порядок является стандартным для протоколов TCP/IP, он используется в заголовках пакетов данных и во многих протоколах более высокого уровня, разработанных для использования поверх TCP/IP. Поэтому, порядок байт от старшего к младшему часто называют сетевым порядком байт (англ. network byte order). Этот порядок байт используется процессорами IBM 360/370/390, Motorola 68000, SPARC (отсюда третье название — порядок байт Motorola, Motorola byte order). В этом же виде (используя представление в десятичной системе счисления) записываются числа индийско-арабскими цифрами в письменностях с порядком знаков слева направо (латиница, кириллица). Для письменностей с обратным порядком (арабская) та же запись числа воспринимается как «от младшего к старшему». Порядок байт от старшего к младшему применяется во многих форматах файлов — например, PNG, FLV, EBML. Порядок от младшего к старшему [ править ]Порядок от младшего к старшему (англ. little-endian): [math]A_0,\dots,A_n[/math] , запись начинается с младшего и заканчивается старшим. Этот порядок записи принят в памяти персональных компьютеров с x86-процессорами, в связи с чем иногда его называют интеловский порядок байт (по названию фирмы-создателя архитектуры x86). В противоположность порядку big-endian, соглашение little-endian поддерживают меньше кросс-платформенных протоколов и форматов данных; существенные исключения: USB, конфигурация PCI, таблица разделов GUID, рекомендации FidoNet. Переключаемый порядок [ править ]Многие процессоры могут работать и в порядке от младшего к старшему, и в обратном, например, ARM, PowerPC (но не PowerPC 970), DEC Alpha, MIPS, PA-RISC и IA-64. Обычно порядок байт выбирается программно во время инициализации операционной системы, но может быть выбран и аппаратно перемычками на материнской плате. В этом случае правильнее говорить о порядке байт операционной системы. Переключаемый порядок байт иногда называют англ. bi-endian. Смешанный порядок [ править ]Смешанный порядок байт (англ. middle-endian) иногда используется при работе с числами, длина которых превышает машинное слово. Число представляется последовательностью машинных слов, которые записываются в формате, естественном для данной архитектуры, но сами слова следуют в обратном порядке. Классический пример middle-endian — представление [math]4[/math] -байтных целых чисел на [math]16[/math] -битных процессорах семейства PDP-11 (известен как PDP-endian). Для представления двухбайтных значений (слов) использовался порядок little-endian, но [math]4[/math] -хбайтное двойное слово записывалось от старшего слова к младшему. В процессорах VAX и ARM используется смешанное представление для длинных вещественных чисел. Различия [ править ]Существенным достоинством little-endian по сравнению с big-endian порядком записи считается возможность «неявной типизации» целых чисел при чтении меньшего объёма байт (при условии, что читаемое число помещается в диапазон). Так, если в ячейке памяти содержится число [math]00000022_<16>[/math] , то прочитав его как int16 (два байта) мы получим число [math]0022_<16>[/math] , прочитав один байт — число [math]22_<16>[/math] . Однако, это же может считаться и недостатком, потому что провоцирует ошибки потери данных. Обратно, считается что у little-endian, по сравнению с big-endian есть «неочевидность» значения байт памяти при отладке (последовательность байт (A1, B2, C3, D4) на самом деле значит [math]D4C3B2A1_<16>[/math] , для big-endian эта последовательность (A1, B2, C3, D4) читалась бы «естественным» для арабской записи чисел образом: [math]A1B2C3D4_<16>[/math] ). Наименее удобным в работе считается middle-endian формат записи; он сохранился только на старых платформах. Для записи длинных чисел (чисел, длина которых существенно превышает разрядность машины) обычно предпочтительнее порядок слов в числе little-endian (поскольку арифметические операции над длинными числами производятся от младших разрядов к старшим). Порядок байт в слове — обычный для данной архитектуры. Маркер последовательности байт [ править ]Для определения формата представления Юникода в начало текстового файла записывается сигнатура — символ U+FEFF (неразрывный пробел с нулевой шириной), также именуемый маркером последовательности байт (англ. byte order mark (BOM)). Это позволяет различать UTF-16LE и UTF-16BE, поскольку символа U+FFFE не существует.

В кодировке UTF-8, наличие BOM не является существенным, поскольку, нет альтернативной последовательности байт. Когда BOM используется на страницах или редакторах для контента закодированного в UTF-8, иногда он может представить пробелы или короткие последовательности символов, имеющие странный вид (такие как ). Именно поэтому, при наличии выбора, для совместимости, как правило, лучше упустить BOM в UTF-8 контенте.Однако BOM могут еще встречаться в тексте закодированном в UTF-8, как побочный продукт перекодирования или потому, что он был добавлен редактором. В этом случае BOM часто называют подписью UTF-8. Когда символ закодирован в UTF-16, его [math]2[/math] или [math]4[/math] байта можно упорядочить двумя разными способами (little-endian или big-endian). Изображение справа показывает это. Byte order mark указывает, какой порядок используется, так что приложения могут немедленно расшифровать контент. UTF-16 контент должен всегда начинатся с BOM. BOM также используется для текста обозначенного как UTF-32. Аналогично UTF-16 существует два варианта четырёхбайтной кодировки — UTF-32BE и UTF-32LE. К сожалению, этот способ не позволяет надёжно различать UTF-16LE и UTF-32LE, поскольку символ U+0000 допускается Юникодом Проблемы Юникода [ править ]В Юникоде английское «a» и польское «a» — один и тот же символ. Точно так же одним символом (но отличающимся от «a» латинского) считаются русское «а» и сербское «а». Такой принцип кодирования не универсален; по-видимому, решения «на все случаи жизни» вообще не может существовать. Примеры [ править ]Если записать строку ‘hello мир’ в файл exampleBOM, а затем сделать его hex-дамп, то можно убедиться в том, что разные символы кодируются разным количеством байт. Например, английские буквы,пробел, знаки препинания и пр. кодируются одним байтом, а русские буквы — двумя | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||