Software Delivery Repository

Management Component Pack

The Linux Management Component Pack provides agent software for use on community-supported distributions. For RedHat and SUSE distributions, please use the Service Pack for ProLiant (SPP). The MCP (unlike the SPP) does not provide drivers and firmware (firmware is provided via HPSUM, and drivers are provided by the distribution vendors). Please see the HPE server operating systems home page for more information, including support matrices for HPE ProLiant Servers.

| hp-health | HPE System Health Application and Command line Utilities (Gen9 and earlier) |

| hponcfg | HPE RILOE II/iLO online configuration utility |

| amsd | HPE Agentless Management Service (Gen10 only) |

| hp-ams | HPE Agentless Management Service (Gen9 and earlier) |

| hp-snmp-agents | Insight Management SNMP Agents for HPE ProLiant Systems (Gen9 and earlier) |

| hpsmh | HPE System Management Homepage (Gen9 and earlier) |

| hp-smh-templates | HPE System Management Homepage Templates (Gen9 and earlier) |

| ssacli | HPE Command Line Smart Storage Administration Utility |

| ssaducli | HPE Command Line Smart Storage Administration Diagnostics |

| ssa | HPE Array Smart Storage Administration Service |

NOTICE: The health/snmp functionality was moved to the iLO card on HPE ProLiant Gen10 servers. The hp-health, hp-snmp-agents, hp-smh* and hp-ams debs are only to be installed on Gen9 servers and earlier. Gen10 users, please subscribe to «11.xx» or «current» repositories. Gen9 users, please use «10.xx» or earlier.

Источник

Linux System Administrator’s Blog

Manually installing HP SIM

Verify that SNMP & hp-snmp-agent is installed by executing the following command

]# rpm -qa | grep snmp

[root@client.local

]# rpm -qa | grep hp-snmp

If above packages are not installed, please install it before proceeding the HP SIM Installation

Step 1: HP SNMP Agent

Previously, this was known as hpasm, but now HP renamed it to

Step 2: HP Yum Repositories

There is a dedicated Redhat Repository by HP, which is configured like the following.

]# vim /etc/yum.repos.d/hp.repo

[HP-Proliant]

name=HP Proliant Red Hat Enterprise Linux $releasever — $basearch

#baseurl=ftp://ftp.redhat.com/pub/redhat/linux/enterprise/$releasever/en/os/$basearch/Debuginfo/

baseurl=http://downloads.linux.hp.com/SDR/downloads/ProLiantSupportPack/RedHat/$releasever/$basearch/current/

#http://downloads.linux.hp.com/SDR/downloads/ProLiantSupportPack/RedHat/5/x86_64/current/

enabled=1

gpgcheck=1

gpgkey=http://downloads.linux.hp.com/SDR/downloads/ProLiantSupportPack/GPG-KEY-ProLiantSupportPack

Step 3: Installation

yum remove hpasm is required, as it is deprecated, and will cause conflicts!

]# yum install hp-snmp-agents hp-health hpacucli

Step 4: SNMP Configuration

Do not forget to stop the SNMP services before making the changes.

Save the old configuration file and make sure the new configuration file have the correct permissions

]# cd /etc/snmp/

[root@client.local

]# cp snmpd.conf snmpd.conf.old

[root@client.local

Add the following in first line of snmpd.conf file

rocommunity TEST-Server

trapsink 192.168.1.5

Configure Linux to start SNMP services on each reboot with the chkconfig

]# chkconfig snmpd on

[root@client.local

Test whether SNMP can read the system and interface MIBs using the snmpwalk command.

]# snmpwalk -v 1 TEST-Server -c localhost system

[root@client.local

]# snmpwalk -v 1 TEST-Server -c localhost interface

Test the snmp is working from any other linux machine.

]# snmpwalk -v 1 TEST-Server -c client.local system

[root@server.local

]# snmpwalk -v 1 TEST-Server -c client.local interface

[root@server.local

]# snmpwalk -v 1 TEST-Server -c client.local .1.3.6.1.4.1.232

Step 5: Nagios Configuration

1. Download and install check_hpasm plugin

]# wget http://labs.consol.de/download/shinken-nagios-plugins/check_hpasm-4.6.3.2.tar.gz

[root@client.local

]# tar zxvf check_hpasm-4.6.3.2.tar.gz

[root@client.local

]# cd check_hpasm-4.6.3.2

[root@client.local

]# ./configure —prefix=/usr/local/nagios —with-nagios-user=nagios —with-nagios-group=nagios —with-perl=/usr/bin/perl —with-noinst-level=ok —enable-perfdata —enable-hpacucli

[root@client.local

2. Check whether check_hpasm plugin working

[root@client.local libexec]# ./check_hpasm

OK — System: ‘proliant dl360 g5’, S/N: ‘AAAAAAAAAA’, ROM: ‘P58 10/11/2009’, hardware working fine

3. Sudo configuration changes

Add the following lines in EOF

nagios ALL=(ALL) NOPASSWD: /sbin/hpasmcli

nagios ALL=(ALL) NOPASSWD: /usr/local/nagios/libexec/check_hpasm

Defaults:nagios !requiretty

4. Now execute step 2 as nagios user, if everything is working fine

Источник

Настройка CentOS Linux 7.2 на сервере HP ProLiant DL360 G5. Установка HP System Management Tools

В частности, нами будут установлены утилиты (в скобках указаны названия необходимых rpm пакетов):

- HPE System Health Application and Command Line Utilities (hp-health)

- Insight Management Agents(SNMP) for HPE ProLiant Systems (hp-snmp-agents)

- HP System Management Homepage (hpsmh)

- HPE System Management Homepage Template Package (hp-smh-templates)

- HPE Smart Storage Administrator (hpssa)

- HPE Command Line Smart Storage Administrator (hpssacli)

- Hponcfg — HP Lights-Out Online Configuration Utility (hponcfg)

- HP Insight Diagnostics (hpdiags)

В качестве опорной информации было взято развёрнутое сообщение на форуме CentOS некоего гражданина dgrant, за что ему большущее спасибо. Итак, приступим…

Подключаем репозитории HP

Страница информации о Linux-репозиториях для распространения программного обеспечения HP расположена здесь: Software Delivery Repository — Getting Started . Там же есть ссылка на sh-скрипт, который способен автоматически добавить в нашу серверную систему на Linux информацию о репозиториях HP. Забегая вперёд, отмечу тот факт, что текущая версия скрипта при вызове без дополнительных параметров потребует для своей работы наличие в нашей системе утилиты lsb_release, которая входит в состав пакета redhat-lsb. А установка пакета redhat-lsb, в свою очередь, имеет целый ворох зависимостей ( +141 Dependent packages ), необходимость присутствия которых в серверной системе остаётся под вопросом. Учитывая то, что по сути всё, что делает этот скрипт, это автоматизация добавления в систему ключа репозитория и самого репозитория HP, мы можно выполнить эти нехитрые действия самостоятельно и не использовать этот скрипт вообще. Процедура ручной настройки будет рассмотрена далее, а сейчас, исключительно в демонстрационных целях, мы таки рассмотрим пример использования этого скрипта.

Перед выполнением скрипта нам нужно будет знать имена репозиториев, которые мы хотим добавить в систему (хотя тот, кто писал скрипт, мог бы и добавить параметр с листингом возможных вариантов). Найти имена репозиториев можно на странице Project Repositories . Нас интересуют два репозитория:

- mcp — Management Component Pack for ProLiant — Agent software for Ubuntu, Oracle and community distros

- spp — Service Pack for ProLiant — Drivers and agent software for RedHat and SLES

Помимо этих двух репозиториев, нам интересен также был бы репозиторий fwpp (Firmware Pack for ProLiant), однако, как я понял, этот репозиторий для доступа требует авторизацию по токену, который в свою очередь генерируется на сайте HP и привязывается к аккаунту с действующим сервисным контрактом.

Если вас не беспокоит наличие в системе кучи ненужных пакетов, то перед запуском скрипта можно установить пакет redhat-lsb, в составе которого есть утилита lsb_release:

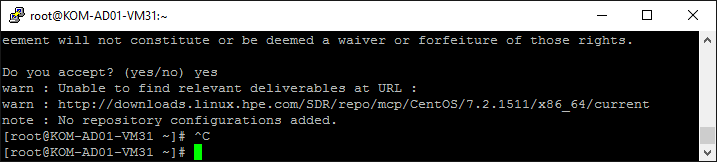

И уже с случае наличия в системе утилиты lsb_release, репозитории добавляются командами типа:

Однако использование в таком виде скрипта на текущей версии CentOS приведёт к ошибке невозможности доступа к URL, так как при формировании этого URL по умолчанию скрипт использует имя и текущую версию ОС…

Решение – использовать дополнительные параметры при вызове скрипта с указанием версии совместимой ОС. Кстати, при явном указании скрипту версии ОС через передачу параметров, можно не заморачиваться наличием утилиты lsb_release, и как следствие, необходимостью установки ненужных пакетов. Вообще скрипт имеет набор параметров и узнать их все можно командой:

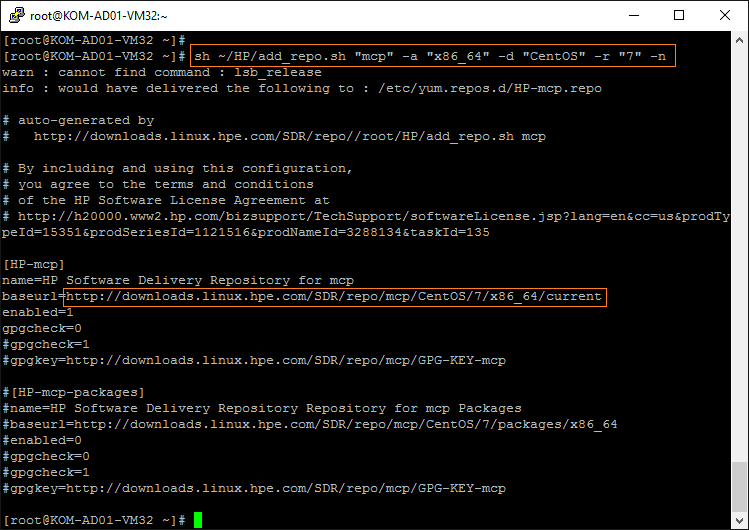

Чтобы узнать какие именно параметры может добавить скрипт в файл перечисления репозиториев yum, воспользуемся специальным ключом -n, который не делает реальных изменений в системе, а лишь показывает то, что скрипт может записать в repo-файл с переданным ему набором параметров. Например, чтобы проверить добавление репозитория «mcp» для нашей 64-битной CentOS 7.2 выполним следующий набор параметров :

Для того, чтобы проверить правильно ли скриптом сформирована ссылка к файлам репозитория «mcp«, перейдём в браузере на указанный URL и проверим существование rpm пакетов по этому пути.

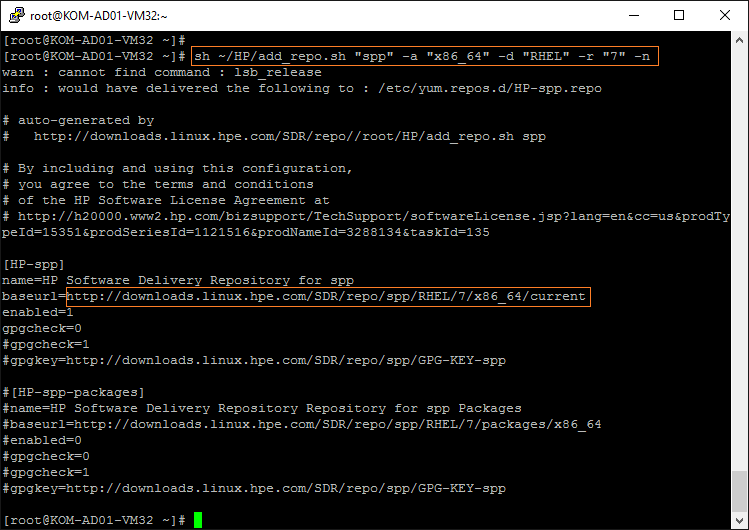

В репозитории «spp» каталога для CentOS нет, поэтому «прикинемся» RHEL аналогичной версии:

Опять же, для того, чтобы проверить правильно ли скриптом сформирована ссылка к файлам репозитория «spp«, перейдём в браузере на указанный URL и проверим существование rpm пакетов по этому пути.

Помимо подключения в качестве репозитория папки с текущей версией Service Pack for ProLiant (SPP), которая доступна по ссылке …/spp/RHEL/7/x86_64/current , для серверов старого поколения ProLiant G5 «до кучи» можно подключить в качестве дополнительного репозитория каталог с последней поддерживаемой версией SPP для G5 – …/spp/RHEL/7/x86_64/2014.06.0_supspp_rhel7.0_x86_64/

В конечном итоге, узнав всё, что нам нужно от скрипта, сделаем все необходимые изменения в системе сами в том виде, в котором считаем более удобным и правильным для себя.

Для начала скопируем в систему ключи подключаемых репозиториев HP:

Создадим в каталоге /etc/yum.repos.d/ три отдельных repo-файла описывающих подключаемые репозитории HP:

Содержимое файла HP-MCP.repo :

Содержимое файла HP-SPP-Current.repo :

Содержимое файла HP-SPP-2014-06.repo :

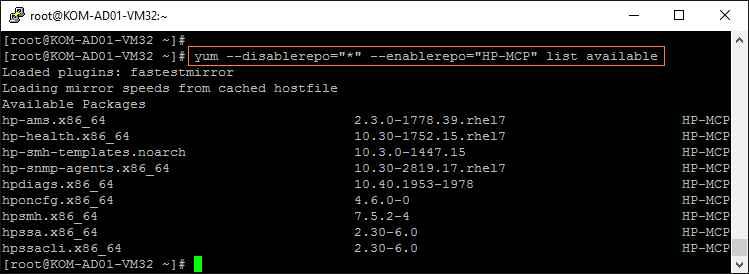

Всё, нужные нам репозитории HP можно считать подключенными. Теперь можно проверить, какие пакеты нам доступны, например, в созданном нами репозитории HP-MCP :

Как видим, пакеты доступны и теперь можно переходить к их установке.

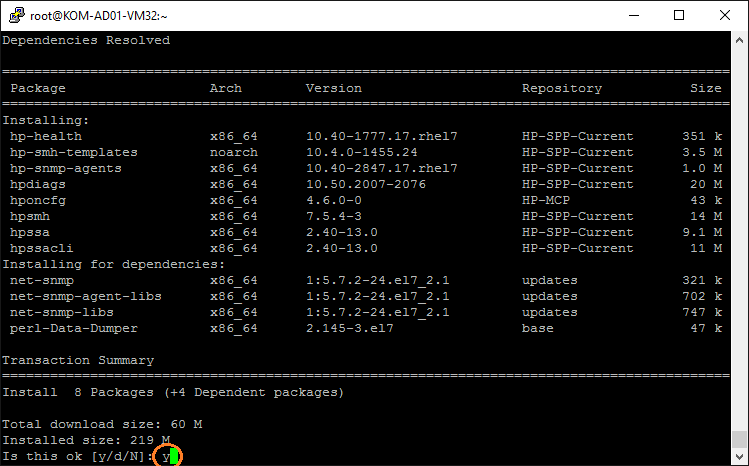

Устанавливаем утилиты управления HP

Устанавливаем нужные пакеты:

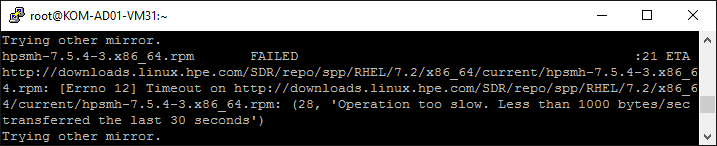

В процессе загрузки пакетов может возникнуть ошибка, так как репозитории HP отдают контент весьма загадочным образом. В таком случае просто попробуйте запустить команду повторно. Если же всё-таки закачка постоянно обрывается с предупреждениями типа » Operation too slow. Less than 1000 bytes/sec transferred the last 30 seconds «…

…то можно попробовать изменить значения по-умолчанию для таймаутов yum в файле /etc/yum.conf в секции [main]:

По умолчанию yum имеет таймаут соединения в 30 секунд (timeout). Увеличьте его, например, в 10 раз. А значение minrate определяет порог самой низкой скорости в байтах в секунду для соединения. Уменьшим значение по умолчанию (1000), например, до минимума. После того, как файлы из репозиториев HP будут загружены, значения конфигурации yum можно вернуть обратно.

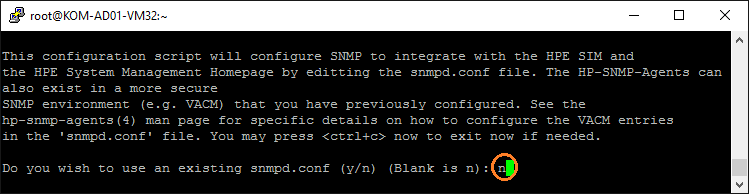

Настраиваем службу SNMP

После окончания установки запускаем утилиту, которая сконфигурирует службу snmpd для работы с HP System Management Homepage.

На первый вопрос о том, хотим ли мы использовать имеющийся конфигурационный файл snmpd.conf отвечаем отрицательно, чтобы она сама его наполнила нужным содержимым.

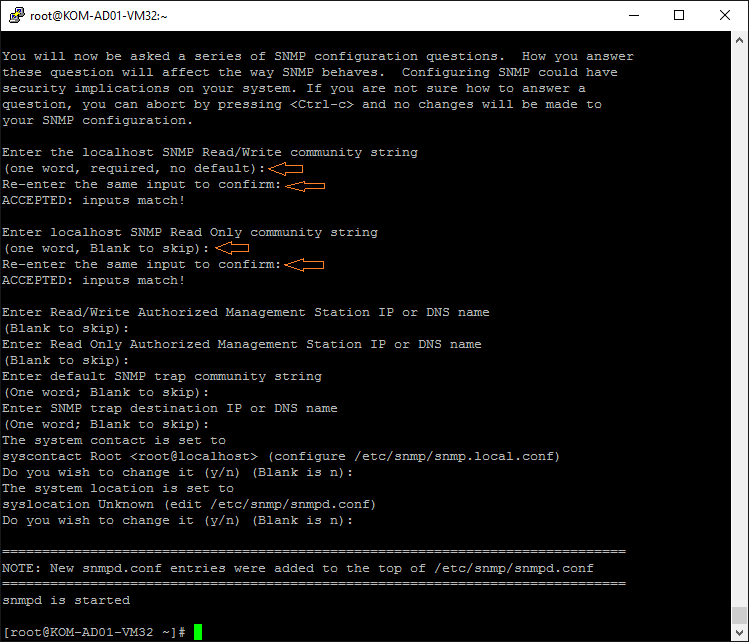

После этого утилита задаст ряд вопросов, касающихся настройки службы snmpd, на которые нам нужно будет ввести соответствующие данные. В частности, можно задать строку подключения SNMP для RW/RO доступа и т.п., хотя обязательным является только ввод строки для RW доступа, а остальные значения можно оставить ненастроенными и предлагаемыми по умолчанию, так как на данном этапе у нас служба SNMP всё равно будет использоваться только для нужд HP System Management Homepage и работать только на кольцевом интерфейсе (Loopback) с адресом 127.0.0.1.

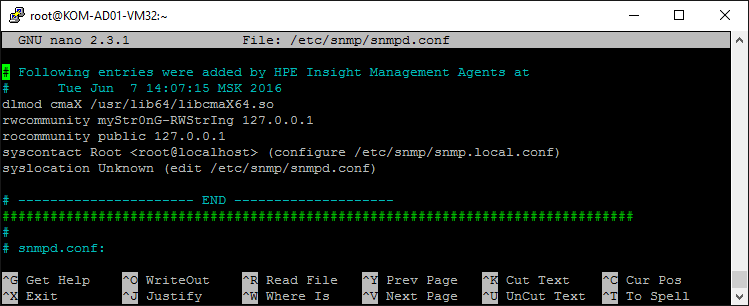

По окончанию опроса введённые данные будут записаны в конфигурационный файл /etc/snmp/snmpd.conf и служба snmpd будет запущена с этими параметрами. Если мы заглянем в файл snmpd.conf , то увидим внесённые туда изменения в начале файла:

Все остальные включённые по умолчанию параметры файла snmpd.conf , которые расположены ниже секции вписанной утилитой hpsnmpconfig, можно закомментировать. В качестве исключения я оставил лишь строку отключающую логирование, чтобы не засорять syslog.

После внесения дополнительных изменений в snmpd.conf перезапустим службу snmpd

После этого можно будет «постучаться» на наш сервер снаружи по протоколу SNMP любой утилитой, чтобы убедиться в том, что он никому снаружи на SNMP-запросы не отвечает. Для того, чтобы проверить то, что на кольцевом интерфейсе snmpd успешно отвечает на запросы поставим в систему пакет с утилитами для работы с SNMP и выполним пару таких проверок:

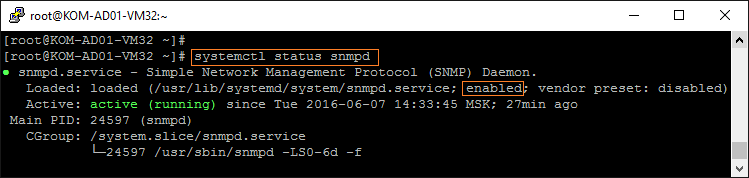

Дополнительно проверим включён ли автоматический запуск службы snmpd при запуске системы:

Если по какой-то причине автоматический запуск не включён, включаем:

Запускаем утилиты управления HP и проверяем их работу

Теперь запускаем службы HP и убеждаемся в том, что при их запуске нет никаких ошибок

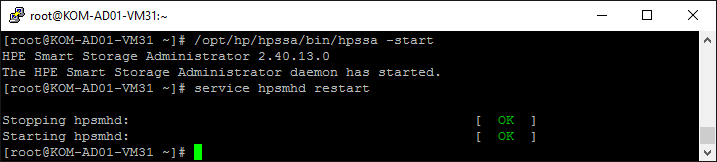

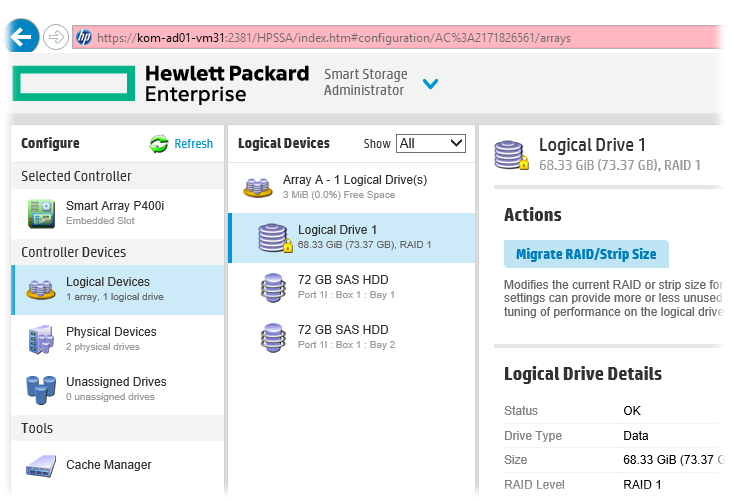

Обратите внимание на то, что по умолчанию веб-приложение HPE Smart Storage Administrator (hpssa) не запущено, так как по сути своей оно не носит характер инструмента постоянного мониторинга, и поэтому, в случае необходимости доступа к нему через веб интерфейс SMH, запускать его нужно отдельно с последующим перезапуском службы hpsmhd:

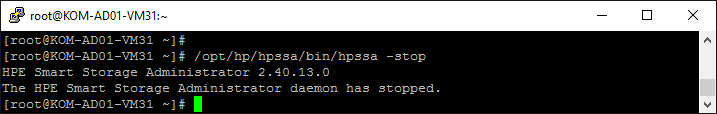

Соответственно, после того как утилита не нужна, можно выполнить остановку её службы командой:

Включим автоматический запуск служб при загрузке системы:

Теперь нам нужно настроить брандмауэр для того, чтобы работал удалённый доступ по сети к веб-странице HP System Management Homepage (для этого по умолчанию используется HTTPS на порту TCP 2381).

Создадим описание новой службы в используемом по умолчанию в CentOS 7 брандмауэре firewalld

На практике я столкнулся с ситуацией, когда на одном из серверов в процессе установки CentOS 7 по какой-то причине не был установлен firewalld. Исправить эту ситуацию можно простым способом, описанным в Вики-статье CentOS 7 -bash: firewall-cmd: command not found.

Наполним файл /etc/firewalld/services/hpsmh.xml содержимым:

Добавим информацию о службе в нужную нам зону брандмауэра и перезагрузим брандмауэр без разрыва соединений:

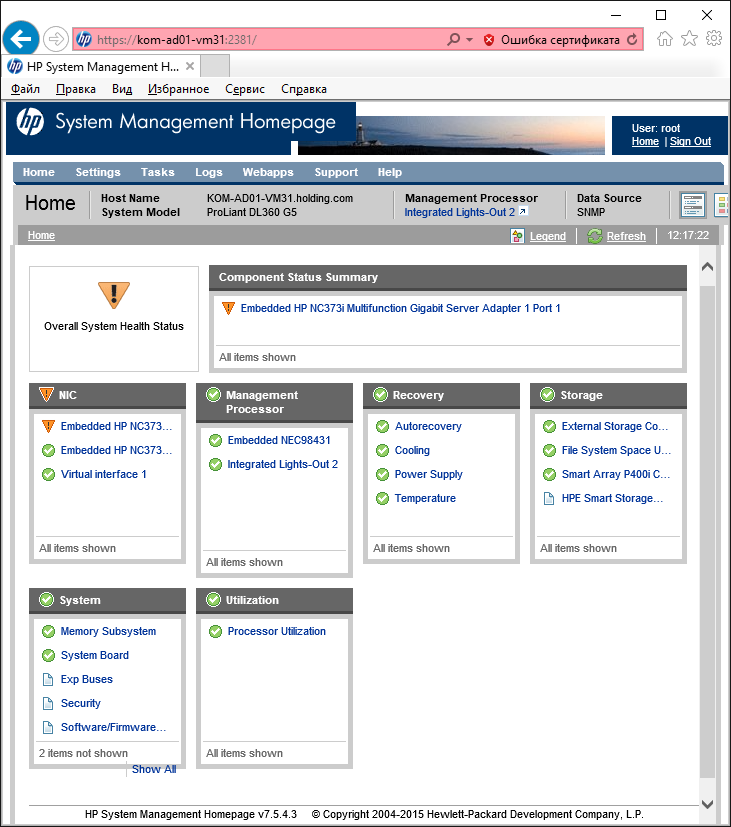

Теперь пробуем удалённо подключиться к веб-странице HP System Management Homepage через веб-браузер. После аутентификации (используем учётные данные локальной учёной записи администратора сервера) мы получим доступ к информации о текущем состоянии нашего сервера:

Если веб-приложение HPE Smart Storage Administrator (hpssa) нами ранее было запущено, то в разделе Storage нам будет доступно управление контроллером Smart Array

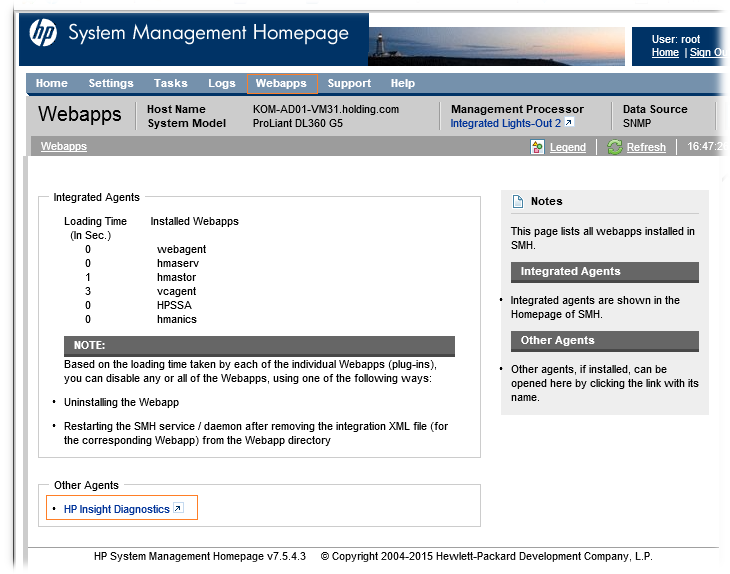

На вкладке Webapps в разделе дополнительных агентов будет доступна ссылка HP Insight Diagnostics

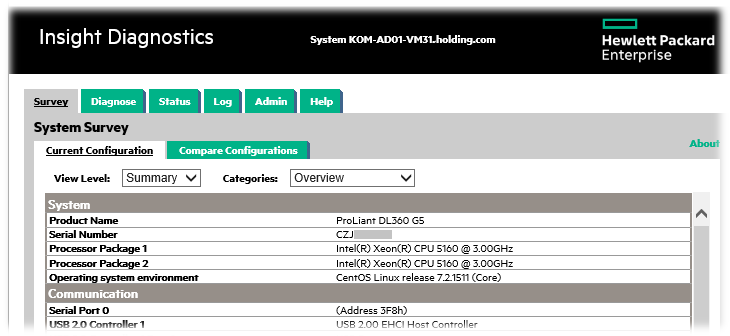

Перейдя по этой ссылке откроется отдельное веб-приложение где можно будет получить более подробную диагностическую информацию об оборудовании сервера и его текущем состоянии.

В целом на этом всё.

Дополнительно можно отметить тот факт, что на CentOS 7.2 помимо перечисленных утилит можно также установить ещё и агента репозитория VCRM — HP Version Control Agent for Linux (VCA). Текущая версия 7.3.5-0 (05.06.2015) может быть загружена отсюда :

Однако мои попытки использования агента VCA на CentOS желаемого результата не принесли, так как агент VCA не хочет брать обновления с VCRM предназначенные для RHEL, а всевозможные попытки заставить агента VCA думать то, что он на самом деле работает не на CentOS 7.2 а на RHEL 7.2, успехом не увенчались. Возможно у меня просто слишком мало опыта работы с CentOS Linux, для того, чтобы отмачивать такие трюки, а возможно и сам VCA настолько RHEL-ориентированный, что подобные трюки не помогут. В любом случае, если мне когда-нибудь удастся решить вопрос полноценной работы VCA на CentOS, то я об этом обязательно напишу отдельно.

Источник