- Элементарный Bash скрипт для резервного копирования данных

- Что должен выполнять наш скрипт?

- Скрипты бэкапа файлов из Linux в облачные хранилища

- Backup данных на OneDrive изLinux CentOS

- Резервное копирования на Google Диск.

- Скрипт бекапа на Яндекс.Диск из Linux

- Простой способ резервного копирования Linux-сервера с выгрузкой файлов по FTP

- Хозяйство

- Задача

- Решение

- Бэкап данных с btrfs и LVM bash скриптами

Элементарный Bash скрипт для резервного копирования данных

Привет хабралюди, сейчас я расскажу как можно немного автоматизировать рутиную работу по подготовке бэкапов.

В данном случае, мы не будем использовать мощные программы, или даже целые системы для резервного копирования данных, ограничимся самым доступным что у нас есть. А именно — Bash скриптом.

Что должен выполнять наш скрипт?

Бэкапить веб проект, а именно:

— Делать резервную копию базы MySQL.

— Делать резервную копию файлов.

— Структурировать это.

И так, вот наш скрипт:

#!/bin/bash

PROJNAME= #Имя проекта

CHARSET= #Кодировка базы данных (utf8)

DBNAME= #Имя базы данных для резервного копирования

DBFILENAME= #Имя дампа базы данных

ARFILENAME= #Имя архива с файлами

HOST= #Хост MySQL

USER= #Имя пользователя базы данных

PASSWD= #Пароль от базы данных

DATADIR= #Путь к каталогу где будут храниться резервные копии

SRCFILES= #Путь к каталогу файлов для архивирования

PREFIX=`date +%F` #Префикс по дате для структурирования резервных копий

#start backup

echo «[———————————[`date +%F—%H-%M`]———————————]»

echo «[———-][`date +%F—%H-%M`] Run the backup script. »

mkdir $DATADIR/$PREFIX 2> /dev/null

echo «[++———][`date +%F—%H-%M`] Generate a database backup. »

#MySQL dump

mysqldump —user=$USER —host=$HOST —password=$PASSWD —default-character-set=$CHARSET $DBNAME > $DATADIR/$PREFIX/$DBFILENAME-`date +%F—%H-%M`.sql

if [[ $? -gt 0 ]];then

echo «[++———][`date +%F—%H-%M`] Aborted. Generate database backup failed.»

exit 1

fi

echo «[++++——][`date +%F—%H-%M`] Backup database [$DBNAME] — successfull.»

echo «[++++++—-][`date +%F—%H-%M`] Copy the source code project [$PROJNAME]. »

#Src dump

tar -czpf $DATADIR/$PREFIX/$ARFILENAME-`date +%F—%H-%M`.tar.gz $SRCFILES 2> /dev/null

if [[ $? -gt 0 ]];then

echo «[++++++—-][`date +%F—%H-%M`] Aborted. Copying the source code failed.»

exit 1

fi

echo «[++++++++—][`date +%F—%H-%M`] Copy the source code project [$PROJNAME] successfull.»

echo «[+++++++++-][`date +%F—%H-%M`] Stat datadir space (USED): `du -h $DATADIR | tail -n1`»

echo «[+++++++++-][`date +%F—%H-%M`] Free HDD space: `df -h /home|tail -n1|awk ‘

echo «[++++++++++][`date +%F—%H-%M`] All operations completed successfully!»

exit 0

Запускать можно парой способов:

— Простой запуск: ./backup.sh

— Запуск + запись в лог: ./backup.sh | tee backup.log

— а еще его можно в cron запихать: 00 20 * * 7 root sh /home/bond/backup.sh | tee /home/bond/backup/backup.log

После успешного завершения скрипта, мы увидим следующее:

$ sudo sh backup.sh

[———————————[2009-02-14—12-28]———————————]

[———-][2009-02-14—12-28] Run the backup script.

[++———][2009-02-14—12-28] Generate a database backup.

[++++——][2009-02-14—12-29] Backup database [images] — successfull.

[++++++—-][2009-02-14—12-29] Copy the source code project [itmages].

[++++++++—][2009-02-14—12-29] Copy the source code project [itmages] — successfull.

[+++++++++-][2009-02-14—12-29] Stat datadir space (USED): 1,3G /home/bond/backup

[+++++++++-][2009-02-14—12-29] Free HDD space: 49G

[++++++++++][2009-02-14—12-29] All operations completed successfully!

bond@serv:

В итоге наши бэкапы складываются в каталог который вы указали, + резервные копии лежат в каталогах именованых по дате.

Источник

Скрипты бэкапа файлов из Linux в облачные хранилища

Не так давно, мы размещали статью о подключении популярных бесплатных облачных хранилищ на сервере с CentOS 7. В этой статье мы покажем, как можно использовать данные хранилища для резервного копирования данных с вашего сервера. Я использую эти скрипты для дополнительного резервного копирования файлов сайта и базы данных со своего Linux VPS сервера.

Backup данных на OneDrive изLinux CentOS

Мы будем выполнять резервное копирование сайта и базы данных, а также выполнять проверку на «возраст» бэкапа (удалять бэкапы недельной давности) и отправлять на почту отчет с полной информацией выполнения скрипта. Собственно, сам bash скрипт:

#!/bin/bash

#Копируем файлы сайта во временную директорию

rsync -avzr —progress /var/www/html/ /var/www/tmp/backup/ >> result.txt

#Выполняем дамп базы, помещаем файл дампа во временную директорию

mysqldump joomla > /var/www/tmp/backup/backup.sql

#Создаем архив временной директории

tar -cvzf backup-$(date +%y%m%d).tar.gz —absolute-names /var/www/tmp/backup/ >> result.txt

#Проверяем директорию облака на наличие старых бэкапов, если таковые есть, удаляем

find /root/OneDrive/backup/ -name «backup*.tar.gz» -mtime +7 -exec rm -f <> \; >> result.txt

#Копируем созданный ранее архив в облако

rsync -avzr —progress /root/bin/backup*.tar.gz /root/OneDrive/backup/ >> result.txt

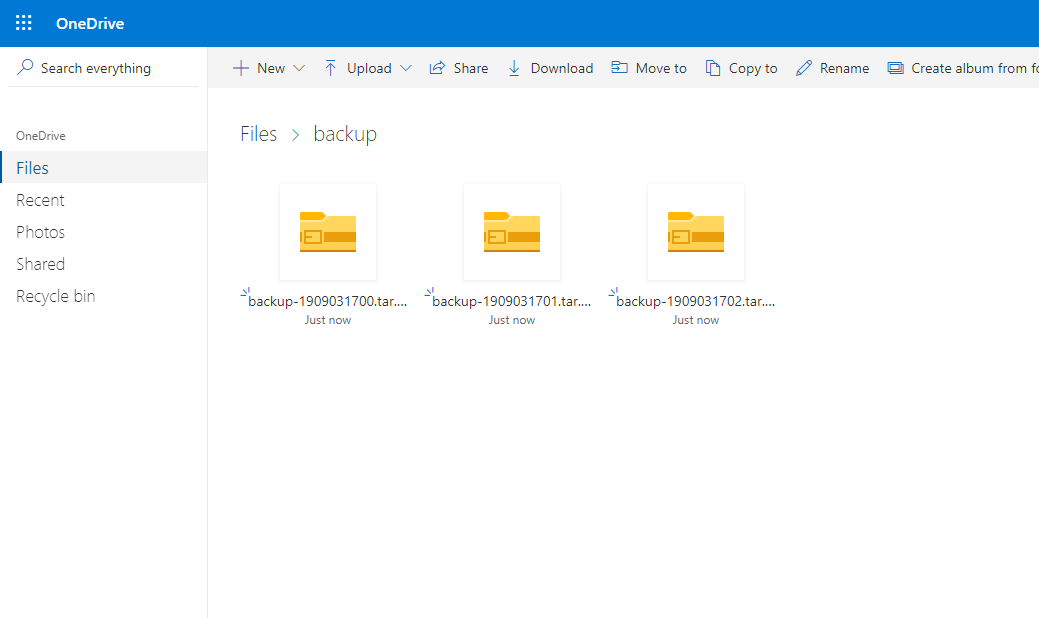

Предварительно перед написанием статьи, я создал уже несколько бэкапов, чтобы можно было продемонстрировать, что скрипт работает корректно (удаляет старые бэкапы и закачивает новые).

Я запустил 3 раза вручную. Были созданы несколько резервных копий, после чего они все успешно были отправлены в облако:

ls -la /root/OneDrive/backup/

Проверяем облако, все три архива с резервными копиями здесь:

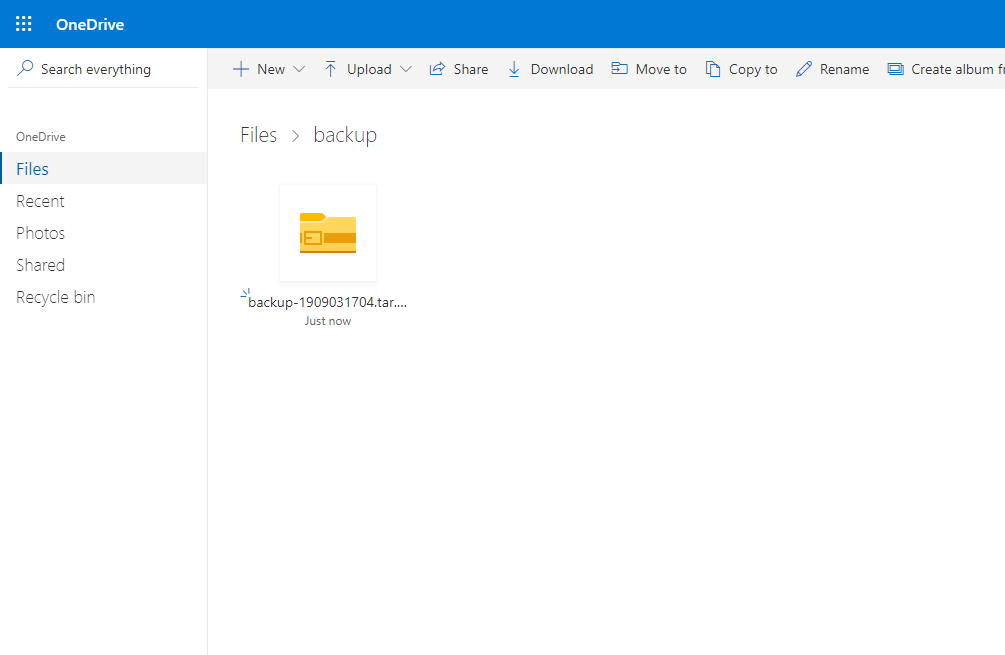

Следующим шагом, я удалил созданные резервные копии с директории на сервере и снова запустил скрипт. Вывод содержимого директории на сервере:

ls -la /root/OneDrive/backup/

Пройдя в веб-интерфейс OneDrive я увидел, что резервные копии удалили и оттуда, автоматически.

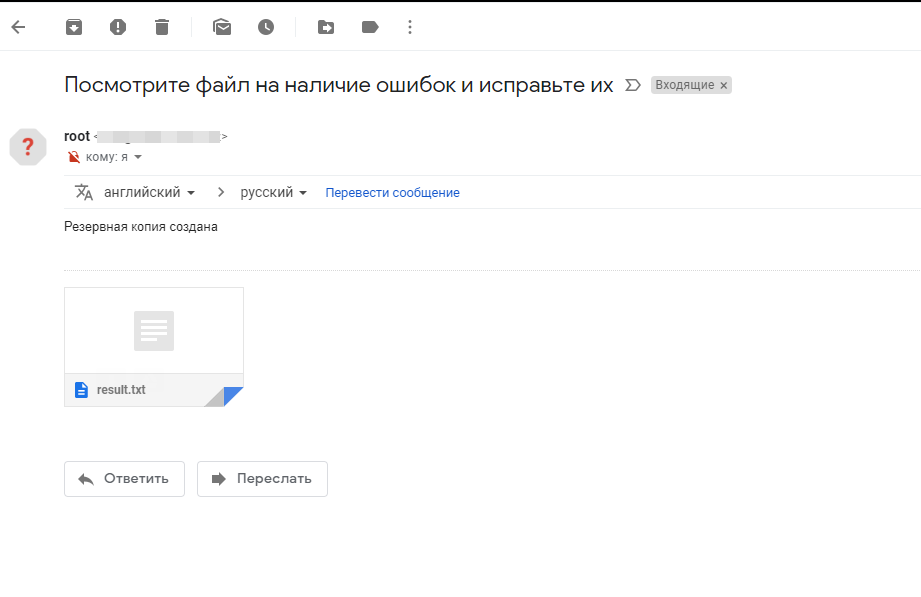

Так же после выполнения скрипта, мне пришло письмо на почту:

Резервное копирования на Google Диск.

С резервным копированием в Google Диск в се вышло не так просто как с OneDrive, хотя сама настройка довольно простая. Основная проблема возникла с удалением старых бэкапов с Google Drive, так как на сервер не монтируется директория хранилища. Но после долгого изучения справки drive help, удалось модернизировать наш уже ранее используемый скрипт.

#!/bin/bash

#удаляем файлы которые старше 7дней с g.drive

/usr/sbin/drive list -q «modifiedDate > result.txt

mysqldump joomla > /var/www/tmp/backup/backup.sql

tar -cvzf backup-$(date +%Y%m%d).tar.gz —absolute-names /var/www/tmp/backup/ >> result.txt

#закачиваем файл на g.drive

/usr/sbin/drive upload -f /root/bin/backup*.tar.gz >> result.txt

rm -rf /root/bin/backup*.tar.gz >> result.txt

echo «Посмотрите файл на наличие ошибок и исправьте их» | mail -a «/root/bin/result.txt» -s «Резервная копия создана» — ******@gmail.com

rm -rf /root/bin/result.txt

rm -rf /var/www/tmp/backup/*

Остальные шаги в скрипте я не расписывал, так как они повторяются с предыдущими.

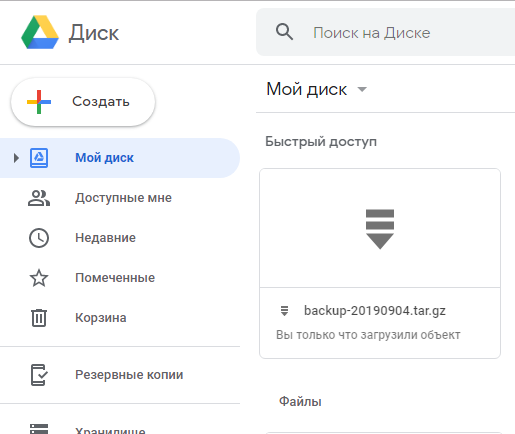

Запустив скрипт, он выполнился:

С веб-интерфейса его так же видно, как и с консоли:

Таким образом мы получаем скрипт, который выполняет проверку на наличие старых бэкапов в облаке Google Диск, удаляет их если они попадают под требования, после чего создает резервную копию сайта и отправляет ее в это же облако.

Скрипт бекапа на Яндекс.Диск из Linux

Данное облачное хранилище я оставил на закуску, так как резервное копирование в Яндекс.Диск является самым простым, т.к. мы смонтировали облачное хранилище Яндекс через WebDav как отдельное дисковое утсройство . Способ все тот же, мы запускаем скрипт, только лишь с небольшой разницей, не нужно делать синхронизацию или заливку файлов специальными командами, работаем как с обычным серверным каталогом. Синхронизация каталога выполняется с помощью rsync. Скрипт будет иметь вид:

#!/bin/bash

rsync -avzr —progress /var/www/html/ /var/www/tmp/backup/ >> result.txt

mysqldump joomla > /var/www/tmp/backup/backup.sql

tar -cvzf backup-$(date +%Y%m%d).tar.gz —absolute-names /var/www/tmp/backup/ >> result.txt

find /mnt/yad/ -name «backup*.tar.gz» -mtime +7 -exec rm -f <> \; >> result.txt

rsync -avzr —progress /root/bin/backup*.tar.gz /mnt/yad/ >> result.txt

rm -rf /root/bin/backup*.tar.gz >> result.txt

echo «Посмотрите файл на наличие ошибок и исправьте их» | mail -a «/root/bin/result.txt» -s «Резервная копия создана» — ****@gmail.com

rm -rf /root/bin/result.txt

rm -rf /var/www/tmp/backup/*

Все тоже самое, только без лишних команд. Если у вас другие пути до облачных хранилищ, меняйте в скрипте на свои.

В конце статьи хотелось бы добавить. Я разместил указанные скрипты в отдельную директорию и запускают их по крону. Если дисковое пространство на ваших облачных дисках позволяет часто создавать бэкапы, создавайте их как можно чаще, я рекомендую не реже одного раза в 3 дня. Используйте ресурсы облачных хранилищ на все 100%.

Примеры заданий в кроне:

0 0 * * 6 /root/bin/backup.sh — запускаем скрипт бэкапа каждую субботу в 00-00

0 0 */3 * * /root/bin/backup.sh — запускаем скрипт бэкапа каждые 3 дня в 00-00

И так далее, настройте бэкапы как вам удобно, когда нагрузка на сервере минимальна.

Источник

Простой способ резервного копирования Linux-сервера с выгрузкой файлов по FTP

Здравствуйте.

О важности регулярного резервного копирования уже сказано очень много слов. В этой статье мы предлагаем вниманию читателей примеры простых скриптов для бэкапа файлов и баз данных MySQL с последующей выгрузкой архивов на удаленный FTP-сервер.

Несмотря на то что мы в NQhost предлагаем решения по сохранению snapshot’ов VPS-контейнеров, процесс бэкапа собственными силами — безусловно важнейшая вещь.

Хозяйство

Виртуальный или физический сервер с установленной Linux-ОС, веб-сервером и базами данных MySQL.

Файлы веб-сервера располагаются в директориях

/home/site1

/home/site2

/home/site3

Задача

Создание скрипта для резервного копирования файлов и баз данных с сохранением на удаленном FTP-сервере и запуск его каждый день.

Решение

Для простоты примера работать мы будем из-под root`а, директория для хранения бэкапов файлов — /root/backup/server, а для дампов MySQL — /root/backup/mysql

Backup файлов

Здесь приводится пример скрипта для бэкапа файлов, для наглядности пояснения даны в квадратных скобках на русском языке.

#!/bin/sh

### System Setup ###

BACKUP=/root/backup/server

### FTP ###

FTPD=»/»

FTPU=»username» [имя пользавателя (логин) удаленного ftp-cервера]

FTPP=»megapassword» [пароль доступа к удаленному ftp-серверу]

FTPS=»my_remote_backup.ru» [собственно, адрес ftp-сервера или его IP]

### Binaries ###

TAR=»$(which tar)»

GZIP=»$(which gzip)»

FTP=»$(which ftp)»

## Today + hour in 24h format ###

NOW=$(date +%Y%m%d) [задаем текущую дату и время, чтобы итоговый файл выглядел в виде server-YYYYMMDD.tar.gz]

mkdir $BACKUP/$NOW

$TAR -cf $BACKUP/$NOW/etc.tar /etc [c целью сохранения настроек для простоты копируем весь /etc ]

$TAR -cf $BACKUP/$NOW/site1.tar /home/site1/

$TAR -cf $BACKUP/$NOW/site2.tar /home/site2/

$TAR -cf $BACKUP/$NOW/site2.tar /home/site3/

$TAR -zcvf $ARCHIVE $ARCHIVED

### ftp ###

cd $BACKUP

DUMPFILE=server-$NOW.tar.gz

$FTP -n $FTPS

Результатом работы данного скрипта будет созданный файл в директории /root/backup/server вида server-ГГГГММДД.tar.gz содержащий в себе tar-архивы директорий /etc, /home/site1, /home/site2 и /home/site3

Этот же файл будет загружен на FTP-сервер, который мы указали в начале скрипта.

Backup баз MySQL

Этим скриптом мы выгружаем базы данных MySQL (делаем т.н. «дампы). Каждая база выгружается в отдельный файл.

#!/bin/sh

# System + MySQL backup script

### System Setup ###

BACKUP=/root/backup/mysql

### Mysql ### [параметры доступа к нашим базам MySQL]

MUSER=»root»

MPASS=»megapassword»

MHOST=»localhost»

### FTP ###

FTPD=»/»

FTPU=»username» [имя пользавателя (логин) удаленного ftp-cервера]

FTPP=»megapassword» [пароль доступа к удаленному ftp-серверу]

FTPS=»my_remote_backup.ru» [собственно, адрес ftp-сервера или его IP]

### Binaries ###

TAR=»$(which tar)»

GZIP=»$(which gzip)»

FTP=»$(which ftp)»

MYSQL=»$(which mysql)»

MYSQLDUMP=»$(which mysqldump)»

## Today + hour in 24h format ###

NOW=$(date +%Y%m%d)

### Create temp dir ###

### name Mysql ###

DBS=»$($MYSQL -u $MUSER -h $MHOST -p$MPASS -Bse ‘show databases’)»

for db in $DBS

do

Источник

Бэкап данных с btrfs и LVM bash скриптами

Уже было много постов о резервном копировании, особенно много для ОС Linux. Озаботился и я настройкой резервного копирования.

Требовалось создавать бэкапы системы, данных с примонтированного раздела и LVM томов (диски виртуальных машин). Были мысли использовать Bacula, т.к. знаком с ней, но поскольку дома только 1 компьютер клиент-серверная архитектура только создавала бы дополнительные сложности при восстановлении в случае повреждения системы. Значит систему и данные просто копируем, образ LVM раздела создаем с помощью dd. Хотелось делать резервную каждый день (хотя бы данных) и хранить минимум 14 дней. Но поиски готовых и простых решений, удовлетворяющих всем потребностям не увенчались успехом. А значит берем в руки bash и пишем свой велосипед. В этой статье я делюсь тем, что вышло.

Disclaimer: при написании скриптов не было цели написать монстров, которые делают все. Нужен был простой и надежный способ бэкапа. Буду благодарен за указание неточностей и узких мест скриптов (тех, где могут возникнуть ошибки). Статья рассчитана больше на новичков в Linux, которые ищут готовое решение и на лентяев, 🙂 которым лень писать самим.

Исходные условия:

- ОС: Arch Linux

- Корневая файловая система (/): btrfs, копировать нужно все файлы.

- Раздел с данными (/mnt/data/): btrfs.

- LVM тома (/dev/virt_image_array/*).

- Раздел для бэкапов (/mnt/backup/: etx4, сюда будут складываться резервные копии.

- Необходимые утилиты (кроме входящих в базовый дистр): rsync, btrfs-progs (для управления btrfs).

Было решено раз в неделю делать полную копию всего и каждый день создавать снапшот разделов с btrfs. Можно также создавать снапшоты LVM томов, но для меня потеря данных за неделю не критична, поэтому хватит еженедельных копий.

Итак, скрипт № 1, создает копию файлов корневого раздела в /mnt/backup/root/«номер дня»/.

Скрипт № 2, создает снапшоты корневой ФС (скрипт логикой очень похож на 1й, поэтому комментировать буду только отличия). Снапшот имеет имя auto_«номер дня».

Скрипт № 3, создает копию LVM тома:

Поскольку скрипты, бэкапящие данные из /mnt/data аналогичны скриптам 1 и 2 думаю, нет необходимости их писать.

Добавляем в crontab и определяем, как часто создавать бэкапы (в моем примере бэкап создается раз в неделю, снапшоты раз в день).

Что еще можно прикрутить:

- Если нужно создавать больше бэкапов, а места нет, то можно поставить ФС с дедупликацией (например Opendedup), но снизится надежность хранения данных.

- В качестве хранилища может выступать папка подключенная по NFS или sshfs.

- Если нужно создавать бэкапы или снапшоты чаще, чем раз в день можно считать не дни с 1970 года, а часы (костыль, будет еще непонятней за какую дату бэкап).

UPD. По совету onix74 подправил скрипты.

Источник