- Бэкап Linux и восстановление его на другом железе

- 1. Создание бэкапа

- Восстановление бэкапа на другом железе

- Запасливый пингвин. Программы для резервного копирования в Linux

- Содержание статьи

- Народные мудрости

- WARNING

- Тем, кто любит помощнее

- rsync

- luckyBackup

- Back In Time

- Bacula

- Продолжение доступно только участникам

- Вариант 1. Присоединись к сообществу «Xakep.ru», чтобы читать все материалы на сайте

- 🤴 Топ 10 бесплатных программ резервного копирования для Linux

- Вступление

- Как выбрать средство резервного копирования для Linux?

- 1. Restic

- 2. Borg

- Особенности Borg

- 3. Duplicati

- Особенности Duplicati

- 4. Bacula

- 5. Bareos

- 6. Barman

- Особенности Barman

- 7. BackupPC

- Что такое BackupPC?

- Особенности BackupPC

- 8. Bup

- Крутые функции Bup, которые выделяют его среди остальных

- 9. Lsyncd

- Характеристики

- 10. Rclone

Бэкап Linux и восстановление его на другом железе

Я работаю в организации с маленьким штатом, деятельность тесно связана с IT и у нас возникают задачи по системному администрированию. Мне это интересно и частенько я беру на себя решение некоторых.

На прошлой неделе мы настраивали FreePBX под debian 7.8, нанимали фрилансера. В процессе настройки оказалось, что сервер (да, я так называю обычный PC) не хочет грузится с HDD при подключенных USB 3G модемах, которые мы используем для звонков на мобильные, колупание BIOSа не помогло. Непорядок. Решил, что нужно перенести его на другую железяку. Так появилось сразу две связанные задачи:

- сделать бэкап сервера;

- восстановить бэкап на другом железе.

Гугление не дало внятных ответов, как это сделать, пришлось собирать информацию кусками и пробовать. Всякие acronis’ы отбросил сразу, ибо не интересно.

Опыт общения с linux-системами у меня небольшой: настройка VPN сервера на open-vpn, ftp-сервера и еще пара мелочей. Сам себя я характеризую как человека умеющего читать маны и править конфиги 🙂

Ниже я описываю свой частный случай и почему я поступил именно так. Надеюсь, новичкам будет полезно, а бородатые админы улыбнутся вспомнив молодость.

Начинаем копать теорию:

Второй способ требует наличия внешнего жесткого диска объемом не меньше раздела, который архивируем. Да и что с ним потом делать, непонятно, хранить на полочке? Остановился на tar, чуть сложнее в реализации, нужно будет создать MBR, но время создания/восстановления архива существенно меньше, хранить бэкап проще, полтора гига можно закинуть в облако и скачать, когда будет нужно. Записывать его можно на ту же live-флэшку, с которой буду грузиться.

Итак, план действия:

1. Создание бэкапа

Грузимся с live-флэшки, у меня это debian-live-7.8.0-amd64-standard.

Переключаемся на root:

Монтируем раздел, который будем архивировать, у меня это sda1, чтобы случайно не наломать дров, монтируем только для чтения. Посмотреть все свои разделы можно при помощи команд ls /dev | grep sd или df -l

Наша флэшка уже примонтирована, но в режиме только чтения, нужно перемонтировать для чтения-записи, чтобы писать туда бэкап.

Все готово для создания архива

Здесь у нас параметры: c — создать архив, v — выводить информацию о процессе, z — использовать сжатие gzip, p — сохраняем данные о владельцах и правах доступа, f — пишем архив в файл, путь к файлу, —exclude — исключаем из архива каталог (я исключил каталоги с записями разговоров и каталог с бэкапами FreePBX), /mnt/ — каталог, который архивируем.

Ждем… у меня вся подготовка и создание архива заняли 10 минут. Будь флэшка быстрее, уложился бы в 7-8 минут.

Складываем архив в надежное место за пределами офиса.

Восстановление бэкапа на другом железе

2. Размечаем диск, создаем файловую систему

Грузимся с live-флэшки, у меня все та же debian-live-7.8.0.

Переключаемся на root:

Размечаем диск. Мне понравилась утилита с псевдографическим интерфейсом cfdisk. Там все просто и понятно.

Удаляем все имеющиеся разделы. Я создал два новых раздела, один на 490 Gb под / (sda1) и 10 Gb под swap (sda2) в конце диска, т.к. он практически не будет задействован. Проверим типы разделов. Который под систему должен иметь тип 83 Linux, второй — 82 Linux swap / Solaris. Помечаем системный раздел загрузочным (bootable), сохраняем изменения и выходим.

Cоздаем файловую систему на первом разделе.

3. Распаковываем архив.

Монтируем отформатированный раздел

Распаковываем архив прямо с флэшки

Параметр —same-owner — сохраняет владельцев у распаковываемых файлов, x — извлекаем из архива, v — выводить информацию о процессе, p — сохраняем права доступа, f — указываем файл, который распаковываем, C — распаковываем в категорию.

4. Создаем MBR на новом диске.

Чтобы корректно создать загрузочную запись, монтируем рабочие каталоги к нашему будущему root-каталогу, у меня это /mnt. Каталоги /dev и /proc сейчас используются live-системой, используем параметр bind, чтобы они были доступны сразу в двух местах:

Переключаемся на новую систему используя chroot:

Делаем swap-раздел для новой системы:

Подключаем его же:

Чтобы grub работал, нужно указать ему правильные UUID разделов в fstab, сейчас там прописаны разделы предыдущей системы:

Открываем второй терминал (Alt+F2) под root:

И видим текущие UUID разделов.

Вручную переписываем их в fstab переключаясь между Alt+F1 и Alt+F2. Да, муторно, но попытки копировать занимали у меня больше времени, чем переписывание. Сохраняем fstab.

Устанавливаем grub2. У меня один физический диск, поэтому ставим его на sda:

На чистый диск должно встать без ошибок. Обновляем информацию из fstab:

Возвращаемся в Live-систему:

Размонтируем все каталоги:

Если вылазят процессы, которые используют эти каталоги, убиваем их используя fuser.

Все, поехали. Грузимся с жесткого диска:

Здесь статья должна была закончиться, но у меня возникли проблемы с подключением к интернету. Сервер видит сеть, видит компьютеры в ней, но в интернет не ходит… а это как бы важно для телефонии.

5. Тестирование и устранение неполадок.

Показывет интерфейсы eth1 и lo, гугление сказало, что gateway можно прописать только подключению eth0, остальные рассчитаны только на работу внутри сети.

Похоже, отсутствие eth0 вызвано способом переноса системы. Находим файл, который отвечает за нумерацию интерфейсов, смотрим туда:

Действительно, там два активных интерфейса, определенных MAC’ами. Комментируем первый, второму прописываем eth0.

Перезапуск /etс/init.d/networking не помог, поэтому перезагружаемся:

Подключаем донглы, проверяем, все работает.

Спасибо за внимание.

Источник

Запасливый пингвин. Программы для резервного копирования в Linux

Содержание статьи

Народные мудрости

На базе Linux любят разворачивать NAS- и FTP-серверы. Для таких систем неплохо бы иметь резервную копию как минимум конфигурации, а в идеале еще и данных. Не стану читать очередную лекцию, насколько важно озаботиться резервным копированием до того, как с основным носителем информации приключится беда. Но повторю одну притчу из айтишного фольклора: люди делятся на тех, кто делает бэкапы, и тех, кто их еще не делает. С основами создания резервных копий ты можешь ознакомиться, например, в упомянутой статье, а мы не будем тратить время на теорию и сразу перейдем к делу.

WARNING

В одной статье всех существующих решений для резервного копирования не обозреть, поэтому мы рассмотрели и сравнили наиболее известные из них. Если тут нет твоей любимой программы — не обессудь.

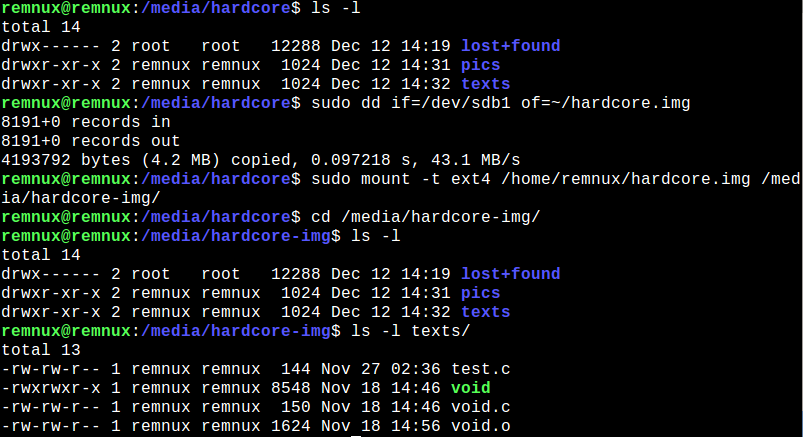

Самое что ни на есть хардкорное резервное копирование данных с носителей можно выполнить командой dd . И самое прикольное, что можно примонтировать получившийся образ и работать с ним как с обычным разделом в режиме чтения и записи. Никаких тебе DAEMON Tools или Alcohol для эмулирования дисковода.

Подобные способы подкупают своей простотой и удобством создания резервной копии. К тому же не надо беспокоиться, что слетят права и прочие атрибуты файлов или испортятся символические ссылки. Еще можно примонтировать, например, Яндекс.Диск и сразу закидывать бэкапы на него. Но это кажется удобным лишь до поры до времени, пока не требуется ставить создание бэкапов на поток, а нужно лишь снять образ с флешки или диска. Для более серьезных задач в Linux уже существует достаточное количество утилит, делающих процесс резервного копирования с последующим восстановлением почти таким же простым (ну, после некоторой подготовки), как в винде или в macOS, поэтому вместо изобретения еще одного велосипеда давай-ка лучше изучим готовые.

Тем, кто любит помощнее

Ты гик или админишь что-то посложнее сети из двух с половиной хостов? Тогда специально для тебя мы рассмотрим сперва исконно линуксовые, сложные и не всегда понятные с первой попытки программы для создания бэкапов. Начнем, пожалуй, с классики.

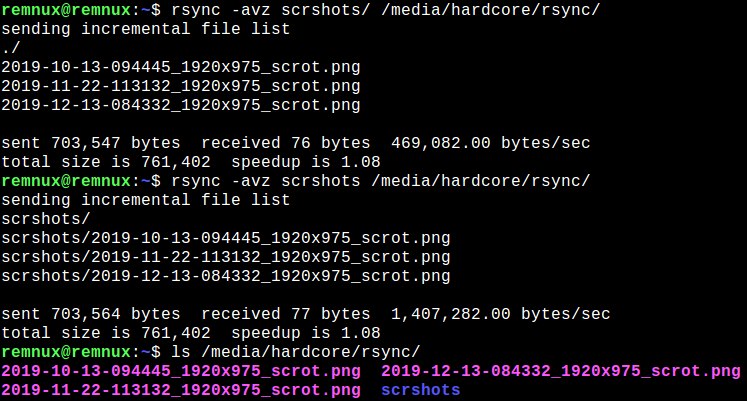

rsync

Ходят легенды, что rsync, появившаяся в 1996-м и даже портированная в 1999-м на NT, была разработана для замены rcp (remote copy). А имя ее произошло от словосочетания remote synchronization, для чего она и была предназначена.

Утилита включена во все популярные дистрибутивы Linux; существуют версии для систем BSD, macOS и Windows. Эта свободная программа с интерфейсом командной строки предоставляет широкие возможности синхронизации локальных и удаленных файлов с использованием собственного алгоритма, уменьшающего объем пересылаемого трафика. Она применяется для создания зеркал и резервных копий — полных, инкрементных и при желании (вот один из гайдов) дифференциальных. Для автоматизации можно настроить расписание с помощью задач cron . При передаче на удаленные хосты rsync умеет использовать разный транспорт, в том числе rsh, SSH и сырые сокеты с собственным протоколом rsync. Можно указывать, какие файлы не следует синхронизировать, перечислив их имена, размер и не только; можно ограничивать скорость передачи данных и использовать множество других настроек.

Rsync позволяет создать демон, своего рода удаленный сервер rsync, который также можно сконфигурировать совершенно по-разному в зависимости от поставленной задачи. Он может принимать удаленные соединения анонимно, по паролю и без, с шифрованием по SSH на заданном порте с использованием ключей, с разными конфигурациями для разных пользователей, создаваемых в рамках rsync. При всем этом для успешного общения двух узлов демон rsync необязателен: разница между использованием демона и работой без него разъясняется на сайте проекта.

Опции настройки демона описаны в man rsyncd.conf , а примеры использования программы также представлены на сайте.

В мануале описано множество нюансов работы с этим мощным инструментом, таких как обработка символических ссылок и атрибутов файлов, опции удаления файлов при обновлении директорий, параметры пересылки данных и многое другое, что и в голову так просто не придет. В общем, в любой непонятной ситуации — RTFM!

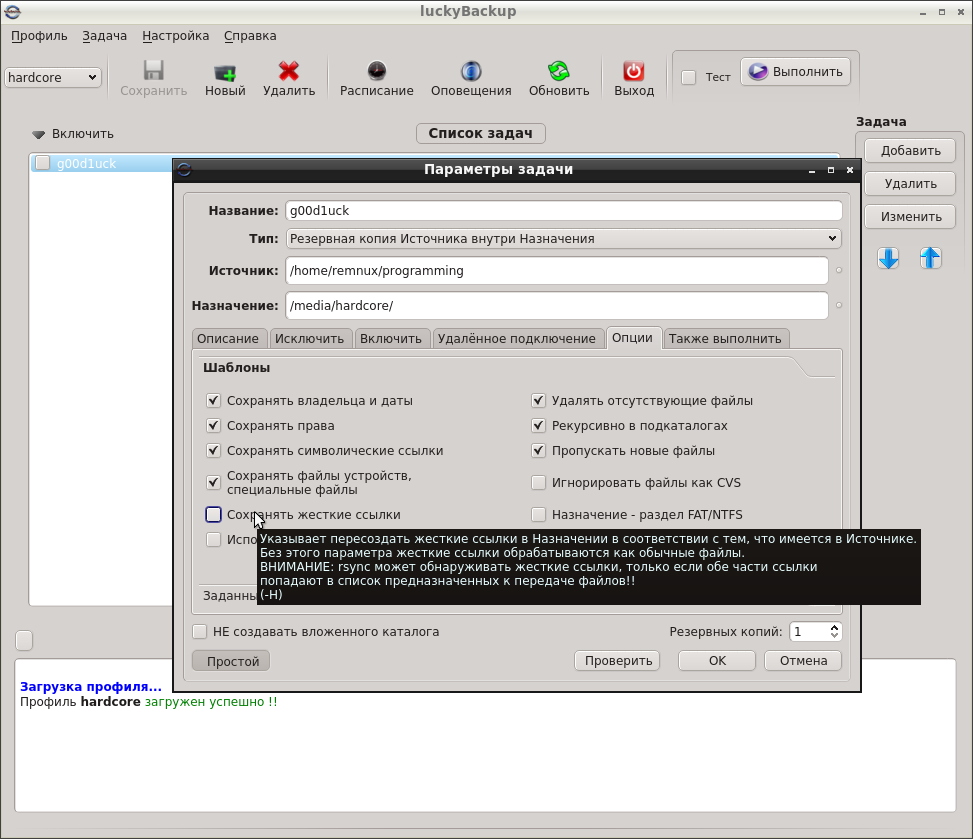

luckyBackup

Графическая утилита, построенная на основе rsync. LuckyBackup умеет делать резервные копии и выполнять синхронизацию, работать с удаленными хостами и экономить трафик, передавая лишь изменения в данных, гибко настраивается (ну еще бы, ведь это потомок rsync). Внезапно (для меня) поддерживает русский интерфейс.

Для резервного копирования в luckyBackup создаются профили, внутри которых можно довольно тонко определить задачи:

- тип (бэкап или синхронизация) и описание задачи;

- правила копирования определенных директорий: настройка исключений по шаблонам, можно задать их самостоятельно или использовать имеющиеся; включений, которые должны быть обязательно скопированы;

- настроить использование удаленного узла в качестве источника или места назначения, с SSH или без;

- сохранение метаданных файлов, обработка ссылок и специальных файлов, в том числе по пользовательским шаблонам;

- команды оболочки, которые необходимо выполнить до или после исполнения задачи;

- можно просмотреть команду rsync , которая будет запущена для выполнения созданной задачи.

Задачи можно включать или отключать, тыкая курсором мыши в чекбокс рядом с ее названием. Профили можно экспортировать (почему бы не забэкапить профиль программы бэкапа?). Контекстная справка при наведении курсора помогает простому смертному не затеряться в расширенных опциях.

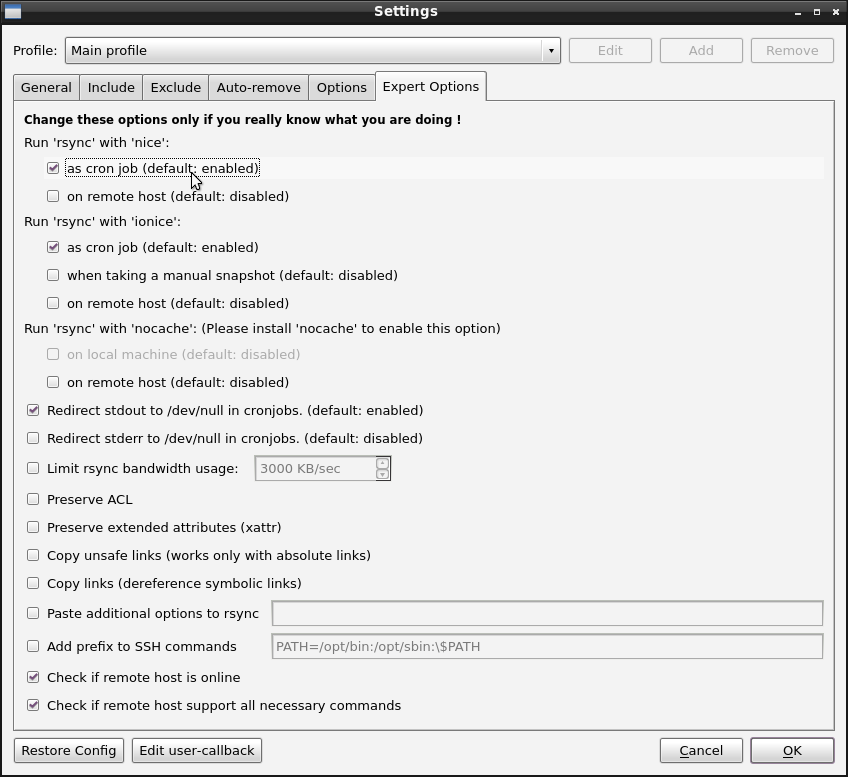

Back In Time

Утилита с набором функций, очень похожим на luckyBackup. Тоже поддерживает профили, но экспортировать их нельзя, и внутри них нет задач — здесь профиль и есть задача.

Back In Time может использоваться в консольном или GUI-исполнении. Предлагает обычные или шифрованные EncFS копии, которые могут храниться локально или передаваться по SSH. Позволяет создавать бэкапы по дням и по часам, при включении компьютера и при подключении устройств, для чего использует cron или правила udev .

Можно настроить удаление старых бэкапов по их возрасту и количеству свободного места или инод (inodes). Да-да, иноды тоже могут закончиться, и тогда ты не сможешь создать файл, даже если есть место на диске. Вкладка Expert Options содержит набор расширенных опций для rsync . Бэкапы утилита сохраняет в виде архивов.

Bacula

Опенсорсный монстр для резервного копирования. Его можно собрать из исходников, однако готовые пакеты последних версий с сайта разработчиков просто так не получишь. Bacula обещает мощную функциональность — программа не в последнюю очередь ориентирована на работу в крупных компьютерных сетях и вообще на масштабирование; она умеет делать все три вида бэкапов. Имеются версии для Windows (есть даже клиент под Win98!), macOS и Open/NetBSD.

Продолжение доступно только участникам

Вариант 1. Присоединись к сообществу «Xakep.ru», чтобы читать все материалы на сайте

Членство в сообществе в течение указанного срока откроет тебе доступ ко ВСЕМ материалам «Хакера», позволит скачивать выпуски в PDF, отключит рекламу на сайте и увеличит личную накопительную скидку! Подробнее

Источник

🤴 Топ 10 бесплатных программ резервного копирования для Linux

Вступление

Резервное копирование – это один из важнейших способов защиты вашего бизнеса от полной катастрофы в случае серьезного сбоя или случайного удаления ваших ценных данных.

Резервное копирование – это надежный метод аварийного восстановления, и, поскольку он практически обязателен, в этой статье представлен список простых в использовании инструментов резервного копирования, которые вы можете использовать.

Тут анализируются их особенности и что они могут предложить.

Не стесняйтесь попробовать любой из этих инструментов, который соответствует вашим потребностям.

Как выбрать средство резервного копирования для Linux?

1. Restic

Restic, написанный на языке программирования Go, – это открытая, быстрая, безопасная и кроссплатформенная программа резервного копирования. Этот инструмент резервного копирования шифрует данные с помощью AES-256 в режиме счетчика и аутентифицирует их, используя код аутентификации криптографических сообщений Poly1305-AES.

Более подробно мы его рассмотрели ранее:

2. Borg

В качестве программы резервного копирования с дедупликацией Borg стремится обеспечить эффективный и безопасный способ резервного копирования данных.

К вашему сведению: дедупликация данных – это метод устранения дублирующих копий повторяющихся данных.

Поскольку для резервного копирования данных используется метод дедупликации, это делает Borg пригодным для ежедневного резервного копирования, поскольку сохраняются только изменения.

Особенности Borg

Borg – это бесплатное программное обеспечение с открытым исходным кодом: оно лицензировано по лицензии BSD (3 пункт)

Быстрая и простая установка на нескольких платформах – резервное копирование Borg может выполняться на: Linux, Mac OS X, FreeBSD, OpenBSD и NetBSD (пока нет поддержки xattrs / ACL или бинарных файлов), Cygwin (экспериментальный, еще нет бинарных файлов), подсистема Linux Windows 10 (экспериментальный).

Поддержка сжатия: Если вам необходимо сжать резервную копию, что является необязательным, вам будет интересно узнать, что все данные могут быть сжаты с помощью следующих утилит: zlib (средняя скорость и сжатие), lzma (низкая скорость, высокая степень сжатия), lz4 (супер быстрая, низкая компрессия), zstd (широкий диапазон от высокой скорости и низкой компрессии до высокой компрессии и низкой скорости).

Поддержка бэкэндов удаленных хостов: инструмент резервного копирования Borg может хранить данные на любом удаленном хосте, доступном через Secure Shell (SSH). Если Borg установлен на удаленном хосте, можно добиться большого прироста производительности по сравнению с использованием сетевой файловой системы, такой как nfs и другие.

Безопасность: данные на стороне клиента могут быть зашифрованы с использованием 256-битного алгоритма шифрования AES. Проверка тех же зашифрованных данных может быть выполнена с использованием HMAC-SHA256

Скорость: локальное кэширование данных индекса файлов / чанков, быстрое обнаружение неизмененных файлов, C / Cython используется в критически важном для производительности коде, таком как чанкинг, сжатие и шифрование.

Эффективное хранилище. Как уже указывалось ранее, Borg – это программа резервного копирования с дедупликацией. Что удивительно, так это то, что при дедупликации учитываются все фрагменты в одном и том же репозитории, независимо от того, приходят ли они с разных машин, из предыдущих резервных копий, из одной и той же резервной копии или даже из одного и того же файла.

В отличие от других методов дедупликации, Borg не зависит от следующего:

- имена файлов / каталогов остаются прежними: так что вы можете перемещать свои вещи без сбоев дедупликации, даже между машинами с общим репо.

- Полные файлы или отметки времени остаются неизменными: если большой файл немного изменяется, необходимо сохранить только несколько новых фрагментов – это отлично подходит для виртуальных машин или сырых дисков.

- Абсолютная позиция фрагмента данных внутри файла: материал может быть сдвинут и все равно будет найден алгоритмом дедупликации.

3. Duplicati

Duplicati является одним из многих клиентов резервного копирования, который является бесплатным, c открытым исходным кодом и надежно хранит зашифрованные, инкрементные, сжатые резервные копии в облачных хранилищах и на удаленных файловых серверах.

Этот инструмент для резервного копирования поддерживает философию обеспечения безопасности данных, их хранения на большом расстоянии и регулярного обновления резервных копий.

Duplicati имеет встроенный планировщик, поэтому с ним легко создавать регулярные и актуальные резервные копии.

Особенности Duplicati

- Интегрированный апдейтер уведомляет вас о выходе новой версии

- Duplicati использует шифрование AES-256 (или GNU Privacy Guard) для защиты всех данных перед их загрузкой.

- Duplicati изначально загружает полную резервную копию, а затем сохраняет небольшие инкрементные обновления для экономии пропускной способности и дискового пространства.

- Планировщик автоматически поддерживает актуальность резервных копий.

- Зашифрованные файлы резервных копий передаются на такие цели, как FTP, Cloudfiles, WebDAV, SSH (SFTP), Amazon S3 и другие.

- Duplicati позволяет создавать резервные копии папок, документы таких типов, как, например, документы или изображения, или пользовательские правила фильтрации.

- Duplicati доступен в виде приложения с простым в использовании пользовательским интерфейсом и в качестве инструмента командной строки.

- Duplicati может создавать правильные резервные копии открытых или заблокированных файлов, используя службу моментальных снимков томов (VSS) под Windows или диспетчер логических томов (LVM) под Linux. Это позволяет Duplicati создавать резервные копии файла Microsoft Outlook PST во время работы Outlook.

- Duplicati использует шифрование AES-256 (или GNU Privacy Guard) для защиты всех данных перед их загрузкой. Поэтому ваши данные защищены от плохих парней.

- Duplicati изначально загружает полную резервную копию, а затем сохраняет небольшие инкрементные обновления для экономии пропускной способности и дискового пространства.

- Планировщик автоматически поддерживает актуальность резервных копий.

- Большое энтузиастическое сообщество готово помочь вам в случае любых ошибок и проблем.

4. Bacula

Bacula – это инструмент резервного копирования, который можно использовать для управления резервным копированием, восстановлением и проверкой компьютерных данных в сети компьютеров разных типов или на одном сервере.

Bacula имеет возможность резервного копирования на различные типы носителей, включая ленту и диск.

Более подробно мы рассмотрели его ранее:

5. Bareos

Со своей стороны Bareos (Backup Archiving Recovery Open Sourced) представляет собой надежное межсетевое программное обеспечение с открытым исходным кодом для резервного копирования, архивирования и восстановления данных для всех хорошо зарекомендовавших себя операционных систем.

Более подробно он был рассмотрен ранее в нескольких наших статьях:

6. Barman

Barman (Backup and Recovery Manager) – это инструмент администрирования с открытым исходным кодом для аварийного восстановления серверов PostgreSQL, написанный на Python (pgbarman.org, 2019).

Barman позволяет организациям выполнять удаленное резервное копирование нескольких серверов в критически важных для бизнеса средах и помогает администраторам баз данных на этапе восстановления.

Особенности Barman

Barman имеет очень много функций, которые постоянно востребованы клиентами, включая следующие:

- Полное “горячее” физическое резервное копирование сервера PostgreSQL

- Восстановление в определенный момент времени (PITR)

- Управление несколькими серверами PostgreSQL одновременно

- Удаленное резервное копирование через rsync / SSH или pg_basebackup (включая режим ожидания 9.2+)

- Поддержка как локального, так и удаленного (через SSH) восстановления

- Поддержка архивации и потоковой передачи WAL

- Поддержка синхронной потоковой передачи WAL («нулевая потеря данных», RPO = 0)

- Инкрементное резервное копирование и восстановление

- Параллельное резервное копирование и восстановление

- Центр файлов WAL для расширенной интеграции с резервными серверами

- Управление политиками хранения резервных копий и файлов WAL

- Состояние сервера и информация

- Сжатие файлов WAL (bzip2, gzip или custom)

- Управление базовыми резервными копиями и файлами WAL через каталог

- Простой файл конфигурации INI

- Полностью написан на Python

- Перемещение PGDATA и табличных пространств во время восстановления

- Общая информация и информация об использовании резервных копий

- Диагностика сервера для резервного копирования

- Интеграция со стандартными инструментами архивации (например, tar)

- Pre / Post скрипты хуков резервного копирования

- Локальное хранилище метаданных

7. BackupPC

Что такое BackupPC?

BackupPC – это высокопроизводительная система корпоративного уровня для резервного копирования компьютеров, ноутбуков и компьютеров под управлением Linux, Windows и macOS на диск сервера.

BackupPC легко настраивается и прост в установке и обслуживании (backuppc.github.io, 2019)

Особенности BackupPC

- Дедупликация данных: идентичные файлы в нескольких резервных копиях одного и того же или разных компьютеров хранятся только один раз, что приводит к значительной экономии дискового пространства и дискового ввода-вывода

- Открытый исходный код

- Веб-интерфейс позволяет администраторам просматривать файлы журналов, конфигурацию, текущее состояние и позволяет пользователям запускать и отменять резервные копии, а также просматривать и восстанавливать файлы из резервных копий.

- Никакого программного обеспечения на стороне клиента не требуется. Стандартный протокол smb используется для извлечения данных резервного копирования на клиентах Windows. На клиентах Linux для резервного копирования данных используется tar over ssh / rsh / nfs. В версии 2.0.0 rsync также поддерживается на любом клиенте с rsync или rysncd.

- Мощный пользовательский веб-интерфейс (http / cgi) позволяет администраторам просматривать файлы журналов, конфигурацию, текущее состояние и позволяет пользователям запускать и отменять резервные копии, а также просматривать и восстанавливать файлы из резервных копий.

- Поддерживается полный набор параметров восстановления, включая прямое восстановление (через smbclient, tar или rsync / rsyncd) или загрузку файлов zip или tar.

- Поддерживает мобильные среды, где ноутбуки только периодически подключаются к сети и имеют динамические IP-адреса (DHCP).

- Гибкие параметры конфигурации позволяют выполнять несколько резервных копий параллельно, указание, какие общие ресурсы для резервного копирования, какие каталоги для резервного копирования или нет, различные расписания для полного и инкрементного резервного копирования, расписания для напоминаний по электронной почте пользователям и так далее. Параметры конфигурации могут быть установлены для всей системы или для каждого ПК.

- Пользователям отправляются периодические напоминания по электронной почте, если их компьютер не был недавно скопирован. Содержание электронной почты, сроки и политики настраиваются.

- Протестировано на хостах Linux, Freenix и Solaris, а также на клиентах Linux, Windows 95, 98, 2000 и XP.

- Дополнительная поддержка сжатия еще больше сокращает объем дискового пространства.

- Умная схема пула минимизирует дисковое хранилище и дисковый ввод-вывод (Источник backuppc.github.io, 2019)

8. Bup

Со своего основного сайта документации:

Bup – очень эффективная система резервного копирования, основанная на формате git packfile, обеспечивающая быстрое инкрементное сохранение и глобальную дедупликацию (среди файлов и внутри файлов, включая образы виртуальных машин) https://bup.github.io, 2019.

Крутые функции Bup, которые выделяют его среди остальных

- Он использует алгоритм скользящей контрольной суммы (аналогично rsync) для разделения больших файлов на куски. Это выгодно потому, что вы можете постепенно создавать резервные копии образов дисков, баз данных и файлов XML огромных виртуальных машин.

- Он использует формат packfile из git (система контроля версий с открытым исходным кодом), поэтому вы можете получить доступ к сохраненным данным, даже если вам не нравится пользовательский интерфейс bup.

- Он написан на Python (с некоторыми частями C, чтобы сделать его быстрее), поэтому вам легко расширять и поддерживать.

- Bup может использовать избыточность «par2» для восстановления поврежденных резервных копий, даже если на вашем диске обнаружены поврежденные сектора.

- Вы можете выполнить резервное копирование непосредственно на удаленный сервер bup, не требуя тонны временного дискового пространства на резервном компьютере

- Вы можете возобновить резервное копирование, если оно было прервано

- В отличие от git, он записывает упаковочные файлы напрямую (вместо отдельной стадии сборки / переупаковки мусора), поэтому работает быстро даже с огромными объемами данных.

- Данные «автоматически» распределяются между инкрементными резервными копиями без необходимости знать, какая резервная копия основана на какой другой.

9. Lsyncd

Разработанный для синхронизации медленно меняющегося дерева локальных каталогов с удаленным зеркалом, Lsyncd использует интерфейс событий файловой системы (inotify или fsevents) для отслеживания изменений в локальных файлах и каталогах.

Lsyncd сопоставляет эти события в течение нескольких секунд, а затем запускает один или несколько процессов для синхронизации изменений в удаленной файловой системе.

По умолчанию используется метод синхронизации rsync.

Характеристики

- Lsyncd – это легкое решение для “живого” зеркала.

- Lsyncd сравнительно прост в установке

- Lsyncd не требует новых файловых систем или блочных устройств

- В отличие от rsync, Lysncd не снижает производительность локальной файловой системы.

10. Rclone

Rclone («rsync для облачного хранилища») – это программа командной строки для синхронизации файлов и каталогов между различными поставщиками облачного хранилища.

Он поддерживает облачные провайдеры, такие как Amazon S3, Amazon Drive, Box, Ceph, DigitalOcean Spaces, Dropbox, Google Cloud Storage, Google Drive, Mega и многие другие.

Источник