- Linux x64 (AMD64/EM64T) Display Driver

- Linux x64 (AMD64/EM64T) Display Driver

- dipsywong98 / Installing Ubuntu on Nvidia RTX2060 Laptop.md

- Linux Linux + RTX + разгон

- Artful

- Обзор Nvidia GeForce RTX 2060: новые технологии приходят в среднебюджетный сегмент

- Оглавление

- Теоретическая часть: особенности архитектуры

- Архитектурные особенности

- Особенности видеокарты

- Характеристики карты

- Память

- Особенности карты и сравнение с GTX 1070 Ti

- Охлаждение и нагрев

- Комплект поставки и упаковка

- Синтетические тесты

- Выводы по теоретической части и синтетическим тестам

- Игровые тесты

- Конфигурация тестового стенда

- Список инструментов тестирования

- Рейтинг iXBT.com

- Рейтинг полезности

- Выводы

Linux x64 (AMD64/EM64T) Display Driver

Linux x64 (AMD64/EM64T) Display Driver

| Version: | 415.27 | |

| Release Date: | 2019.1.15 | |

| Operating System: | Linux 64-bit | |

| Language: | English (US) | |

| File Size: | 103.38 MB | |

| ||

Vulkan with flipping enabled on Quadro cards can lead to graphic corruption. — Disable flipping in nvidia-settings (uncheck «Allow Flipping» in the «OpenGL Settings» panel) Note that many Linux distributions provide their own packages of the NVIDIA Linux Graphics Driver in the distribution’s native package management format. This may interact better with the rest of your distribution’s framework, and you may want to use this rather than NVIDIA’s official package. Also note that SuSE users should read the SuSE NVIDIA Installer HOWTO before downloading the driver. Installation instructions: Once you have downloaded the driver, change to the directory containing the driver package and install the driver by running, as root, sh ./NVIDIA-Linux-x86_64-415.27.run One of the last installation steps will offer to update your X configuration file. Either accept that offer, edit your X configuration file manually so that the NVIDIA X driver will be used, or run nvidia-xconfig Note that the list of supported GPU products is provided to indicate which GPUs are supported by a particular driver version. Some designs incorporating supported GPUs may not be compatible with the NVIDIA Linux driver: in particular, notebook and all-in-one desktop designs with switchable (hybrid) or Optimus graphics will not work if means to disable the integrated graphics in hardware are not available. Hardware designs will vary from manufacturer to manufacturer, so please consult with a system’s manufacturer to determine whether that particular system is compatible. See the README for more detailed instructions. NVIDIA TITAN RTX, NVIDIA TITAN V, NVIDIA TITAN Xp, NVIDIA TITAN X (Pascal), GeForce GTX TITAN X, GeForce GTX TITAN, GeForce GTX TITAN Black, GeForce GTX TITAN Z GeForce RTX 20 Series: GeForce RTX 2080 Ti, GeForce RTX 2080, GeForce RTX 2070, GeForce RTX 2060 GeForce MX100 Series (Notebook): GeForce MX150, GeForce MX130, GeForce MX110 GeForce 10 Series: GeForce GTX 1080 Ti, GeForce GTX 1080, GeForce GTX 1070 Ti, GeForce GTX 1070, GeForce GTX 1060, GeForce GTX 1050 Ti, GeForce GTX 1050, GeForce GT 1030 GeForce 10 Series (Notebooks): GeForce GTX 1080, GeForce GTX 1070, GeForce GTX 1060, GeForce GTX 1050 Ti, GeForce GTX 1050 GeForce 900 Series: GeForce GTX 980 Ti, GeForce GTX 980, GeForce GTX 970, GeForce GTX 960, GeForce GTX 950 GeForce 900M Series (Notebooks): GeForce GTX 980, GeForce GTX 980M, GeForce GTX 970M, GeForce GTX 965M, GeForce GTX 960M, GeForce GTX 950M, GeForce 945M, GeForce 940MX, GeForce 930MX, GeForce 920MX, GeForce 940M, GeForce 930M, GeForce 920M, GeForce 910M GeForce 800M Series (Notebooks): GeForce GTX 880M, GeForce GTX 870M, GeForce GTX 860M, GeForce GTX 850M, GeForce 845M, GeForce 840M, GeForce 830M, GeForce 825M, GeForce 820M, GeForce 810M GeForce 700 Series: GeForce GTX 780 Ti, GeForce GTX 780, GeForce GTX 770, GeForce GTX 760, GeForce GTX 760 Ti (OEM), GeForce GTX 750 Ti, GeForce GTX 750, GeForce GTX 745, GeForce GT 740, GeForce GT 730, GeForce GT 720, GeForce GT 710 GeForce 700M Series (Notebooks): GeForce GTX 780M, GeForce GTX 770M, GeForce GTX 765M, GeForce GTX 760M, GeForce GT 755M, GeForce GT 750M, GeForce GT 745M, GeForce GT 740M, GeForce GT 735M, GeForce GT 730M, GeForce GT 720M, GeForce 710M GeForce 600 Series: GeForce GTX 690, GeForce GTX 680, GeForce GTX 670, GeForce GTX 660 Ti, GeForce GTX 660, GeForce GTX 650 Ti BOOST, GeForce GTX 650 Ti, GeForce GTX 650, GeForce GTX 645, GeForce GT 640, GeForce GT 635, GeForce GT 630 GeForce 600M Series (Notebooks): GeForce GTX 680MX, GeForce GTX 680M, GeForce GTX 675MX, GeForce GTX 670MX, GeForce GTX 660M, GeForce GT 650M, GeForce GT 645M, GeForce GT 640M, GeForce GT 640M LE Quadro RTX Series: Quadro RTX 6000, Quadro RTX 5000, Quadro RTX 4000 Quadro GV100, Quadro GP100, Quadro P6000, Quadro P5200, Quadro P5000, Quadro P4000, Quadro P2000, Quadro P1000, Quadro P620, Quadro P600, Quadro P400, Quadro M6000 24GB, Quadro M6000, Quadro M5000, Quadro M4000, Quadro M2000, Quadro K6000, Quadro K5200, Quadro K5000, Quadro K4000, Quadro K4200, Quadro K2200, Quadro K2000, Quadro K2000D, Quadro K1200, Quadro K620, Quadro K600, Quadro K420, Quadro 410 Quadro Series (Notebooks): Quadro P5200, Quadro P5000, Quadro P4200, Quadro P3200, Quadro P4000, Quadro P3000, Quadro P2000, Quadro P1000, Quadro P600, Quadro P500, Quadro M2200, Quadro M1200, Quadro M620, Quadro M520, Quadro M5500, Quadro M5000M, Quadro M4000M, Quadro M3000M, Quadro M2000M, Quadro M1000M, Quadro M600M, Quadro M500M, Quadro K5100M, Quadro K5000M, Quadro K4100M, Quadro K4000M, Quadro K3100M, Quadro K2200M, Quadro K2100M, Quadro K3000M, Quadro K2000M, Quadro K1100M, Quadro K1000M, Quadro K620M, Quadro K610M, Quadro K510M, Quadro K500M Quadro Blade/Embedded Series : Quadro P5000, Quadro P3000, Quadro M5000 SE, Quadro M3000 SE, Quadro K3100M Quadro NVS Series: NVS 810, NVS 510 Quadro Sync Series: Quadro Sync II, Quadro Sync, Quadro G-Sync II Источник dipsywong98 / Installing Ubuntu on Nvidia RTX2060 Laptop.mdInstalling Ubuntu on my Nvidia RTX2060 Laptop (Lenovo Legion Y7000SE) Procrastinated for three years, I finally decided to buy my very first «first-hand» computer. Now I am bankrupted. I got it from the school’s notebook ownership program which is rather worth it given the OP spec. With just 12000 HKD, I got 1TB SSD, Gen 9 i7 intel CPU core, Nvidia RTX 2060, 32GB RAM, HD screen, as well as a gigantic power supply yay . As a professional IT dog, the very first thing I need to do is to install linux dual boot on it, but it has been cries and tears doing so. Took me several days TAT. 1. Install Nvidia Driver I cant directly install from desktop images as it will enter a broken screen as the computer don’t have Nvidia driver at fresh install. Therefore I install ubuntu by first installing a ubuntu server, install the Nvidia driver manually, finally install the desktop. During the installation wifi seems not working so I connect the computer with LAN. Then install a desktop distro. I chose KDE because the desktop looks like win10, and I just joke with my non linux friends that it is win11 and they really believe in it . This will display a list of available desktops that you can install After installing, just reboot 2. Brightness control And then brightness setting is not working First need to enable brightness control of the GPU. Open /usr/share/X11/xorg.conf.d/10-nvidia.conf (or maybe other file like this in the same directory) and add a line of Everytime after you update the nvidia driver, you need to manually add back the above line. Then ubuntu don’t know it can control the lower level setting of computer. So to enable the OS to set the low level stuffs, set the grub by modifying a line in /etc/default/grub Remember to sudo update-grub and then restart. You may now test the brightness control with xbacklight -set 10 or brightness control buttons on your computer if you have. 3. Cannot connect to WIFI Do this after you have installed desktop First switch the netplan to use NetworkManager Change the «ENTIRE» 01-netcfg.yaml as follows The story hasn’t ended yet. idk why i dont need these for the first attempt. For each start up, you need to run these If you don’t have rfkill , install it by sudo apt isntall rfkill If you don’t want to run it every time manually, you can put them as /etc/rc.local 4. Chinese input Installing Chinese in KDE is such a headache, and the input method itself is much less user friendly than that in win10. But never mind when programming who use Chinese. First install Chinese language pack Then check whether zh-tw something like that is in your locale by running Next install ibus. I have not successfully tried other input libraries. ibus claims itself as new and user friendly but nah. add this to your /.zshrc or you cannot use ibus in some app Finally log out and log in again will have it done 🙂 If the language box is not on the toolbar, run this 5. Share drive with windows I also want to share some part of the hard drive for windows, rule of thumbs

And then in linux mount the drive (for me linux directly auto mount C: to /media/storage/ ), and symlink the folders in home directory to the shared drive (I just remove /Pictures/ etc and make some symlink that point to C:\Users\xxxxxx\Documents whatever in One interesting thing is I am even able to share the VirtualBox VMs across linux and windows.

6. Broken nvidia driver after updating bios After I had update my bios, my entire nvidia driver breaks and back-light control is not working. My eyes hurt! (Takes me a whole night and morning to get it solved T^T) What I did is update the nvidia driver But then the driver is installed but not running, you can tell by What i did is just uninstall and then install all the nvidia related packages listed in dpkg -l | grep -i nvidia , and then install the newest nvidia driver by the steps at #1. And then I run https://devtalk.nvidia.com/default/topic/1037160 again, it shows something like this None of the processes are using the GPU, if I run nvidia-settings , it saids cannot connect to Nvidia driver whatever. What I did is review the debug log, which is generated by nvidia-bug-report.sh , I see something like this To solve this, I removed nvidia-modeset.ko and reinstall all nvidia related packages I changed 4.15.0-36-generic to something else, anyway it should be changed to the newest one After I setup the brightness control again in #2, my eyes are saved! Run nvidia-smi I can see desktop processes are actually using the GPU, and nvidia-settings can open a normal dialog. Источник Linux Linux + RTX + разгонArtfulБывалыйСтолкнулся с проблемой — не гоняться видеокарты GTX 1660Ti / RTX 2060 / RTX 2070 под линуксом Ubuntu 18.04 + драйвера 418.40.04 Как проверял /usr/bin/nvidia-smi -i 0 -pm 1 в консоле сообщения что значения успешно установлены потом останавливаю майнер — отключаю разгон так же через программу nvidia-smi всегда отображаются одни и теже частоты — не важно что я ставил при разгоне Кто скажет — что там поменяли в RTX в плане разгона под линуксом ? Источник Обзор Nvidia GeForce RTX 2060: новые технологии приходят в среднебюджетный сегментОглавлениеСправочные материалы: Теоретическая часть: особенности архитектурыПо череде анонсов видеокарт семейства Turing хорошо видно, как быстро бежит время. Казалось бы, топовые модели решений линейки GeForce RTX были представлены компанией Nvidia не так уж давно, но на деле с момента их первоначального анонса на Gamescom прошло уже чуть ли не полгода. Как это часто бывает, первыми снимают сливки с дорогих продуктов, и в этот раз одна за одной были выпущены модели GeForce RTX 2080 Ti, GeForce RTX 2080 и GeForce RTX 2070. Nvidia впервые рассказала о решениях новой линейки GeForce RTX еще в августе — были объявлены три модели, основанные на графических процессорах разной сложности и производительности: TU106, TU104 и TU102. Используемый при производстве графических процессоров архитектуры Turing техпроцесс 12 нм FinFET по характеристикам лишь чуть лучше 16-нанометрового, известного нам по предыдущему поколению Pascal, поэтому чипы семейства Turing получились довольно большими по размеру и дорогими в производстве, что отразилось и на розничных ценах. Среди самых ярких преимуществ и нововведений в GPU нового семейства — специализированные блоки для аппаратного ускорения трассировки лучей, позволяющие использовать физически корректный расчет распространения лучей света, в отличие от растеризации, лишь имитирующей их поведение. Чтобы в очередной раз не рассказывать об основах и особенностях трассировки, предлагаем прочитать большую и подробную статью о ней. В GeForce RTX мы увидели первую массовую реализацию технологии, способной на приемлемую производительность трассировки лучей в реальном времени. RT-ядра в составе Turing стали самым важным шагом за несколько лет — энтузиасты 3D-графики давно ждали этого момента. В первые годы использование трассировки предполагается в гибридном виде — с сочетанием растеризации и трассировки лучей, используемой для рендеринга некоторых эффектов, сложных или вообще невозможных при растеризации. Поддержка трассировки появилась пока что только в игре Battlefield V, в которой она используется исключительно для рендеринга реалистичных отражений (Лара, ты вообще куда пропала. Мы очень хотим посмотреть на твои. гм. тени!), а в середине февраля выйдет Metro Exodus, где трассировка впервые будет использоваться для расчета глобального освещения. Еще одной важной и интересной функциональностью Turing стало добавление совершенно нового типа вычислительных блоков — тензорных ядер, которые способны исполнять специализированные вычисления, связанные с алгоритмами глубокого обучения, с очень высокой производительностью. В будущем эти блоки можно будет использовать в широком круге задач искусственного интеллекта, но для игровой 3D-графики первым практическим применением тензорных ядер стал алгоритм Deep Learning Super Sampling (DLSS) — это скорее даже не сглаживание, как это обозначено в его названии, а хитрое увеличение разрешения рендеринга с использованием возможностей обученной нейросети. От простого повышения разрешения такой метод отличается тем, что он имеет доступ к кадровому буферу и векторам движения, за счет чего и способен обеспечить повышенное качество сглаживания/апскейла. Для игроков это важно потому, что метод дает возможность повысить качество или разрешение рендеринга практически без дополнительных потерь производительности, так как работой занимаются выделенные тензорные ядра. А еще одним важным применением тензорных блоков в будущем станут алгоритмы шумоподавления, также использующие возможности обученной нейросети, но пока что это — дело будущего. Нужно отметить и некоторый негатив, связанный с выходом дорогих решений линейки GeForce RTX. Мы говорим не только о топовой GeForce RTX 2080 Ti, которая хоть и имеет потрясающую производительность и новую функциональность, но выделяется очень высокой ценой, которая отпугнула многих пользователей. Да и остальные решения семейства Turing из первой тройки не блистали доступностью розничных цен. Конечно, повышенным ценам есть вполне логичные объяснения, но. мотивацию для покупки они добавляют не всегда. Многие потенциальные покупатели ждали более доступной видеокарты. И вот она наконец-то появилась — в самом начале января глава компании Nvidia анонсировал GeForce RTX 2060 на отраслевой конференции CES 2019. К слову, даже сам Дженсен Хуанг признал, что стоимость первых трех выпущенных GeForce RTX слишком высока для массового распространения новых Turing с революционными функциями аппаратной трассировки лучей и ускорения тензорных вычислений. А ведь Nvidia сама кровно заинтересована в том, чтобы GPU с новыми функциями завоевывали рынок. Но так как это вряд ли возможно с ценами на видеокарты от $500 и выше, то на рынок вышла и GeForce RTX 2060 за $349. Да, эта цена также превышает то значение, к которому мы привыкли для GPU этого уровня, ведь на момент своего анонса та же GeForce GTX 1060 стоила на сотню дешевле. Но это — рекомендованная розничная цена на так называемый Founder’s Edition самой Nvidia, а самые простые видеокарты партнеров уже продаются даже чуть дешевле. Но, конечно, фабрично разогнанные варианты с мощной системой охлаждения и питания будут дороже. В любом случае, GeForce RTX 2060 стала самой доступной моделью с аппаратным ускорением трассировки лучей и глубокого обучения, и уже одно это делает ее желанной для многих. Сегодняшняя новинка интересна еще и потому, что она должна дать более ощутимый прирост производительности при смене поколения GPU (если смотреть на RTX 2060 и GTX 1060, по сравнению с более мощными решениями). Это очень важный момент в свете того, что игр с поддержкой трассировки лучей и DLSS пока что будет не очень много, а более дорогие модели линейки RTX не дали пользователям желаемого прироста быстродействия, по сравнению с GTX. Так что GeForce RTX 2060 способна стать не просто наиболее доступным, но и самым выгодным решением из всего нового семейства. Это мы сегодня и проверим. Так как рассматриваемая модель видеокарты компании Nvidia основана на графическом процессоре архитектуры Turing, имеющей очень много общего с предыдущими архитектурами Pascal и Volta, то перед прочтением материала мы советуем ознакомиться с нашими предыдущими статьями:

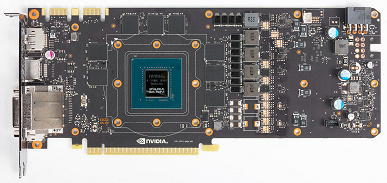

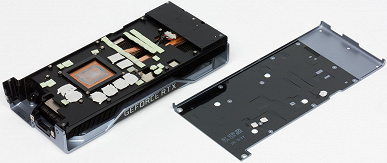

Мы уже привыкли по последним семействам видеокарт Nvidia, что в линейке GeForce предлагаются и специальные продукты самой компании — так называемые Founder’s Edition. В этот раз FE-издание не отличается ни иной стоимостью, ни более привлекательными частотными характеристиками. Nvidia убрала фабричный разгон для FE-варианта GeForce RTX 2060, и все недорогие карты должны иметь схожие характеристики по частоте — GPU работает на турбо-частоте в 1680 МГц, а GDDR6-память имеет частоту в 14 ГГц. Видеокарты Founder’s Edition должны быть довольно надежными, да и выглядят они солидно из-за строгого дизайна и грамотно подобранных материалов. В RTX 2060 применяется та же система охлаждения с испарительной камерой на всю длину печатной платы и двумя вентиляторами — для более эффективного охлаждения (по сравнению с одним вентилятором в предыдущих версиях). Длинная испарительная камера и большой двухслотовый алюминиевый радиатор обеспечивают большую площадь рассеивания тепла, а тихие вентиляторы отводят горячий воздух в разные стороны, а не только наружу корпуса. Видеокарты модели GeForce RTX 2060 уже продаются с 15 января в виде Nvidia Founder’s Edition и решениях партнеров, включая компании Asus, Colorful, EVGA, Gainward, Galaxy, Gigabyte, Innovision 3D, MSI, Palit, PNY и Zotac — с собственным дизайном и характеристиками. А чтобы еще больше улучшить привлекательность новинки, Nvidia объявила о комплектации видеокарты игрой Anthem или Battlefield V — на выбор пользователя, купившего GeForce RTX 2060 или систему на его основе. Архитектурные особенностиВ случае модели GeForce RTX 2060, многое пришлось делать совсем не так, как в предыдущих поколениях. Это связано как с добавлением специализированных блоков, серьезно усложнивших GPU, так и с отсутствием серьезной смены техпроцесса. Вот если бы графические процессоры Turing вышли сразу на техпроцессе 7 нм (правда, позже на год), то вполне возможно, что Nvidia бы даже удержала цены в привычных диапазонах для всех решений линейки. Но не в этот раз. Видеокарты уровня x60 (260, 460, 660, 760, 1060 и другие) всегда были основаны на отдельной модели GPU средней сложности, оптимизированного для этой самой золотой середины. А в нынешнем поколении это тот же чип, что и для RTX 2070, но урезанный по количеству исполнительных блоков. Давайте сравним характеристики нескольких моделей видеокарт Nvidia двух последних поколений:

По таблице хорошо видно, что RTX 2060 основан не на каком-то новом GPU, а на урезанном TU106, известном нам по RTX 2070, хотя раньше для x60-видеокарт применялись чипы меньшей сложности и размера (и, соответственно, меньшей цены). Сравнение пары RTX 2060 и GTX 1060 поражает: новый чип сложнее более чем в два раза, да и кристалл по площади крупнее более чем вдвое. Это все как раз объясняется практически неизменным техпроцессом (12 нм — это совсем чуть-чуть измененный 16 нм) при всех усложнениях, в том числе в виде тензорных и RT-ядер. И чтобы не создавать внутреннюю конкуренцию среди своих продуктов, Nvidia пришлось сильно порезать чип для RTX 2060 по многим статьям, оставив лишь 30 из имеющихся 36 мультипроцессоров SM, которые включают CUDA-ядра, текстурные блоки, RT-ядра и тензорные ядра. То есть RTX 2060 по активным вычислительным блокам меньше RTX 2070 на 20%. Чтобы еще больше подчеркнуть разницу между решениями разных ценовых уровней, также решили сильно урезать и подсистему памяти и ее кэширования: ширина шины снизилась с 256 бит до 192 бит, количество блоков ROP — с 64 до 48, заодно и объем видеопамяти урезали с 8 ГБ до 6 ГБ, что обиднее всего, так как для сохранения достаточно высокой ПСП оставили быструю GDDR6-память, работающую на частоте 14 ГГц. Посмотрим на схеме, что же получилось в итоге: Урезанная версия чипа TU106 в модификации для RTX 2060 содержит три кластера Graphics Processing Cluster (GPC), но количество кластеров Texture Processing Cluster (TPC), состоящих из движков PolyMorph Engine и мультипроцессоров SM, изменилось — шесть TPC тут неактивны. Каждый SM состоит из: 64 CUDA-ядер, четырех блоков текстурирования TMU, восьми тензорных и одного RT-ядра, поэтому всего в урезанном чипе остались активными 30 мультипроцессоров SM, столько же RT-ядер, 1920 CUDA-ядер и 240 тензорных ядер. Наверное, условный «TU108» с уменьшенным количеством всех исполнительных блоков, имеющий меньшие сложность, размер и энергопотребление, был бы выгоднее для Nvidia, но не на этой стадии развития микропроцессорного производства. Зато сейчас для производства GeForce RTX 2060 можно отправить большую часть отбраковки от RTX 2070, вероятно. Что же касается тактовых частот графического процессора в составе младшей модели линейки GeForce RTX, то турбо-частота GPU у референсного варианта (он соответствует FE-изданию в этот раз) карты составляет 1680 МГц. Видеопамять стандарта GDDR6 работает на частоте 14 ГГц, что дает нам пропускную способность в 336 ГБ/с. Кроме появления специализированных RT-ядер и тензорных ядер, в архитектуре Turing внедрено большое количество улучшений в мультипроцессорах SM, которые сказываются на производительности в современных играх со сложной графикой. В частности, поддерживается одновременное исполнение целочисленных операций и вычислений с плавающей запятой (FP32 и INT32), а архитектура кэширования данных и доступа к памяти была улучшена, что в общем дает до двух крат преимущества по скорости вычислений по сравнению с архитектурой Pascal, на которой основан предшественник сегодняшней новинки — GeForce GTX 1060. Также были улучшены технологии сжатия информации без потерь, архитектура Turing поддерживает новые техники компрессии, до 50% более эффективные, по сравнению с алгоритмами в семействе чипов Pascal. Другие изменения в новой архитектуре Turing нацелены скорее на будущее, вроде mesh shading — новых типов шейдеров, ответственных за всю работу над геометрией, вершинами, тесселяцией и т. д. Мы писали обо всем этом в обзоре GeForce RTX 2080 Ti. У многих пользователей может появиться резонный вопрос — а «потянет» ли самый слабый GPU с поддержкой ускорения трассировки лучей соответствующие игры? Видеокарта модели RTX 2060 имеет 30 RT-ядер и обеспечивает производительность до 5 гигалучей/с, что ненамного хуже 6 гигалучей/с у той же RTX 2070. За все будущие игровые проекты ответить сложно, но конкретно в игре Battlefield V вполне можно играть в Full HD-разрешении с ультра-настройками и трассировкой лучей, получая 60 FPS. Более высокое разрешение, конечно, новинка уже не потянет — да и вообще, игра многопользовательская, в ней не до особых красот, честно говоря. Для любителей красивой картинки даже в Battlefield V, скоро должно появиться обновление игры с поддержкой технологии DLSS. Вместе с дополнительными оптимизациями алгоритма трассировки лучей, это должно привести к еще более высокой производительности, что особенно важно для решений этого ценового уровня. Предварительные тесты оптимизированной версии игры с поддержкой DLSS говорят о том, что RTX 2060 обеспечит в Full HD-разрешении уже не 60 FPS, а 80-90 FPS, и это с включенной трассировкой лучей! В общем, новый GPU должен обеспечивать где-то 75%-80% от мощности GeForce RTX 2070, что довольно неплохо — вероятно, даже не только для Full HD-разрешения, но и для WQHD (если хватит 6 ГБ памяти в каждом конкретном случае), а вот для 4K вряд ли. Так, по данным Nvidia, новый GeForce RTX 2060 на 60% быстрее GTX 1060 из предыдущего поколения, и очень близок к GeForce GTX 1070 Ti, а это — очень хороший уровень производительности. Если говорить о вещах, не связанных с 3D, то в TU106 есть и обновленный блок вывода информации, поддерживающий дисплеи с высоким разрешением, HDR и высокой частотой обновления. Все платы GeForce RTX имеют порты DisplayPort 1.4a, позволяющие вывести информацию на 8K-монитор с частотой обновления 60 Гц с поддержкой технологии VESA Display Stream Compression (DSC) 1.2, обеспечивающей высокую степень сжатия. Все решения семейства Turing поддерживают два 8K-дисплея при 60 Гц (требуется по одному кабелю на каждый), такое же разрешение также можно получить при подключении через установленный USB-C. Кроме этого, все Turing поддерживают полноценный HDR в конвейере вывода информации, включая tone mapping для различных мониторов — со стандартным динамическим диапазоном и расширенным. Все новые GPU семейства Turing содержат улучшенный кодировщик видеоданных NVEnc, добавляющий поддержку сжатия данных в формате H.265 (HEVC) при разрешении 8K и 30 FPS. Также был обновлен и декодер видеоданных NVDec, получивший поддержку декодирования данных в формате HEVC YUV444 10-бит/12-бит HDR при 30 FPS, в формате H.264 при 8K-разрешении и в формате VP9 с 10-бит/12-бит данными. Со всеми остальными возможностями семейства Turing вы можете познакомиться в большом обзоре GeForce RTX 2080 Ti. Особенности видеокартыОбъект исследования: ускоритель трехмерной графики (видеокарта) Nvidia GeForce RTX 2060 Founder’s Edition 6 ГБ 192-битной GDDR6 Сведения о производителе: Компания Nvidia Corporation (торговая марка Nvidia) основана в 1993 году в США.Штаб-квартира в Санта-Кларе (Калифорния). Разрабатывает графические процессоры, технологии. До 1999 года основной маркой была Riva (Riva 128/TNT/TNT2), с 1999 года и по настоящее время — GeForce. В 2000 году были приобретены активы 3dfx Interactive, после чего торговые марки 3dfx/Voodoo перешли к Nvidia. Своего производства нет. Общая численность сотрудников (включая региональные офисы) — около 5000 человек. Характеристики карты

ПамятьКарта имеет 6 ГБ памяти GDDR6 SDRAM, размещенной в 6 микросхемах по 8 Гбит на лицевой стороне PCB. Микросхемы памяти Samsung (GDDR6) рассчитаны на номинальную частоту работы в 3500 (14000) МГц Особенности карты и сравнение с GTX 1070 Ti

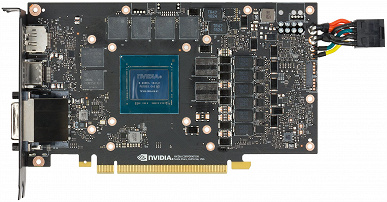

Мы сравниваем с GTX 1070 Ti прежде всего потому, что RTX 2060 по уровню производительности примерно соответствует именно GTX 1070 Ti, а не GTX 1060 (для последнего вскоре тоже «подъедет» обновление). Очевидно, что RTX 2060 получен из RTX 2070 (то же самое ядро TU106, просто используется отбраковка кристаллов, годящихся для работы с урезанным числом блоков), поэтому и PCB оставили от RTX 2070, не распаяв на плате 2 микросхемы памяти, что сократило ее объем с 8 до 6 ГБ. Схема питания построена на базе 6-фазного цифрового преобразователя iMon DrMOS и управляется цифровым контроллером uP9512P производства uPI. С помощью утилит EVGA Precision X1 или MSI Afterburner можно не только напрямую повысить частоты работы карты, но и запустить Nvidia Scanner, который поможет определить безопасный максимум разгона ядра и памяти. Карта оснащается новым разъемом USB-C (VirtualLink) специально для работы с устройствами виртуальной реальности следующего поколения. Следует отметить, что на RTX 2060 установлен в числе прочих видеовыход DVI, тогда как на старших RTX 2070/2080/2080 Ti он отсутствовал. Охлаждение и нагрев

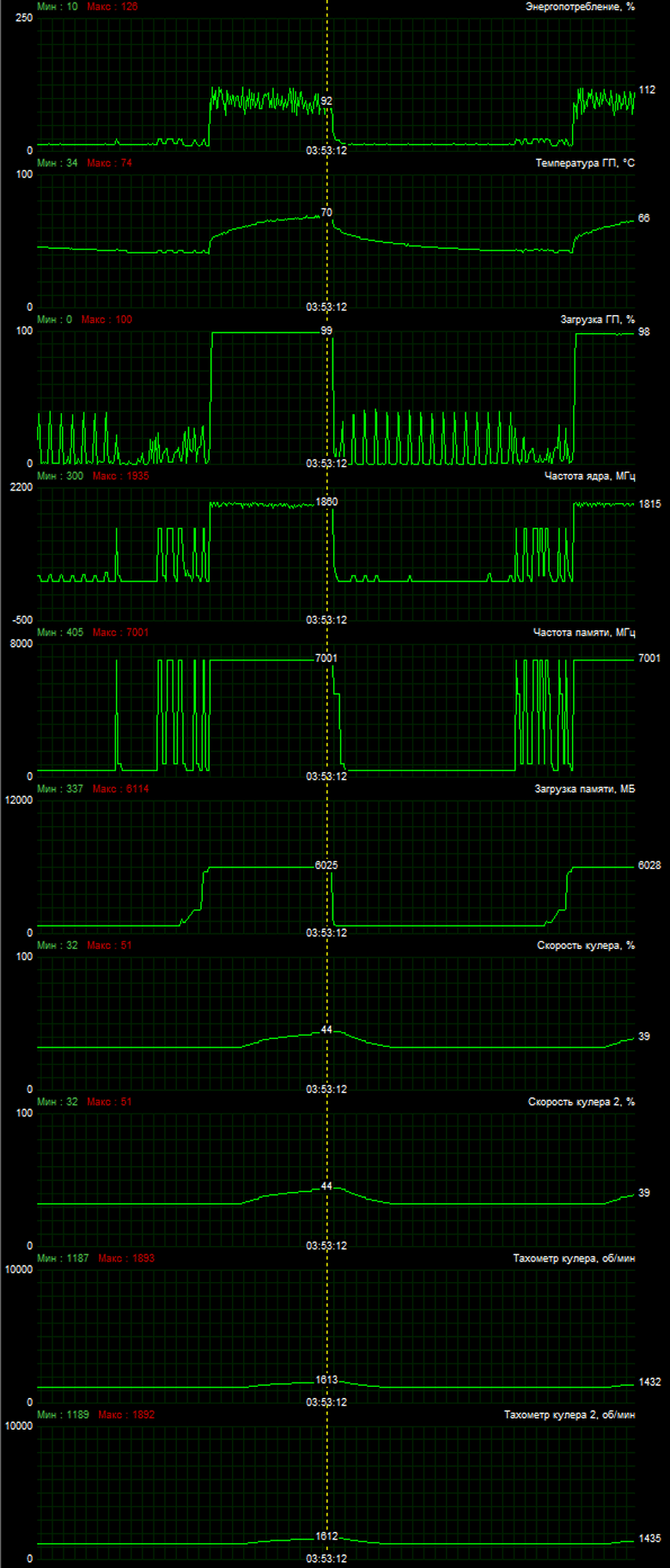

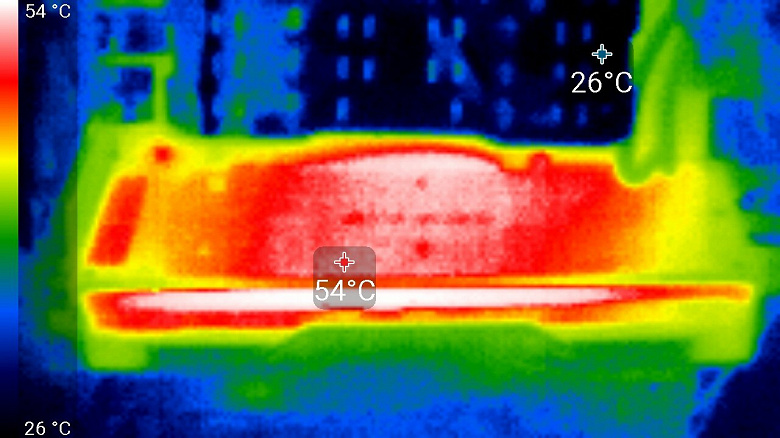

Главной частью кулера является большая испарительная камера, оборотная часть которой припаяна к массивному радиатору. Поверх установлен кожух с двумя вентиляторами, работающими на одинаковой частоте вращения. Микросхемы памяти и силовые транзисторы охлаждаются специальной пластиной, также жестко соединенной с основным радиатором. С оборотной стороны карта прикрывается специальной пластиной, которая обеспечивает не только жесткость печатной платы, но и дополнительное охлаждение через специальный термоинтерфейс. Мониторинг температурного режима с помощью MSI Afterburner (автор А. Николайчук AKA Unwinder): После 6-часового прогона под нагрузкой максимальная температура ядра не превысила 70 градусов, что является нормальным результатом для видеокарты высокого уровня. Максимальный нагрев — центральная часть торца радиатора. Методика измерения шума подразумевает, что помещение шумоизолировано и заглушено, снижены реверберации. Системный блок, в котором исследуется шум видеокарт, не имеет вентиляторов, не является источником механического шума. Фоновый уровень 18 дБА — это уровень шума в комнате и уровень шумов собственно шумомера. Измерения проводятся с расстояния 50 см от видеокарты на уровне системы охлаждения.

Оценка градаций уровня шума выполняется по методике, описанной здесь:

В режиме простоя в 2D температура составляла 29 °C, вентиляторы работали на частоте вращения 1200 оборотов в минуту. Шум был равен 22,6 дБА. При просмотре фильма с аппаратным декодированием ничего не менялось: температура ядра оставалась прежней, вентиляторы работали на тех же оборотах, шум сохранялся на уровне 22,7 дБА. В режиме максимальной нагрузки в 3D температура достигала 70 °C. Вентиляторы при этом раскручивались до 1613 оборотов в минуту, шум вырастал до 29,8 дБА, так что шум от данной СО невысокий. Комплект поставки и упаковкаБазовый комплект поставки серийной карты должен включать в себя руководство пользователя, диск с драйверами и утилитами. С нашей картой Founder’s Edition в комплекте шли лишь руководство пользователя и листовки.

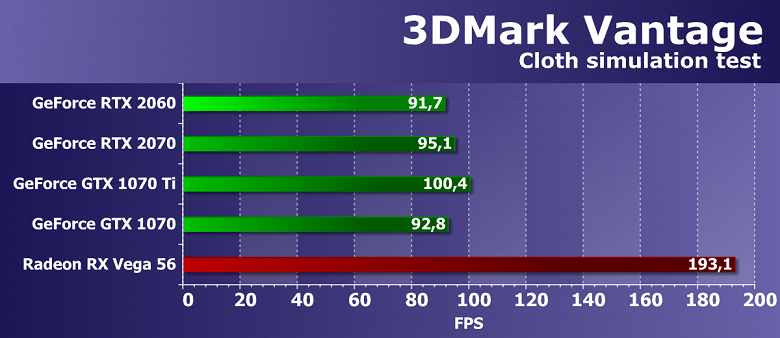

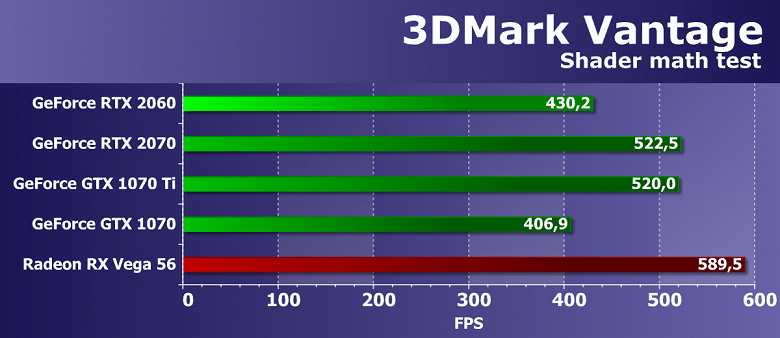

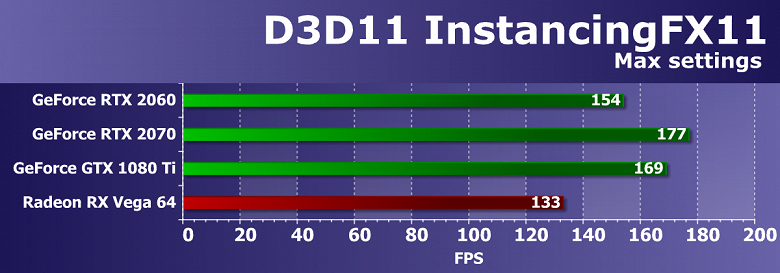

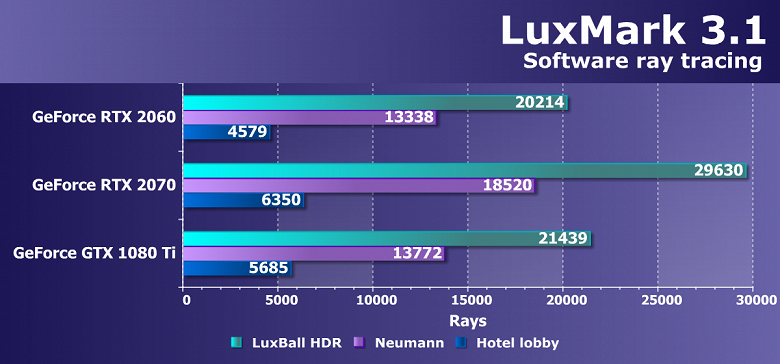

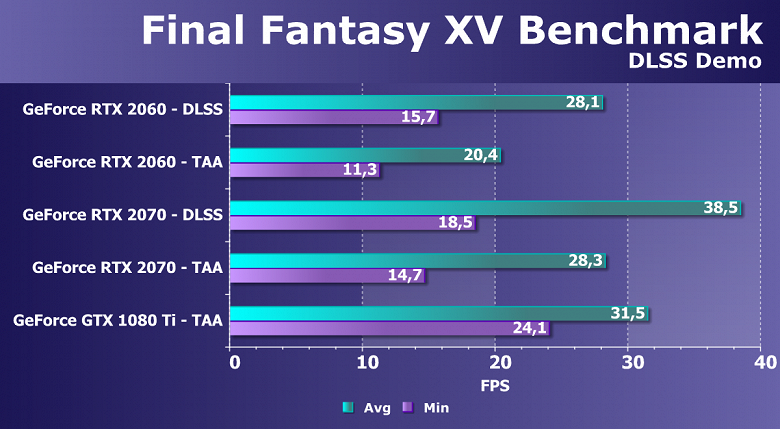

Синтетические тестыНедавно мы обновили пакет синтетических тестов, он все еще экспериментальный и будет меняться. Мы бы хотели добавить еще больше примеров с вычислениями (compute shaders), но с этим есть определенные сложности. В будущем мы постараемся расширить и улучшить набор синтетических тестов, и если у вас есть четкие и обоснованные предложения — пишите их в комментариях к статье или отправьте почтой. Из ранее активно использовавшихся нами тестов RightMark3D мы оставили лишь несколько самых тяжелых вариантов. Остальные уже изрядно устарели и на столь мощных GPU упираются в различные ограничители, не загружают работой блоки графического процессора и не показывают истинную его производительность. А вот синтетические Feature-тесты из набора 3DMark Vantage мы пока что решили оставить в полном составе, так как заменить их попросту нечем, хотя и они уже устарели. Из более-менее новых бенчмарков мы начали использовать несколько примеров, входящих в DirectX SDK и пакет SDK компании AMD (скомпилированные примеры применения D3D11 и D3D12), а также несколько тестов для измерения производительности трассировки лучей и один тест для сравнения производительности сглаживания методами DLSS и TAA для решений Nvidia. В качестве полусинтетического теста у нас также используется и популярный 3DMark Time Spy, помогающий определить прирост от асинхронных вычислений. Синтетические тесты проводились на следующих видеокартах:

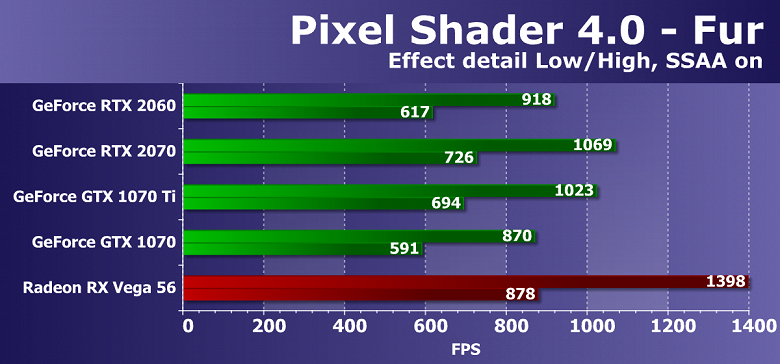

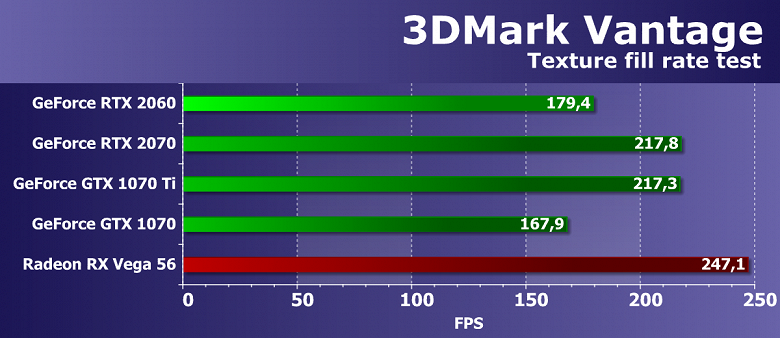

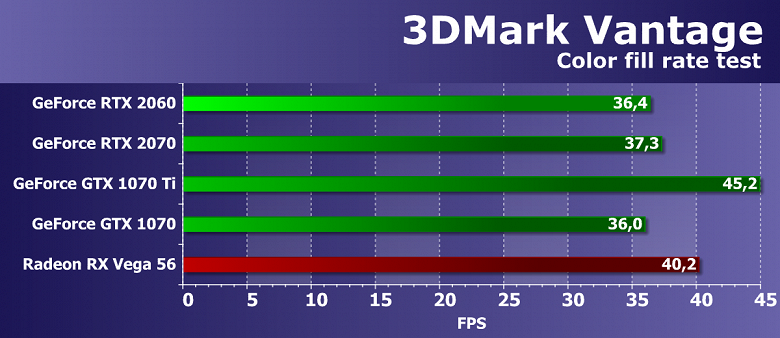

Для анализа производительности новой видеокарты GeForce RTX 2060 мы взяли эти решения по следующим причинам. Мы не стали сравнивать новинку с ее прямым предшественником GeForce GTX 1060, так как это не имеет особого смысла — уровень GPU тут совершенно разный. Зато мы сравним самый доступный GeForce RTX со схожими по производительности графическими процессорами из предыдущего поколения Pascal: моделями GTX 1070 Ti и GTX 1070. В некоторых тестах также используется и модель GeForce GTX 1080 Ti, хоть она и принадлежит к более высокому ценовому диапазону, но интересна нам как наиболее производительный представитель предыдущего семейства. Ну а RTX 2070 представлена в виде ориентира — по ней мы поймем, насколько сильно был «придушен» GPU в его урезанном исполнении. В качестве основного соперника для GeForce RTX 2060 у нас выступает видеокарта Radeon RX Vega 56, имеющая близкую цену и, вероятно, производительность. Второй видеокартой AMD для нашего сегодняшнего сравнения стала модель Vega 64, которая хоть и дороже и быстрее, но несущественно — для наших тестов она подойдет как наиболее производительное решение компании AMD до выхода недавно анонсированного Radeon VII. Мы сильно сократили состав DirectX 10-тестов из RightMark3D, оставив только несколько примеров с наибольшей нагрузкой на GPU. Первая пара тестов измеряет производительность выполнения относительно простых пиксельных шейдеров с циклами при большом количестве текстурных выборок (до нескольких сотен выборок на пиксель) и сравнительно небольшой загрузке ALU. Иными словами, в них измеряется скорость текстурных выборок и эффективность ветвлений в пиксельном шейдере. Оба примера включают самозатенение и шейдерный суперсэмплинг, увеличивающий нагрузку на видеочипы. Первый тест пиксельных шейдеров — Fur. При максимальных настройках в нем используется от 160 до 320 текстурных выборок из карты высот и несколько выборок из основной текстуры. Производительность в данном тесте зависит от количества и эффективности блоков TMU, на результат влияет также и эффективность выполнения сложных программ. В задачах процедурной визуализации меха с большим количеством текстурных выборок, решения компании AMD лидируют со времен выхода первых графических процессоров архитектуры GCN, и совершенно неудивительно, что видеокарты Radeon до сих пор являются лучшими в этих сравнениях, что говорит о большей эффективности выполнения подобных программ. Вывод подтверждается в очередной раз — рассматриваемая нами видеокарта модели GeForce RTX 2060 выступила заметно хуже своего конкурента в виде совсем не новой уже Vega 56. В этом D3D10-тесте очередная плата серии RTX хоть и немного, но явно уступает модели из предыдущей линейки — GeForce GTX 1070 Ti, основанной на чипе семейства Pascal. Правда, GTX 1070 новинка смогла опередить, но совсем чуть-чуть. В столь простых тестах вся линейка RTX не слишком сильна, новым GPU нужны более сложные шейдеры и условия в целом. Отставание от RTX 2070 составило порядка 15%, что близко к теоретической разнице. Следующий DX10-тест Steep Parallax Mapping также измеряет производительность исполнения сложных пиксельных шейдеров с циклами при большом количестве текстурных выборок. При максимальных настройках он использует от 80 до 400 текстурных выборок из карты высот и несколько выборок из базовых текстур. Этот шейдерный тест Direct3D 10 несколько интереснее с практической точки зрения, так как разновидности parallax mapping широко применяются в играх, в том числе и такие варианты как steep parallax mapping. Кроме того, в нашем тесте мы включили самозатенение, увеличивающее нагрузку на видеочип в два раза, и суперсэмплинг, также повышающий требования к мощности GPU. Диаграмма похожа на предыдущую, но в этот раз видеокарта GeForce RTX 2060 выступила лучше, почти догнав GTX 1070 Ti из предыдущего поколения, а ее преимущество над GTX 1070 стало явным. Упора в ПСП или ROP тут нет, и RTX 2070 оказалась быстрее примерно на 15%, что близко к теории. Если сравнивать новинку с конкурирующей с ней видеокартой компании AMD, то Vega 56 снова быстрее, хотя ее преимущество сократилось. Будем надеяться, что в более сложных DirectX 11 и 12 тестах новинка Nvidia лучше раскроет свой потенциал. Из пары тестов пиксельных шейдеров с минимальным количеством текстурных выборок и относительно большим количеством арифметических операций, мы выбрали более сложный, так как они уже порядком устарели и уже не измеряют чисто математическую производительность GPU. Да и за последние годы скорость выполнения именно арифметических инструкций в пиксельном шейдере не так важна, большинство вычислений перешли в compute shaders. Итак, тест шейдерных вычислений Fire — текстурная выборка в нем лишь одна, а количество инструкций типа sin и cos равно 130 штукам. Впрочем, для современных GPU это семечки. В математическом тесте из нашего RigthMark мы почти всегда видим результаты, довольно далекие от теории и сравнений в других аналогичных бенчмарках. Вероятно, столь мощные платы ограничивает что-то, не относящееся к скорости вычислительных блоков, так как GPU при тестировании не бывает загружен работой на 100%. Рассматриваемая сегодня GeForce RTX 2060 в этом тесте опережает GTX 1070, но заметно отстает от GTX 1070 Ti, да и вообще от всех остальных видеокарт. Единственный GPU конкурирующей компании оказался значительно быстрее вообще всех видеокарт GeForce, преимущество над новинкой составило целых 37%. Переходим к тесту геометрических шейдеров. В составе пакета RightMark3D 2.0 есть два теста скорости геометрических шейдеров, но один из них (Hyperlight, демонстрирующий использование техник: instancing, stream output, buffer load, использующий динамическое создание геометрии и stream output), на всех видеокартах компании AMD не работает, поэтому мы решили оставить лишь второй — Galaxy. Техника в этом тесте аналогична point sprites из предыдущих версий Direct3D. В нем анимируется система частиц на GPU, геометрический шейдер из каждой точки создает четыре вершины, образующие частицу. Вычисления производятся в геометрическом шейдере. Соотношение скоростей при разной геометрической сложности сцен примерно одинаково для всех решений, производительность соответствует количеству точек. Задача для мощных современных GPU довольно простая, но разница между разными моделями видеокарт присутствует. Новая GeForce RTX 2060 в этом тесте показала неплохой результат, догнав GTX 1070 Ti в самом сложном подтесте из трех. Также новинка значительно обошла условного конкурента в самых сложных условиях. Отставание выбранной в качестве соперника Radeon при высокой геометрической сложности получилось примерно на четверть. В этом тесте разница между видеокартами на чипах Nvidia и AMD явно в пользу решений калифорнийской компании, что обусловлено отличиями в геометрических конвейерах GPU. В тестах геометрии платы GeForce всегда конкурентоспособнее Radeon, и мощные топовые видеочипы Nvidia, имеющие сравнительно большое количество блоков по обработке геометрии, почти всегда выигрывают в них. Последним тестом из Direct3D 10 станет скорость большого количества текстурных выборок из вершинного шейдера. Из пары имеющихся у нас тестов с использованием displacement mapping на основании данных из текстур, мы выбрали тест Waves, имеющий условные переходы в шейдере и поэтому более сложный и современный. Количество билинейных текстурных выборок в данном случае составляет 24 штуки на каждую вершину. Результаты в тесте вершинного текстурирования Waves в очередной раз показали странный упор новой GeForce RTX 2060 в необъяснимое. Хотя в самых сложных условиях производительность новой модели GPU оказалась выше, чем у всех решений, кроме более мощной модификации из линейки GeForce RTX. Обе видеокарты предыдущего поколения Pascal остались позади, кроме самого легкого режима. Если же сравнивать новинку с Radeon RX Vega 56, то они идут вровень в сложных условиях, но в среднем и легком карта AMD выходит вперед. Мы традиционно рассматриваем также и синтетические тесты из пакета 3DMark Vantage, ведь они иногда показывают нам то, что мы упустили в тестах собственного производства. Feature тесты из этого тестового пакета также обладают поддержкой DirectX 10, они до сих пор более-менее актуальны и при анализе результатов новейшей видеокарты GeForce RTX 2060 мы сделаем какие-то полезные выводы, ускользнувшие от нас в тестах пакета RightMark 2.0. Feature Test 1: Texture Fill Первый тест измеряет производительность блоков текстурных выборок. Используется заполнение прямоугольника значениями, считываемыми из маленькой текстуры с использованием многочисленных текстурных координат, которые изменяются каждый кадр. Эффективность работы видеокарт AMD и Nvidia в текстурном тесте компании Futuremark довольно высока, тест показывает результаты, близкие к соответствующим теоретическим параметрам, хотя с линейкой GeForce RTX получилось странно. Разница в скорости между GeForce RTX 2060 и GTX 1070 Ti оказалась явно в пользу старого решения, хотя так не должно быть. Только GTX 1070 осталась в проигравших. От старшей RTX 2070 новинка отстает примерно соответственно теории. Сравнение скорости текстурирования рассматриваемой сегодня видеоплаты компании Nvidia с конкурирующей видеокартой AMD показывает, что самая слабая GeForce RTX уступила видеокарте Radeon RX Vega 56 очень сильно, так как последняя имеет большое количество блоков TMU и с задачей текстурирования справляется весьма неплохо. Разница между ними получилась под 40%, что объяснимо теорией. Feature Test 2: Color Fill Вторая задача — тест скорости заполнения. В нем используется очень простой пиксельный шейдер, не ограничивающий производительность. Интерполированное значение цвета записывается во внеэкранный буфер (render target) с использованием альфа-блендинга. Используется 16-битный внеэкранный буфер формата FP16, наиболее часто используемый в играх, применяющих HDR-рендеринг, поэтому такой тест является вполне современным. Цифры из второго подтеста 3DMark Vantage должны показывать производительность блоков ROP, без учета величины пропускной способности видеопамяти, и тест обычно измеряет именно производительность подсистемы ROP. Но получилось что-то странное, плата GeForce RTX 2070 показала явно заниженный результат. Поэтому RTX 2060 почти не отстала от нее, хотя теоретически скорость заполнения (филлрейт) у них разная. Интересно, что GTX 1070 Ti оказалась заметно быстрее обеих. Если же сравнивать скорость заполнения сцены видеокартой GeForce RTX 2060 с конкурентом компании AMD, то рассматриваемая сегодня плата и в этом тесте показала меньшую скорость заполнения сцены по сравнению с Radeon RX Vega 56. Сниженное количество блоков ROP у новинки привело к тому, что даже эффективные оптимизации сжатия данных не смогли помочь догнать соперника, хотя разница между ними и небольшая, около 10%. Feature Test 3: Parallax Occlusion Mapping Один из самых интересных feature-тестов, так как подобная техника давно используется в играх. В нем рисуется один четырехугольник (точнее, два треугольника) с применением специальной техники Parallax Occlusion Mapping, имитирующей сложную геометрию. Используются довольно ресурсоемкие операции по трассировке лучей и карта глубины большого разрешения. Также эта поверхность затеняется при помощи тяжелого алгоритма Strauss. Это тест очень сложного и тяжелого для видеочипа пиксельного шейдера, содержащего многочисленные текстурные выборки при трассировке лучей, динамические ветвления и сложные расчеты освещения по Strauss. Результаты этого теста из пакета 3DMark Vantage не зависят исключительно от скорости математических вычислений, эффективности исполнения ветвлений или скорости текстурных выборок, а от нескольких параметров одновременно. Для достижения высокой скорости в этой задаче важен правильный баланс GPU, а также эффективность выполнения сложных шейдеров. Тут важны и математическая и текстурная производительность, и в этой «синтетике» из 3DMark Vantage новая модель GeForce RTX 2060 показала приличный результат, совсем немного отстав от видеокарты более высокого позиционирования из прошлого поколения Pascal, а разница между двумя GeForce RTX соответствует теории. Новое решение Nvidia значительно опередило GTX 1070 и очень близко к Vega 56, а ведь графические процессоры AMD в этом тесте всегда были сильны. Feature Test 4: GPU Cloth Четвертый тест интересен тем, что рассчитывает физические взаимодействия (имитация ткани) при помощи видеочипа. Используется вершинная симуляция, при помощи комбинированной работы вершинного и геометрического шейдеров, с несколькими проходами. Используется stream out для переноса вершин из одного прохода симуляции к другому. Таким образом, тестируется производительность исполнения вершинных и геометрических шейдеров и скорость stream out. Скорость рендеринга в этом тесте должна зависеть сразу от нескольких параметров, и основными факторами влияния должны являться производительность обработки геометрии и эффективность выполнения геометрических шейдеров. Сильные стороны чипов Nvidia должны были проявиться, но мы в который раз получаем явно странные результаты в этом тесте. Очередная новая видеокарта GeForce показала очень низкую скорость на уровне решений предшествующего поколения GeForce GTX и еще одной из линейки GeForce RTX. C этим тестом точно что-то не так, логического объяснения таким результатам у нас нет. В таких условиях и сравнение с единственным Radeon для GeForce RTX 2060 ничем хорошим закончиться не может. Несмотря на теоретически меньшее количество геометрических исполнительных блоков и отставание по геометрической производительности у чипов AMD, плата Radeon в этом тесте по какой-то (вероятно, программной) причине работает заметно лучше, в два раза обгоняя абсолютно все видеокарты GeForce, представленные в сегодняшнем сравнении. Feature Test 5: GPU Particles Тест физической симуляции эффектов на базе систем частиц, рассчитываемых при помощи графического процессора. Используется вершинная симуляция, где каждая вершина представляет одиночную частицу. Stream out используется с той же целью, что и в предыдущем тесте. Рассчитывается несколько сотен тысяч частиц, все анимируются отдельно, также рассчитываются их столкновения с картой высот. Частицы отрисовываются при помощи геометрического шейдера, который из каждой точки создает четыре вершины, образующие частицу. Больше всего загружает шейдерные блоки вершинными расчетами, также тестируется stream out. И во втором геометрическом тесте из 3DMark Vantage новая GeForce RTX 2060 снова явно далека от результата, соответствующего теории. Новинка оказалась ниже уровня обеих представителей архитектуры Pascal в виде GTX 1070 и GTX 1070 Ti, а вот RTX 2070 в этот раз ушла вперед примерно соответственно теории. Сравнение новинки с единственной представленной в материале видеокартой компании AMD приносит ожидаемый вывод — самая доступная видеокарта семейства Turing показала результат заметно хуже решения конкурента. Feature Test 6: Perlin Noise Последний feature-тест пакета Vantage является математически-интенсивным тестом GPU, он рассчитывает несколько октав алгоритма Perlin noise в пиксельном шейдере. Каждый цветовой канал использует собственную функцию шума для большей нагрузки на видеочип. Perlin noise — это стандартный алгоритм, часто применяемый в процедурном текстурировании, он использует много математических вычислений. В этом математическом тесте производительность решений хоть и не совсем соответствует теории, но ближе к пиковой производительности видеочипов в предельных задачах. Похоже, что в этом тесте используются в основном операции с плавающей запятой, и новая архитектура Turing просто не может использовать свои уникальные возможности и показать результат заметно выше лучших представителей из семейства Pascal. GeForce RTX 2060 в этом тесте оказалась между GTX 1070 и GTX 1070 Ti, отстав от старшей RTX 2070 соответственно теории. Видеочипы компании AMD с архитектурой GCN справляются с подобными задачами еще лучше — в тех случаях, когда выполняется интенсивная «математика» в предельных режимах. Radeon RX Vega 56 в этом тесте стала победителем, легко обогнав рассматриваемую сегодня RTX 2060. Впрочем, далее мы рассмотрим более современные тесты, использующие повышенную нагрузку на GPU и показатели Turing в них обычно оказываются лучше. Переходим к Direct3D11-тестам из пакета разработчиков SDK Radeon. Первым на очереди будет тест под названием FluidCS11, в котором моделируется физика жидкостей, для чего рассчитывается поведение множества частиц в двухмерном пространстве. Для симуляции жидкостей в этом примере используется гидродинамика сглаженных частиц. Число частиц в тесте устанавливаем максимально возможное — 64 000 штук. Первый Direct3D11-тест тоже не раскрывает новых возможностей архитектуры Turing, все видеокарты GeForce проиграли единственному условному конкуренту в виде Radeon RX Vega 64, который оказался быстрее всех. А сегодняшняя новинка не опередила топовое решение семейства Pascal, став последней. Что, впрочем, соответствует теории. Судя по высокой частоте кадров, вычисления в этом примере из SDK не слишком сложны, и мощные GPU просто не могут показать свои способности. Второй D3D11-тест называется InstancingFX11, в этом примере из SDK используются DrawIndexedInstanced-вызовы для отрисовки множества одинаковых моделей объектов в кадре, а их разнообразие достигается при помощи использования текстурных массивов с различными текстурами для деревьев и травы. Для увеличения нагрузки на GPU мы использовали максимальные настройки: число деревьев и плотность травы. Производительность рендеринга в этом тесте зависит от оптимизации драйвера и командного процессора GPU. И с этим у всех решений Nvidia все в порядке, все видеокарты GeForce опередили лучшую из Radeon. Что же касается сравнения сегодняшней новинки с лучшей из видеокарт прошлого поколения, то GeForce RTX 2060 немного ей проиграла, а RTX 2070 оказалась быстрее новинки на 15%, что близко к теории. Новые графические процессоры архитектуры Turing в столь сложных условиях выступают неплохо. Ну и последний D3D11-пример — VarianceShadows11. В этом тесте из SDK AMD используются теневые карты (shadow maps) с тремя каскадами (уровнями детализации). Динамические каскадные карты теней сейчас широко применяются в играх с растеризацией, поэтому тест довольно интересный. При тестировании мы использовали настройки по умолчанию. Производительность в этом примере из SDK зависит как от скорости блоков растеризации, так и от пропускной способности памяти. По этим параметрам более мощные видеокарты Nvidia выигрывают у Radeon RX Vega 64, но их преимущество не настолько уж велико, а новая GeForce RTX 2060 и вовсе проиграла всем. Самая мощная представительница из семейства Pascal стала лучшей в этом тесте, в котором все соответствует производительности блоков ROP. Да и частота кадров слишком высока в любом случае — задача эта довольно легкая для мощных GPU. Direct3D11-тесты из SDK компании AMD закончились, переходим к примерам из DirectX SDK компании Microsoft — все они используют последнюю версию графического API — Direct3D12. Первым тестом стал Dynamic Indexing (D3D12DynamicIndexing), использующий новые функции шейдерной модели Shader Model 5.1. В частности — динамическое индексирование и неограниченные массивы (unbounded arrays) для отрисовки одной модели объекта несколько раз, при этом материал объекта выбирается динамически по индексу. Этот пример активно использует целочисленные операции для индексации, поэтому особенно интересен нам для тестирования графического процессора Turing. Для увеличения нагрузки на GPU мы модифицировали пример, увеличив число моделей в кадре относительно оригинальных настроек в 100 раз. Общая производительность рендеринга в этом тесте зависит от видеодрайвера, командного процессора и мультипроцессоров GPU. Решения Nvidia в тесте явно лучше справляются с этими операциями, а одновременное исполнение INT32- и FP32-инструкций даже на урезанном графическом процессоре TU106 позволило рассматриваемой нами новинке подобраться к лучшему игровому решению семейства Pascal. В итоге новинка отстала от RTX 2070 примерно столько, сколько и должна по теории. А вот условный конкурент в виде Radeon RX Vega 64 работает в этот раз не слишком эффективно, отстав чуть ли не вдвое. Очередной пример из Direct3D12 SDK — Execute Indirect Sample, он создает большое количество вызовов отрисовки при помощи ExecuteIndirect API, с возможностью модификации параметров отрисовки в вычислительном шейдере. В тесте используется два режима. В первом на GPU выполняется вычислительный шейдер для определения видимых треугольников, после чего вызовы отрисовки видимых треугольников записываются в UAV-буфер, откуда запускаются посредством ExecuteIndirect-команд, таким образом на отрисовку отправляются только видимые треугольники. Второй режим отрисовывает все треугольники подряд без отбрасывания невидимых. Для увеличения нагрузки на GPU число объектов в кадре увеличено с 1024 до 1 048 576 штук. Производительность в этом тесте зависит от драйвера, командного процессора и мультипроцессоров GPU. Все видеокарты компании Nvidia справились с задачей хорошо (с учетом большого количества обрабатываемой геометрии) и примерно одинаково, что говорит скорее об упоре в возможности драйвера. А вот Radeon RX Vega 64 серьезно отстала от них. Вероятно, дело просто в недостатке программной оптимизации — драйверы компании AMD нуждаются в улучшении. Ну и последний пример с поддержкой D3D12 — уже известный нам nBody Gravity тест, но в другом варианте. В этом примере из SDK показана расчетная задача гравитации N-тел (N-body) — симуляция динамической системы частиц, на которую воздействуют такие физические силы, как гравитация. Для увеличения нагрузки на GPU число N-тел в кадре было увеличено с 10 000 до 128 000. По количеству кадров в секунду даже на мощных GPU хорошо видно, что эта вычислительная задача очень сложна, даже на топовой GeForce RTX 2080 Ti получается около 30 FPS. Самая доступная новинка из серии GeForce RTX, основанная на урезанном графическом процессоре TU106 не смогла догнать ни топовое решение из предшествующего семейства видеокарт GeForce, ни лучшую из видеокарт конкурирующей компании. Впрочем, разница между ними мизерная. А отставание от RTX 2070 примерно соответствует теории. В качестве дополнительного синтетического теста с поддержкой Direct3D12 мы взяли известный бенчмарка Time Spy из 3DMark. В нем нам интересно не только общее сравнение GPU по мощности, но и разница в производительности с включенной и отключенной возможностью асинхронных вычислений, появившихся в DirectX 12. Так мы поймем, изменилось ли что-то в поддержке async compute в Turing. Для верности мы протестировали видеокарты Nvidia в двух разрешениях экрана и двух графических тестах. По представленным диаграммам хорошо видно, что прирост от включения асинхронных вычислений в Time Spy слабо изменился между двумя поколениями GPU. Для Pascal это 3%-7%, а для Turing уже 5%-10% (в зависимости от режима). В новых графических процессорах одновременное исполнение разных типов вычислений было улучшено, на одном и том же шейдерном мультипроцессоре архитектуры Turing могут запускаться и графические и вычислительные шейдеры. Бенчмарк Time Spy использует такие возможности слабо, поэтому и разница невелика. Если рассматривать производительность GeForce RTX 2060 в этой задаче по сравнению с другими моделями Nvidia, то мы видим, что новинка отстает от RTX 2070 более чем на 20%, что чуть хуже теоретических показателей. Возможно, сказывается сравнительно небольшой объем видеопамяти. Новинка не способна догнать более мощную модель GTX 1080 Ti, но она явно ближе к ней, чем в других синтетических тестах, что настраивает на оптимистичный лад. С появлением DXR API в последнем обновлении Microsoft Windows 10 стало возможно как аппаратное ускорение трассировки лучей на специализированных RT-ядрах, имеющихся в чипах архитектуры Turing, так и выполняемое на универсальных CUDA-ядрах. Так как видеокарты семейства Pascal тоже поддерживают DXR API, хотя изначально Nvidia не планировала делать его поддержку на своих решениях ниже архитектуры Volta, иногда можно сравнить производительность трассировки на различных семействах GeForce. Таких тестов и демок пока что немного. Хорошо уже то, что у нас есть демо-программа Reflections компании Epic Games, которая совместно с ILMxLAB и Nvidia сделала свой вариант демонстрации возможностей трассировки лучей в реальном времени — с использованием движка Unreal Engine 4 и технологию Nvidia RTX. Для построения этой 3D-сцены разработчики использовали реальные ресурсы из фильмов серии Star Wars. Эта технологическая демонстрация отличается качественным динамическим освещением, а также эффектами, полученными при помощи трассировки лучей, включая качественные мягкие тени от площадных источников света (area lights), имитацию глобального затенения Ambient Occlusion и фотореалистичные отражения — все это отрисовывается в реальном времени с очень высоким качеством. Также используется качественное шумоподавление результата трассировки из пакета Nvidia GameWorks, пусть пока что и без использования нейросетей и тензорных ядер. Посмотрим, что получается с производительностью: Это одна из самых впечатляющих презентаций возможностей трассировки лучей до сих пор, и весной ее показывали на мощнейшей рабочей станции DGX Station, включающей аж четыре графических процессора архитектуры Volta. Но затем оказалось, что она заработала и на одной GeForce GTX 1080 Ti. Пусть и с явным недостатком производительности, но 6-10 FPS — это точно было лучше наших ожиданий. Новые видеокарты семейства GeForce RTX могут справиться с трассировкой в реальном времени с неплохой производительностью при условии работы над ней единственного GPU. Очередная модель семейства Turing в этой задаче оказалась заметно быстрее лучшей из семейства Pascal — частота кадров на новом решении примерно втрое выше. А вот от старшей сестры RTX 2070 новинка отстала по минимальному показателю FPS довольно прилично, что говорит о том, что эта демо-программа нуждается в большом объеме видеопамяти. В остальном, урезанный TU106 справился с задачей неплохо, почти достав до 30 FPS в среднем. Еще одним новым тестом производительности трассировки лучей стал наконец-то вышедший бенчмарк 3DMark Port Royal создателей известных тестов серии 3DMark. В прошлых статьях мы использовали очень сырую технодемку, но без точных результатов, а теперь тестируем в полноценном бенчмарке, который работает на всех графических процессорах с поддержкой DXR API, для чего нужно октябрьское обновление Windows 10. Мы проверили три видеокарты нового семейства в разрешении 2560×1440 при различных настройках, когда отражения рассчитываются при помощи трассировки лучей и традиционным для растеризации методом. Бенчмарк показывает сразу несколько новых возможностей применения трассировки лучей через DXR API, в нем используются алгоритмы отрисовки отражений и теней с применением трассировкой лучей, но бенчмарк то ли в целом не слишком оптимизирован, то ли сильно загружает даже мощные GPU, так как даже на GeForce RTX 2080 мы получили лишь чуть больше 30 FPS даже при традиционной отрисовке отражений. Но для сравнения производительности разных GPU в трассировке лучей тест в целом все равно подходит. Отметим сравнительно низкий результат для GeForce RTX 2060 — новинка отстает от модели на ступеньку старше куда больше, чем в других синтетических тестах. Похоже, что сцены 3DMark Port Royal слишком требовательны к объему видеопамяти, и даже такой же графический процессор TU106, пусть и с частично отключенными аппаратными блоками трассировки лучей, не может тут показать достаточно высокую производительность. Наши выводы подтверждаются и натуральным слайд-шоу при рендеринге в 4K-разрешении, а также тем, что включение традиционного метода рендеринга отражений не меняет относительный результат новинки — она все так же сильно отстает от RTX 2070. Мы пока еще не нашли возможность включить в состав нашего пакета синтетических тестов другие бенчмарки, использующие OpenCL для интересных нам вычислительных тестов. Пока что в этом разделе остается уже довольно старый и не слишком хорошо оптимизированный тест трассировки лучей, но не аппаратной — LuxMark 3.1. Этот кроссплатформенный тест основан на LuxRender и также использует OpenCL. Мы сравнили три разных GPU компании Nvidia в этом тесте и в этот раз получилось, что новая GeForce RTX 2060 оказалась значительно медленнее RTX 2070, что трудно объяснить теоретическими показателями. Даже GTX 1080 Ti из предыдущего семейства оказалась быстрее, хоть и не слишком сильно. Неплохой результат всех Turing обусловлен изменениями в системе кэширования, но даже при этом они отстают от лучших из Radeon, если бы мы добавили в этот тест любую из Vega. Но мы рассмотрим еще один тест производительности — улучшения изображения методом DLSS, который использует возможности специализированных тензорных ядер, ускоряющих задачи глубокого обучения. Натренированная нейросеть использует тензорные ядра, имеющиеся в чипах архитектуры Turing для того, чтобы «дорисовывать» изображение, улучшая его качество выше уровня распространенного метода сглаживания TAA. По сути, DLSS можно использовать или для «дешевого» повышения разрешения рендеринга, или для улучшения качества — аналогично суперсэмплингу (впрочем, пока что этот метод недоступен ни в одной игре). При тестировании мы использовали бенчмарк Final Fantasy XV Benchmark, который был обновлен для поддержки DLSS-сглаживания. Обновленный тест производительности на базе игрового движка раскрывает явные преимущества DLSS, обеспечивающего качество картинки не хуже, чем с применением TAA при рендеринге в 4K-разрешении, и показывает примерно на треть более высокую производительность при этом: Вот такие тесты и показывают новые возможности GPU современного поколения со специализированными блоками, ускоряющими какие-то конкретные задачи. Нам больше всего интересно сравнение GeForce RTX 2060 и GTX 1080 Ti. Если при использовании сглаживания методом TAA средняя скорость смены частоты кадров у рассматриваемой сегодня новинки линейки GeForce RTX была заметно ниже, что близко к теории, то при задействовании алгоритма DLSS, у GPU новой архитектуры открывается второе дыхание, и она хоть и не догоняет лучший GPU из семейства Pascal, но подбирается к нему довольно близко. Увы, лишь по среднему показателю частоты кадров, а вот минимальный FPS на RTX 2060 получился очень низким — вероятно, из-за всего лишь 6 ГБ видеопамяти, которой не хватает этому тесту в 4K-разрешении. Выводы по теоретической части и синтетическим тестамСудя по теоретическим данным и синтетическим тестам, видеокарта модели GeForce RTX 2060, основанная на младшей версии графического процессора TU106 архитектуры Turing, занимает на рынке игровых видеокарт место GeForce GTX 1070/1070 Ti, хотя были в наших тестах и некоторые спорные результаты. Со старыми синтетическими бенчмарками у всех новых GPU линейки RTX дела обстоят не очень хорошо, но влияние архитектурных улучшений в Turing заметно в более новых тестах. Думаем, что в играх новинка должна быть примерно на уровне GTX 1070 Ti из предыдущей линейки. Nvidia лучше всех нас понимает, что им нужно наполнить рынок решениями серии GeForce RTX как можно быстрее, чтобы смысл от внедрения тензорных и RT-ядер никуда не пропал — ведь никто из разработчиков не горит писать специфический код для пары процентов пользователей только самых дорогих GPU. И RTX 2060 способны справиться с этой задачей лучше всех предыдущих решений семейства Turing, ведь именно новая модель является лучшим вариантом для апгрейда многих игровых ПК, в составе которых есть устаревшие видеокарты. Если смотреть на историю последних лет, то именно видеокарты этого уровня (260, 460, 660, 760, 1060) были самыми успешными и массовыми игровыми решениями для компании Nvidia. Именно такие GPU всегда занимают первые места в отчете Steam hardware survey, и это неудивительно — они являются «золотой серединой» и самыми выгодными предложениями на рынке. Необычно, что GeForce RTX 2060 основана на том же кристалле, что и RTX 2070, так как обычно этот уровень вводил совершенно новый GPU с лучшим соотношением производительности и сложности. Но с этим мы разобрались, на данном этапе Nvidia пришлось так сделать — пока что оптимизированный для этого ценового сегмента GPU делать не имело смысла, тем более что в RTX 2060 можно использовать отбраковку чипов TU106. Модификация с урезанным количеством практически всех исполнительных блоков оказалась весьма неплохой по тестам. Судя по всему, RTX 2060 близка по скорости к GTX 1070 Ti и конкурирующей модели Radeon RX Vega 56, имея дополнительные преимущества, о которых мы подробно рассказали. За свои деньги GeForce RTX 2060 предлагает как отличную производительность, так и очень хорошие функциональные возможности, и при выборе между RTX 2060, GTX 1070 Ti, GTX 1080 и Radeon RX Vega, с учетом всех факторов, именно у сегодняшней новинки есть явное преимущество над всеми конкурентами. Среди главных плюсов новой видеокарты — великолепная производительность на уровне GeForce GTX 1070 Ti, а также привлекательный дизайн и грамотная система охлаждения FE-варианта. Среди спорных, но скорее положительных — неплохая (пусть не низкая, но все же доступная) цена решения, а из потенциальных минусов GeForce RTX 2060 выделим всего лишь 6 ГБ локальной видеопамяти, что на сегодня может и достаточно, но может сказаться в следующие пару лет. Ну и не очень понятно, почему FE-издание этой модели осталось без фабричного разгона, который был у всех остальных видеокарт RTX-линейки. По сравнению с условными конкурентами, у GeForce RTX 2060 есть свои сильные и слабые стороны. Но в любом случае, новая видеокарта дает очень неплохую производительность в существующих проектах за приемлемую цену, а вместе с этим и возможность опробовать совершенно новые технологии, которые уже начали появляться в играх. Но пока что производительность в старых играх все же остается в приоритете. К проверке этого мы сейчас и переходим. Игровые тестыКонфигурация тестового стенда

Список инструментов тестированияВо всех играх использовалось максимальное качество графики в настройках.

Разница в производительности, %

Разница в производительности, %

Разница в производительности, %

Разница в производительности, %

Разница в производительности, %

Разница в производительности, %

Разница в производительности, %

Разница в производительности, %

Рейтинг iXBT.comРейтинг ускорителей iXBT.com демонстрирует нам функциональность видеокарт друг относительно друга и нормирован по самому слабому ускорителю — GeForce GT 1030 (то есть сочетание скорости и функций GeForce GT 1030 приняты за 100%). Рейтинги ведутся по 20 ежемесячно исследуемым нами акселераторам в рамках проекта Лучшая видеокарта месяца. Из общего списка выбирается группа карт для анализа, куда входят GeForce RTX 2060 и его конкуренты. Для расчета рейтинга полезности использованы розничные цены на конец января 2019 года.

Мы видим, что в среднем по всем играм и разрешениям GeForce RTX 2060 быстрее, чем GeForce GTX 1070 Ti и Radeon RX Vega 56, хотя те дороже. При изучении GeForce RTX 2070 мы уверенно говорили, что на нем можно прекрасно играть в разрешении 2.5К при максимальных настройках качества, лишь в паре игр придется снижать качество графики или разрешение. Понятно, что GeForce RTX 2060 нацелен уже, скорее, на разрешение Full HD без каких-либо компромиссов по качеству графики (все настройки на максимум!), а во многих играх он обеспечит хорошую играбельность и в 2.5К. Рейтинг полезностиРейтинг полезности тех же карт получается, если показатели предыдущего рейтинга разделить на цены соответствующих ускорителей.

Как и в случае с GeForce RTX 2070, мы удивлены тем, насколько резво новый продукт заявил о притязаниях на лидерство в своей группе. Если не брать в расчет Radeon RX 590, который все-таки по производительности конкурирует с GeForce GTX 1060, а не с GeForce RTX 2060, то это и вовсе чистая и уверенная победа. Нас всех можно поздравить с появлением нового очень выгодного ускорителя в ценовом диапазоне 28 000 — 35 000 рублей. ВыводыNvidia GeForce RTX 2060 продолжает традицию: он в очередной раз расширяет проникновение новых технологий трехмерной графики в геймерскую среду. Будучи немного медленнее, чем GeForce RTX 2070, он обеспечит приемлемую и даже хорошую производительность в разрешении 2.5К в части игр, а под разрешение Full HD подходит просто великолепно. Снова хочется выразить надежду, что новшества типа блока трассировки лучей и «умных» тензорных ядер помогут разработчикам в ближайшем будущем сделать игры более захватывающими в плане графики. То же относится и к технологии HDR, которая также становится все более актуальной в играх, и ее поддержку также обеспечивают GeForce RTX 2060/2070/2080/2080 Ti. GeForce RTX 2060 демонстрирует великолепный прирост производительности даже в обычных (без HDR/RT) играх относительно своего формального предка GeForce GTX 1060 (на десятки процентов), прилично обходит GeForce GTX 1070 (на 15% и более) и выходит примерно на уровень GeForce GTX 1070 Ti, который по позиционированию находится на ступень выше. Ближайший конкурент из стана AMD, Radeon RX Vega 56, отстает от RTX 2060 в среднем на 3%-6%, будучи дороже. Новый метод антиалиасинга DLSS вновь продемонстрировал свое преимущество и по скорости, и по качеству. Также новый ускоритель предлагает обновленный интерфейс VirtualLink для связи с устройствами виртуальной реальности следующего поколения. У конкретного протестированного нами видеоускорителя Nvidia GeForce RTX 2060 Founder’s Edition (6 ГБ) можно выделить относительно компактные размеры при сравнительно тихой СО. Итог: GeForce RTX 2060 получился очень успешным представителем нового семейства по соотношению возможностей и стоимости (в своем ценовом сегменте). Этот ускоритель поддерживает весь набор новых технологий, не так давно привнесенных в копилку индустрии 3D-графики игрового класса компанией Nvidia. Еще раз надо отметить отличную поддержку HDR всем семейством GeForce RTX. В номинации «Оригинальный дизайн» карта Nvidia GeForce RTX 2060 Founder’s Edition 6 ГБ получила награду: Благодарим компанию Nvidia Russia Для тестового стенда: Источник | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||