- Текстовый файл с linux кодировка

- Смена кодировки файлов в Ubuntu, а так же iconv и большие файлы

- iconv и большие файлы

- HowTo: Check and Change File Encoding In Linux

- Check a File’s Encoding

- Change a File’s Encoding

- List All Charsets

- 8 Replies to “HowTo: Check and Change File Encoding In Linux”

- Конвертирование файлов в кодировку UTF-8 в Linux

- Конвертирование файлов из UTF-8 в ASCII

- Конвертирование нескольких файлов в кодировку UTF-8

Текстовый файл с linux кодировка

Библиотека сайта rus-linux.net

Ошибка базы данных: Table ‘a111530_forumnew.rlf1_users’ doesn’t exist

Основная русская кодировка в Linux — это Koi-8. Но иногда требуется работать с текстами в основной кодировке Windows (cp1251), и другими кодировками русского языка. Для просмотра текстов в кодировках, отличных от koi-8 самый простой путь — это открыть этот текст в броузере и выбрать нужную кодировку. (Это — универсальный способ, и я пользуюсь только им). Но существуют и специальные программы для перекодировки русских текстов:

1) iconv. Стандартная программа, есть в любом дистрибутиве. Список доступных кодировок можно увидеть по команде iconv —list. Названия кодировок должны соответствовать их именам в /usr/share/i18n/charmaps. Пример использования: iconv -f CP1251 — t KOI8-R file.txt > file.new.txt перекодирует foo.txt из cp1251 в koi8-r.

2) recode. Еще одна стандартная программа для перекодировок текстов под Uinx/Linux.

3) Russian Anywhere for UNIX . Единственная программа для Linux, которая может автоматически определять кодировку текста. Но ссылка на домашней странице указывает на несуществующий файл, так что вам придется самим искать файл re-0.1-bin.tar.gz через Files.ru, Filesearch.ru или Reliz.ru.

4) ManChr 2 . Простейший скрипт для перекодировки русских текстов. Занимает всего 3 Kb в исходниках. 5 кодировок, просто и надежно :).

5) Tcod . Еще один простейший скрипт. Есть подозрение, что это — то же самое, что и пункт 3.

В большинстве программ под Linux можно использовать скрипты, так что процесс перекодировки можно элементарно заложить в скрипт и максимально упростить. Пример — просмотр текстов в кодировке cp1251 через Midnight Commander (Special Thanx 2 DeyS, http://deys.fromru.com ).

«Для того, чтобы просто читать, а не редактировать, я вставил в менюшку Миднайта (F2) команды, которые посылают перекодированный текс на Less. Это делается в файле /usr/lib/mc/mc.menu. Синтаксис довольно прост (я напишу в том виде, как это сделано у меня):

w Чтение в кодировке CP1251

iconv -f CP1251 -t KOI8-R %f | less -M

Для того, чтобы прочитать файл в кодировке СР1251, я просто выбираю его в панели (навожу на него курсор), нажимаю F2 и «горячую клавишу» w и все;)».

Теперь — более серьезная вещь: редактирование текстов в кодировке cp1251. Для этого просто достаточно выбрать шрифт с кодировкой cp1251, и все! Вот информация о том, как это сделать (опять же, Special Thanx 2 DeyS):

«А добавлять, например, CP1251 в систему не сложно. Если есть поддержка TrueType, то просто после того, как шрифты будут положены на место и будет сделана команда ttmkfdir, нужно в файлах fonts.dir и fonts.scale подредактировать некоторые строчки. Я делал так. Удалил из этих файлов все кодировки кроме «koi8-r» и «koi8-ru» и для каждого шрифта добавил запись с кодировкой «microsoft-cp1251». Потом посчитал сколько всего получилось строк и в начале файла (там стоит цифра, которая указывает на количество записей шрифтов) указал то, что у меня получилось. Теперь под Хами у меня есть возможность использовать шрифты в этих кодировках. Например, в nedit можно «на лету» просто поменять кодировку. Или запустить, к примеру, xedit, указав ему нужный шрифт. Оказалось, что все не так уж и сложно, хотя над этой проблемой я бился несколько месяцев..

Для большей наглядности — строки из файла fonts.scale для шрифта timesi.ttf:

timesi.ttf -monotype-Times New Roman-medium-i-normal—0-0-0-0-p-0-koi8-ru

timesi.ttf -monotype-Times New Roman-medium-i-normal—0-0-0-0-p-0-koi8-r

timesi.ttf -monotype-Times New Roman-medium-i-normal—0-0-0-0-p-0-microsoft-cp1251″.

Остается только добавить, что о добавлении шрифтов TTF и файле fonts.dir можно подробнее прочитать в выпуске #7 (статья «Подключаем TTF шрифты к X-Window»). Сам я это не пробовал (как всегда, не хватает времени), так что все комментарии — на deys@inbox.ru.

И еще в моей коллекции документов по Linux нашлось 2 документа по этой проблеме. Откуда я их скачал — не помню, так что ищите сами 🙂 по ключевым словам «Как я прикручивал кодировку cp1251 (Виндовс) к X-ам» и «Как я русифицировал свою консоль (включая и cp1251)». И вообще, если у вас есть какой-нибудь вопрос или проблема — качайте эту страничку (поиск по 18 поисковым системам Рунета с одной страницы), и ищите решение в Инете! Ведь документов по Linux в Интернете больше, чем документов по любой другой OS.

Источник

Смена кодировки файлов в Ubuntu, а так же iconv и большие файлы

Давно в категории «Ubuntu» у меня не было материалов. Сегодня я исправлюсь и выпущу сразу две статьи. Итак, начнём. вам приходилось менять кодировку текстовых файлов в linux’e? А что если объем такого файла больше 10 Gb?!

Что бы изменить кодировку файла нужно использовать замечательную утилиту iconv. В параметрах необходимо указывать исходную кодировку, а в этом нам поможет команда:

Ну а далее вот такие действия:

iconv -f WINDOWS-1251 -t UTF-8 -o output_file.txt original_file.txt

- -f WINDOWS-1251 — исходная кодировка,

- -t UTF-8 — конечная

- -o output_file.txt — куда выводить результат

- original_file.txt — исходный файл

Остальные ключики как обычно в man iconv.

iconv и большие файлы

Для быстрого выполнения процесса кодировки, iconv загружает файл в оперативную память и в swap. Но это работает только для небольших файлов. Если файл уж совсем большой, а ОЗУ не особо, то вы прост получите ошибку, мол «слишком большой файл», звиняйте хлопцы. Где взять такой файл? К примеру это может быть выборка из БД ( игры для ipad, PC, PSP или другие данные)

Вот здесь предлагают различные решения данного вопроса: и скриптами, и разбивка на части, вывод в потоки, а потом обратно сборка в файл. Лично мне понравилось весьма простое решение: команда split — она позволяет разбить текстовый файл на более мелкие, а дальше с ними работать как угодно можно.

В простом варианте чтобы разбить файл на куски объёмом по 1Gb выполнить:

Это самые просты решения, эти команды можно использовать в различных скриптах и получить от этого много кайфов. Надеюсь эта заметка вам чем-то помогла.

Источник

HowTo: Check and Change File Encoding In Linux

The Linux administrators that work with web hosting know how is it important to keep correct character encoding of the html documents.

From the following article you’ll learn how to check a file’s encoding from the command-line in Linux.

You will also find the best solution to convert text files between different charsets.

I’ll also show the most common examples of how to convert a file’s encoding between CP1251 (Windows-1251, Cyrillic), UTF-8 , ISO-8859-1 and ASCII charsets.

Cool Tip: Want see your native language in the Linux terminal? Simply change locale! Read more →

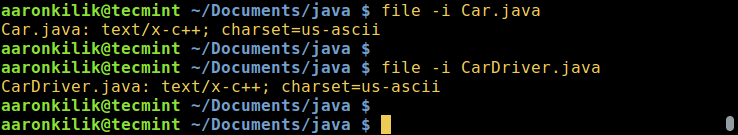

Check a File’s Encoding

Use the following command to check what encoding is used in a file:

| Option | Description |

|---|---|

| -b , —brief | Don’t print filename (brief mode) |

| -i , —mime | Print filetype and encoding |

Check the encoding of the file in.txt :

Change a File’s Encoding

Use the following command to change the encoding of a file:

| Option | Description |

|---|---|

| -f , —from-code | Convert a file’s encoding from charset |

| -t , —to-code | Convert a file’s encoding to charset |

| -o , —output | Specify output file (instead of stdout) |

Change a file’s encoding from CP1251 (Windows-1251, Cyrillic) charset to UTF-8 :

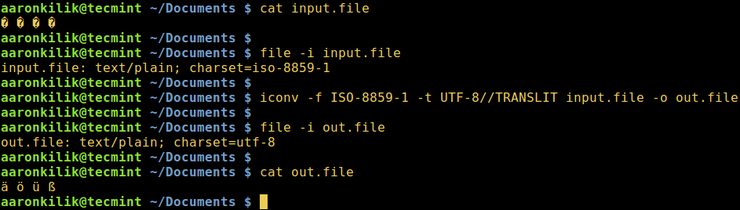

Change a file’s encoding from ISO-8859-1 charset to and save it to out.txt :

Change a file’s encoding from ASCII to UTF-8 :

Change a file’s encoding from UTF-8 charset to ASCII :

Illegal input sequence at position: As UTF-8 can contain characters that can’t be encoded with ASCII, the iconv will generate the error message “illegal input sequence at position” unless you tell it to strip all non-ASCII characters using the -c option.

| Option | Description |

|---|---|

| -c | Omit invalid characters from the output |

You can lose characters: Note that if you use the iconv with the -c option, nonconvertible characters will be lost.

This concerns in particular Windows machines with Cyrillic.

You have copied some file from Windows to Linux, but when you open it in Linux, you see “Êàêèå-òî êðàêîçÿáðû” – WTF!?

Don’t panic – such strings can be easily converted from CP1251 (Windows-1251, Cyrillic) charset to UTF-8 with:

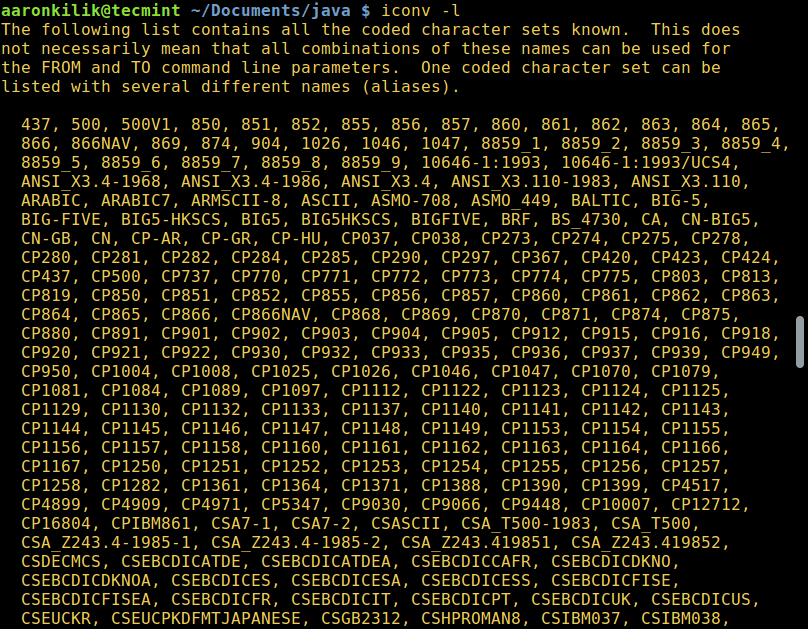

List All Charsets

List all the known charsets in your Linux system:

| Option | Description |

|---|---|

| -l , —list | List known charsets |

8 Replies to “HowTo: Check and Change File Encoding In Linux”

Thank you very much. Your reciept helped a lot!

I am running Linux Mint 18.1 with Cinnamon 3.2. I had some Czech characters in file names (e.g: Pešek.m4a). The š appeared as a ? and the filename included a warning about invalid encoding. I used convmv to convert the filenames (from iso-8859-1) to utf-8, but the š now appears as a different character (a square with 009A in it. I tried the file command you recommended, and got the answer that the charset was binary. How do I solve this? I would like to have the filenames include the correct utf-8 characters.

Thanks for your help–

Вообще-то есть 2 утилиты для определения кодировки. Первая этo file. Она хорошо определяет тип файла и юникодовские кодировки… А вот с ASCII кодировками глючит. Например все они выдаются как буд-то они iso-8859-1. Но это не так. Тут надо воспользоваться другой утилитой enca. Она в отличие от file очень хорошо работает с ASCII кодировками. Я не знаю такой утилиты, чтобы она одновременно хорошо работала и с ASCII и с юникодом… Но можно совместить их, написав свою. Это да. Кстати еnca может и перекодировать. Но я вам этого не советую. Потому что лучше всего это iconv. Он отлично работает со всеми типами кодировок и даже намного больше, с различными вариациями, включая BCD кодировки типа EBCDIC(это кодировки 70-80 годов, ещё до ДОСа…) Хотя тех систем давно нет, а файлов полно… Я не знаю ничего лучше для перекодировки чем iconv. Я думаю всё таки что file не определяет ASCII кодировки потому что не зарегистрированы соответствующие mime-types для этих кодировок… Это плохо. Потому что лучшие кодировки это ASCII.

Для этого есть много причин. И я не знаю ни одной разумной почему надо пользоваться юникодовскими кроме фразы “США так решило…” И навязывают всем их, особенно эту utf-8. Это худшее для кодирования текста что когда либо было! А главная причина чтобы не пользоваться utf-8, а пользоваться ASCII это то, что пользоваться чем-то иным никогда не имеет смысла. Даже в вебе. Хотите значки? Используйте символьные шрифты, их полно. Не вижу проблем… Почему я должен делать для корейцев, арабов или китайцев? Не хочу. Мне всегда хватало русского, в крайнем случае английского. Зачем мне ихние поганые языки и кодировки? Теперь про ASCII. KOI8-R это вычурная кодировка. Там русские буквы идут не по порядку. Нормальных только 2: это CP1251 и DOS866. В зависимости от того для чего. Если для графики, то безусловно CP1251. А если для полноценной псевдографики, то лучше DOS866 не придумали. Они не идеальны, но почти… Плохость utf-8 для русских текстов ещё и в том, что там каждая буква занимает 2 байта. Там ещё такая фишка как во всех юникодах это indian… Это то, в каком порядке идут байты, вначале младший а потом старший(как в памяти по адресам, или буквы в словах при написании) или наоборот, как разряды в числе, вначале старшие а потом младшие. А если символ 3-х, 4-х и боле байтов(до 16-ти в utf-8) то там кол-во заморочек растёт в геометрической прогрессии! Он ещё и тормозит, ибо каждый раз надо вычислять длину символа по довольно сложному алгоритму! А ведь нам ничего этого не надо! Причём заметьте, ихние англицкие буквы идут по порядку, ничего не пропущено и все помещаются в 1-м байте… Т.е. это искусственно придуманые штуки не для избранных америкосов. Их это вообще не волнует. Они разом обошли все проблемы записав свой алфавит в начало таблицы! Но кто им дал такое право? А все остальные загнали куда подальше… Особенно китайцев! Но если использовать CP1251, то она работает очень быстро, без тормозов и заморочек! Так же как и английские буквы…

а вот дальше бардак. Правда сейчас нам приходится пользоваться этим utf-8, Нет систем в которых бы системная кодировка была бы ASCII. Уже перестали делать. И все файлы системные именно в uft-8. А если ты хочешь ASCII, то тебе придётся всё время перекодировать. Раньше так не надо было делать. Надеюсь наши всё же сделают свою систему без ихних штатовких костылей…

Уважаемый Анатолий, огромнейшее Вам спасибо за упоминание enca. очень помогла она мне сегодня. Хотя пост Ваш рассистский и странный, но, видимо, сильно наболело.

Источник

Конвертирование файлов в кодировку UTF-8 в Linux

Оригинал: How to Convert Files to UTF-8 Encoding in Linux

Автор: Aaron Kili

Дата публикации: 2 ноября 2016 года

Перевод: А. Кривошей

Дата перевода: ноябрь 2017 г.

В этом руководстве мы рассмотрим кодировки символов и разберем несколько примеров преобразования файлов из одной кодировки в другую с помощью утилиты командной строки. Затем мы покажем, как преобразовать файлы в Linux из любой кодировки (charset) в UTF-8.

Как вы, наверное, уже знаете, компьютер не понимает и не хранит информацию в виде букв, цифр или чего-либо еще. Он работает только с битами. Бит имеет только два возможных значения — 0 или 1, true или false, да или нет. Все остальное кодируется последовательностями битов.

Простыми словами, кодировка символов — это способ кодировки различных символов определенными последовательностями нулей и единиц. Когда мы вводим текст и сохраняем его в файл, слова и предложения, которые мы набираем, состоят из разных символов, а символы преобразуются в биты с помощью кодировки.

Существуют различные схемы кодирования, такие как ASCII, ANSI, Unicode и другие. Ниже приведен пример кодировки ASCII.

В Linux для преобразования текста из одной кодировки в другую используется утилита командной строки iconv.

Вы можете проверить кодировку файла с помощью команды file, используя флаг -i или -mime, который печатает строку типа mime, как в приведенных ниже примерах:

Синтаксис команды iconv следующий:

Где -f или —from-code задает входную кодировку, а -t или —to-encoding задает конечную кодировку.

Для того, чтобы вывести список всех доступных опций, введите:

Конвертирование файлов из UTF-8 в ASCII

Далее мы научимся конвертировать текст из одной кодировки в другую. Приведенная ниже команда преобразует текст из ISO-8859-1 в кодировку UTF-8.

Рассмотрим файл input.file, который содержит следующие символы:

(Прим: вы увидите эти символы на снимке ниже)

Начнем с проверки кодировки файла, затем просмотрим его содержимое. Мы можем преобразовать все символы в кодировку ASCII.

После запуска команды iconv мы затем проверяем содержимое выходного файла и новую кодировку, как показано ниже.

Примечание. Если в команду добавлена строка //IGNORE, то символы, которые не могут быть преобразованы, и ошибка выводятся после преобразования.

Далее, если добавлена строка //TRANSLIT, как в приведенном выше примере (ASCII//TRANSLIT), преобразуемые символы при необходимости и по возможности транслитерируются. Это означает, что если символ не может быть представлен в целевой кодировке, его можно аппроксимировать одним или несколькими похожими символами.

Далее, любой символ, который не может быть транслитерирован и которого нет в целевой кодировке, заменяется в выводе вопросительным знаком (?).

Конвертирование нескольких файлов в кодировку UTF-8

Возвращаясь к основной теме нашей статьи, мы можем написать небольшой скрипт для преобразования нескольких или всех файлов в каталоге в кодировку UTF-8, под названием encoding.sh:

Сохраните этот файл и сделайте скрипт исполняемым. Запускайте его из той директории, где расположены ваши файлы.

Важное замечание. Вы также можете также использовать этот скрипт для преобразования нескольких файлов из одной заданной кодировки в другую (любую), просто меняйте со значения переменных FROM_ENCODING и TO_ENCODING, не забывая об имени выходного файла «$

Для получения дополнительной информации почитайте руководство iconv:

Подводя итог этой статье, необходимо отметить, что понимание способов преобразования текста из одной кодировки в другую — это знания, необходимые каждому пользователю компьютера, а тем более программистам, когда дело касается работы с текстами.

Если вы хотите лучше понять проблему кодировок символов, прочитайте следующие статьи:

Источник