- Vmware windows cluster disk

- Что такое общий диск Multi-writer в VMware ESXI

- Для чего применяют Multi-Writer диск

- Ограничения общих дисков VMware ESXI

- Как подключить общий диск в VMware ESXI 6.5 и выше

- Включение общего диска для ESXI 5.5 и ниже

- Vmware windows cluster disk

- Что такое RDM диск (Raw Device Mappings)

- Где используются RDM диски

- Режимы работы RDP дисков

- Режим физической совместимости (RDM Physiacal Mode)

- Режим виртуальной совместимости (RDM Virtual Mode)

- Кластеризация гостевых ОС

- Как создать кластерный RDM диск в VMware ESXI 6.5

- Нюансы Vmotion и Storage Vimotion

- Нюансы расширения RDM дисков

Vmware windows cluster disk

Доброго времени суток! Многоуважаемые инженеры по виртуализации, рад, что вы вновь посетили профильный блог Pyatilistnik.org. В прошлый раз мы с вами подробно разобрали механизм применения утилиты Robocopy и научились с ее помощью реализовывать всевозможные сценарии копирования данных. Сегодня я бы хотел вам рассказать, о создании общих дисков (Multi-writer) в VMware ESXI 5.5, 6.5 и выше, для кластерных решений Oracle RAC и Microsoft MSCS кластер.В век виртуализации, данная информация все больше становится актуальней.

Что такое общий диск Multi-writer в VMware ESXI

Сейчас уже очень сложно себе представить серьезный сервис без отказоустойчивости, которая может быть реализована на разных уровнях работы инфраструктуры. Очень частым решением выступает отказоустойчивый кластер, который подразумевает использование разных серверов для одного сервиса. Выход из строя одного из серверов не влияет на работоспособность предоставляемых услуг клиентам. Очень часто в кластерах используются общие диски, для хранения баз данных (Microsoft SQL или Oracle), файловые ресурсов. Общие диски могут презентованы, как отдельные LUN с СХД, через ISCSI протокол, через общий диск или RDM в случае с виртуальными машинами.

В данной заметке я опишу реализацию с помощью общего диска для виртуальных машин VMware ESXI 6.5. В некоторых случаях (как правило, в сценариях кластеризации) может потребоваться совместное использование одного и того же диска между двумя (или более) виртуальными машинами. Наиболее оптимальным способом является использование диска vmdk, физически расположенного на общем хранилище или локально на хосте ESXi. Если вы хотите использовать общие диски на разных хостах ESXi, то вы можете использовать только разделяемое хранилище

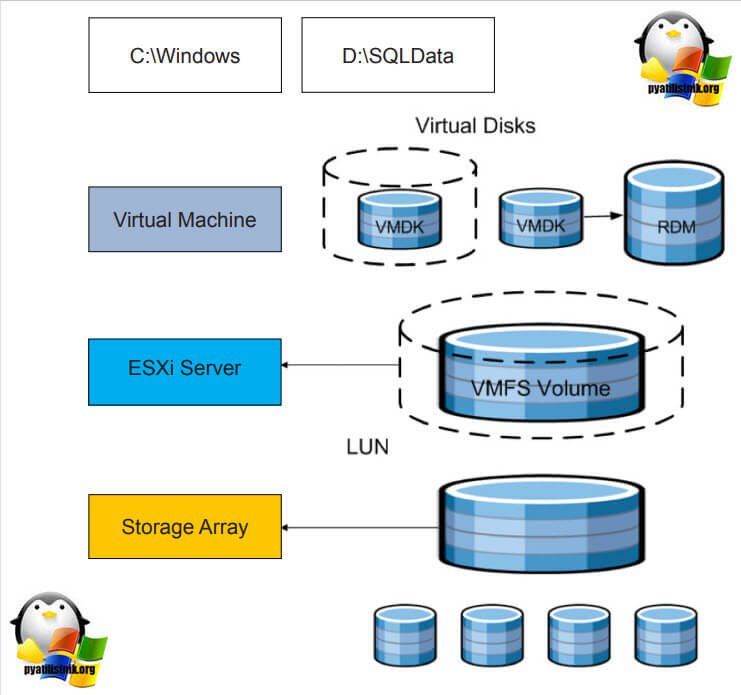

.На представленной ниже схеме вы видите:

- Storage Array, по сути это ваша система хранения данных, на которой реализован RAID массив, по рекомендации производителя.

- RAID массив порезан на LUN, это логически порезанное место на вашей системе хранения данных

- Далее LUN презентуется хостам VMware ESXI 6.5 и размечается файловой системой VMFS 6. Где из LUN получаются разделы (Datastore-Volume) для гипервизора.

- Далее на на Datastore уже разворачиваются виртуальные машины

Вот на таком общем VMFS Volume диске вы создаете общий VMDK диск, который будет доступен двум и более виртуальным машинам под чтение и запись. Сами виртуальные машины могут находится на разных физических хостах и разных географических локациях.Такой режим называется Multi-Writer VMDK, его часто применяют в построении кластеров MS SQL, Oracle RAC, такой режим работы диска применяется в технологии VMware Fault Tolerance.

Для чего применяют Multi-Writer диск

- Во первых, как я и писал выше для отказоустойчивости различных сервисов, сервера которых могут быть в разных ЦОДах.

- Во вторых для возможности обслуживания важных серверов, без их простаивания. Например, чтобы была возможность своевременно производить обновление Windows пакетов, другого программного обеспечения, иметь возможность перезагружать сервер

- В целях тестирования кластерных технологий, когда у вас нет СХД и нет возможности реализовать общий диск, по FC или ISCSI протоколу

Ограничения общих дисков VMware ESXI

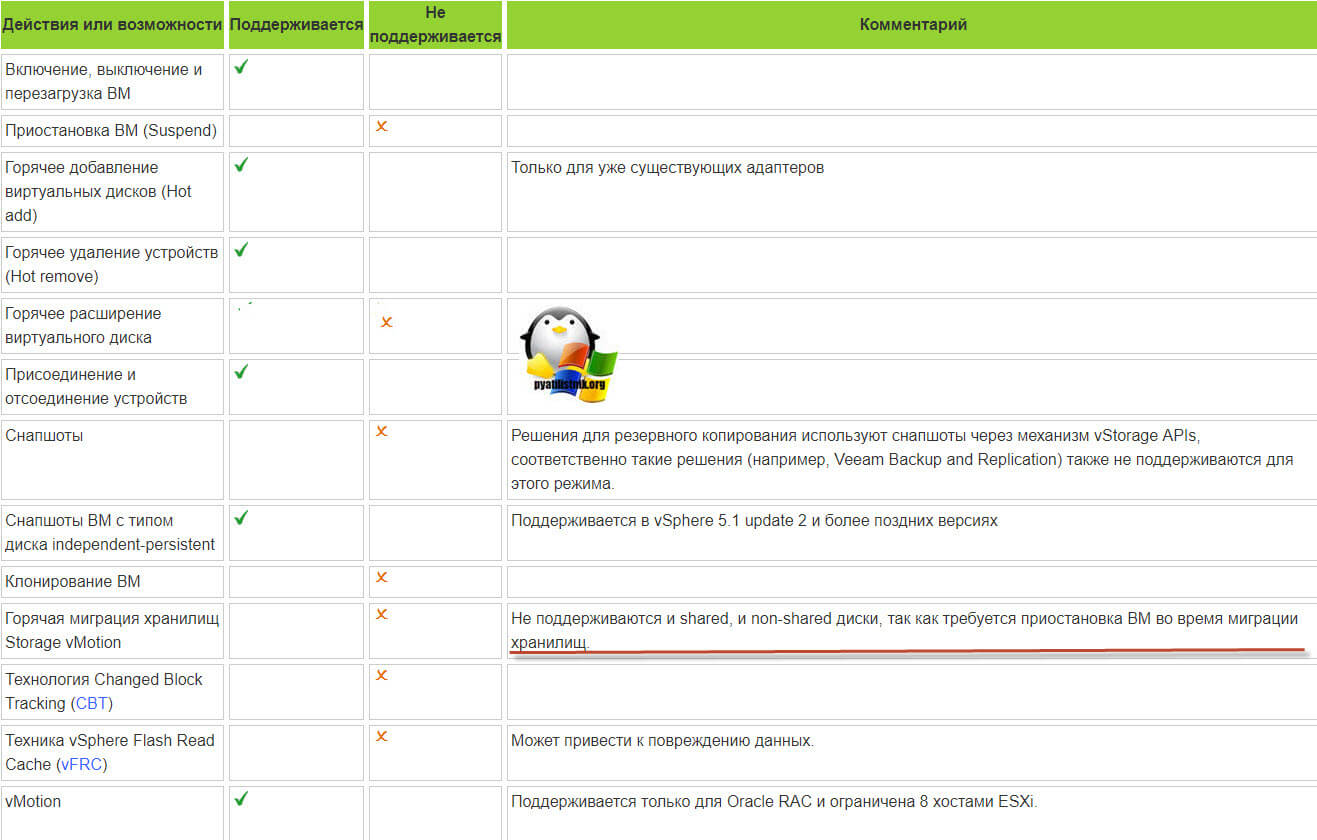

Без некоторых нюансов все же не обошлось, хочу выделить некоторые ограничения при использовании общих дисков:

Например, при попытке сделать Storage vMotion вы получите ошибку:

Если нужно будет мигрировать, то придется выключать виртуалку.

- Вы не сможете на живую произвести расширение дисков, при попытке вы получите вот такую ошибку:

- Если вы вдруг разметите оба диска в NTFS на двух хостах и попытаетесь на них писать, создав на одном одну папку, а на втором вторую, то хосты эти папки не увидят, каждый свою, учтите, это вам не общий диск с синхронизацией файлов, Multi-Writer VMDK именно нужен для кластеризации.

Как подключить общий диск в VMware ESXI 6.5 и выше

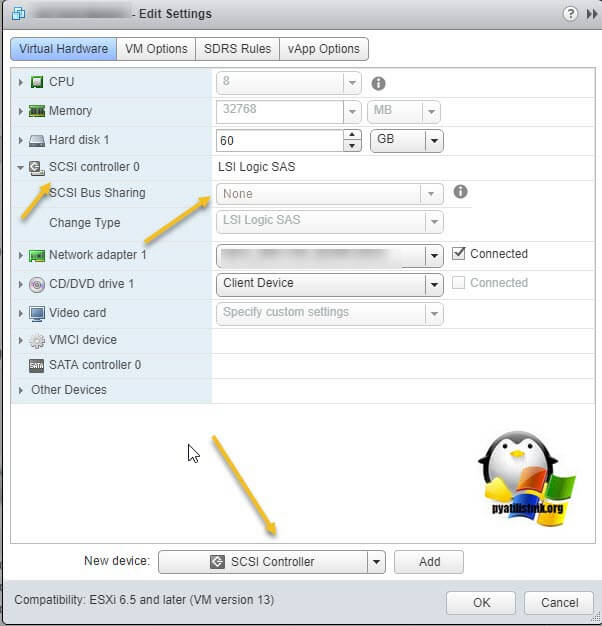

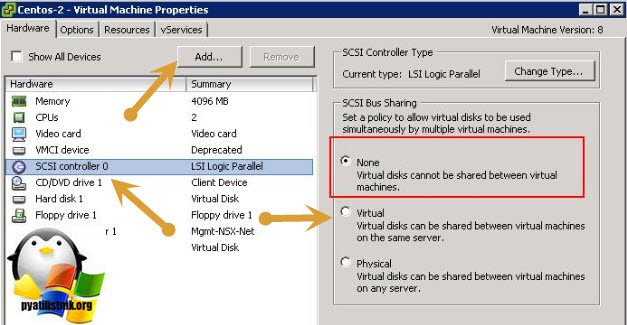

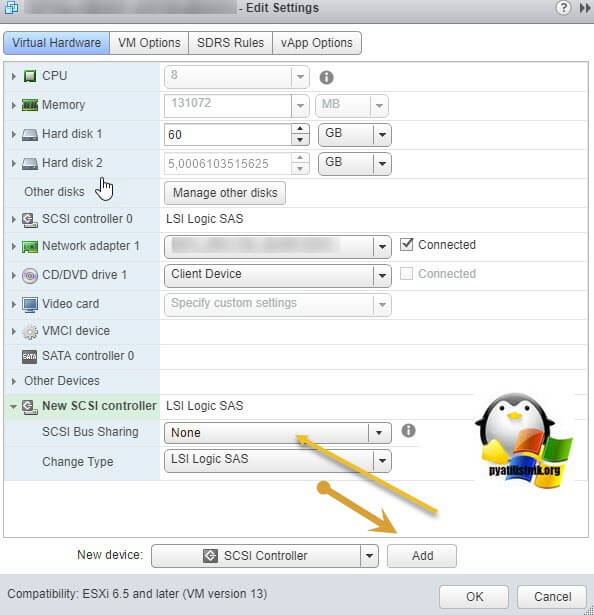

Предположим, что общее внешнее хранилище (подключенное к каждому хосту ESXi с использованием iSCSI или Fibre Channel SAN) уже представлено всем хостам VMWare ESXi, на которых запущены виртуальные машины, которым вы хотите добавить общий виртуальный диск. На обеих виртуальных машинах вам нужно добавить новый контроллер SCSI. Объясню для чего нужно добавлять новый SCSI Controller. Когда вы создаете новую виртуальную машину ESXI у вас по умолчанию уже будет один LSI Logic SAS контроллер (SCSI Controller), но он работает во первых в режиме SCSI Bus Sharing «None», то есть не работает с общими дисками VMDK, это можно поправить при выключенной машине, но VMWare не рекомендует совмещать при работе обычных дисков и Multi-Writer VMDK дисков на одном LSI Logic SAS контроллере.

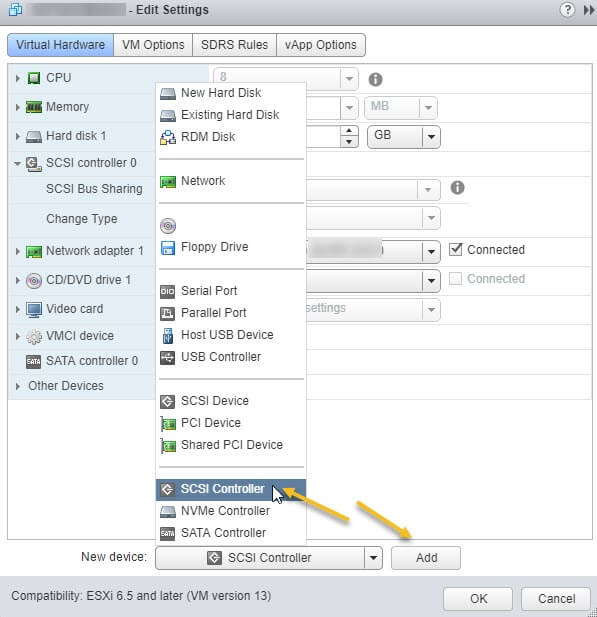

Поэтому нам первым делом необходимо в свойствах виртуальной машины добавить новый SCSI Controller.

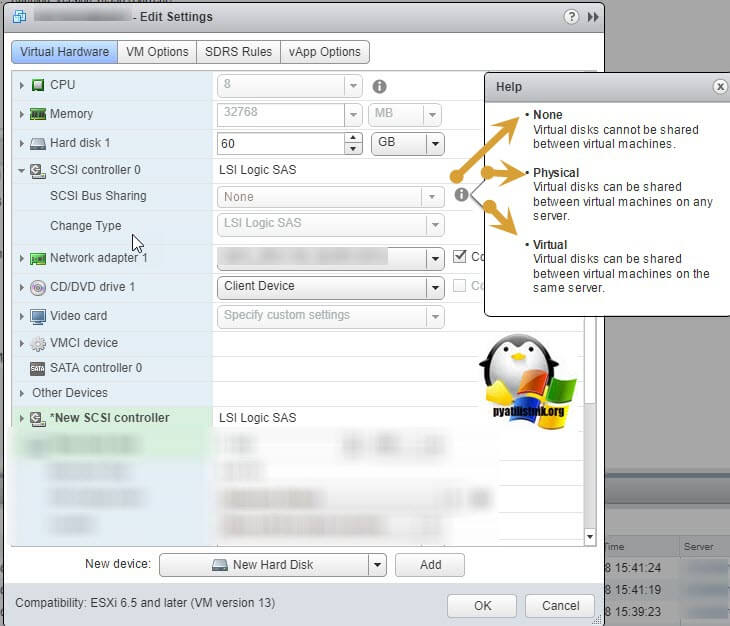

Если посмотреть подсказку у LSI Logic SAS контроллера, то вы увидите три его режима:

- None — для работы с не кластерными Multi-Writer дисками

- Physical — виртуальные диски могут быть общими для виртуальной машины и физическим сервером

- Virtual — для работы с общим диском для нескольких виртуальных машин

Делается это через пункт «New Device» и нажатии кнопки Add, для SCSI Controller.

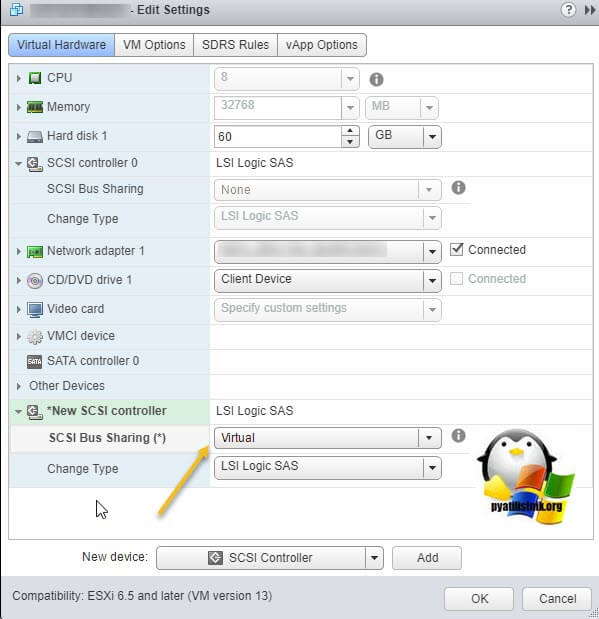

Далее у нового, добавленного контроллера вы в пункте «SCSI Bus Sharing» выберите тип «Virtual». Можете сохранить конфигурацию виртуальной машины, через нажатие кнопки «Ок»

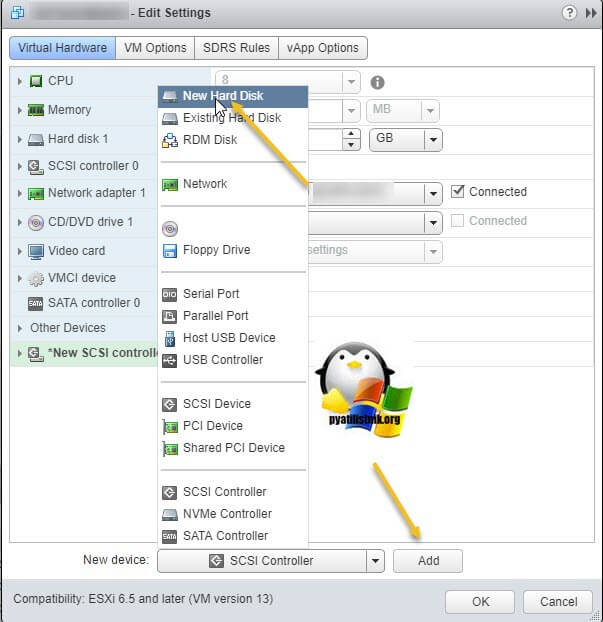

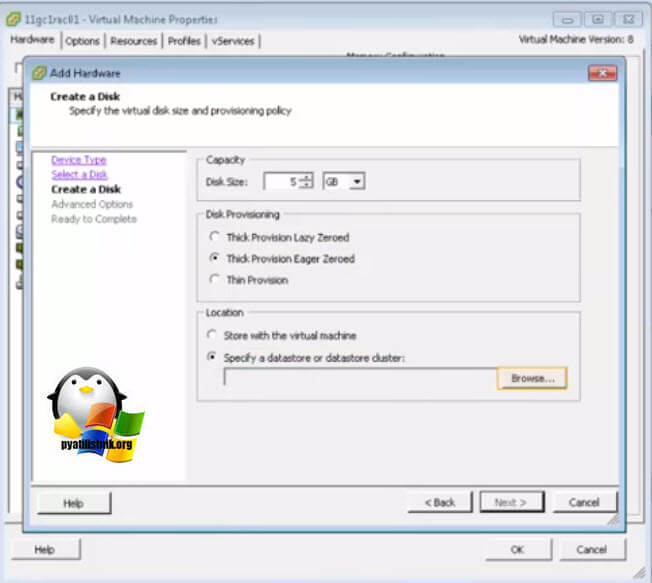

Далее на первой машине, где мы только что добавили новый контроллер, вам нужно создать новый виртуальный диск, делается это так же, через пункт «New Device»

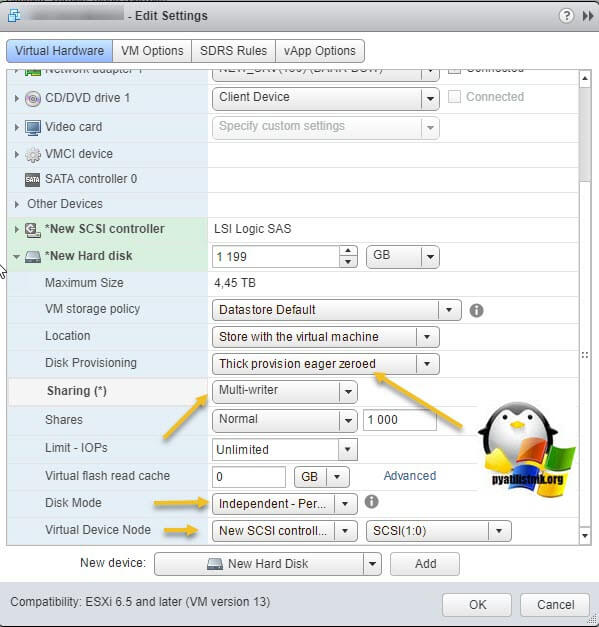

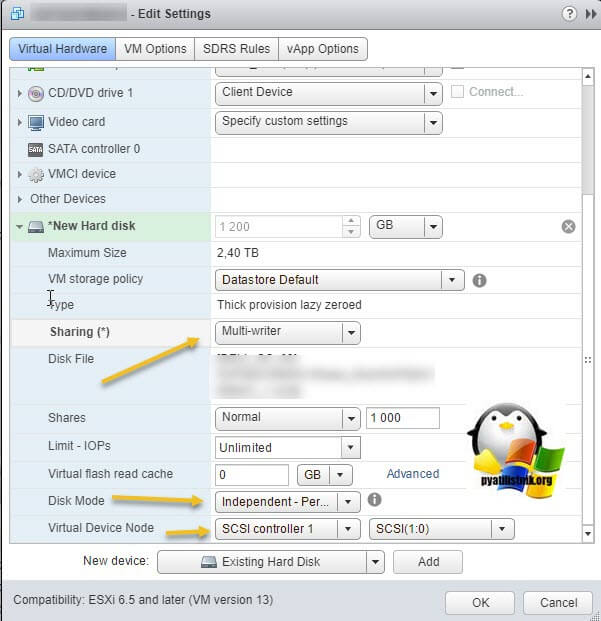

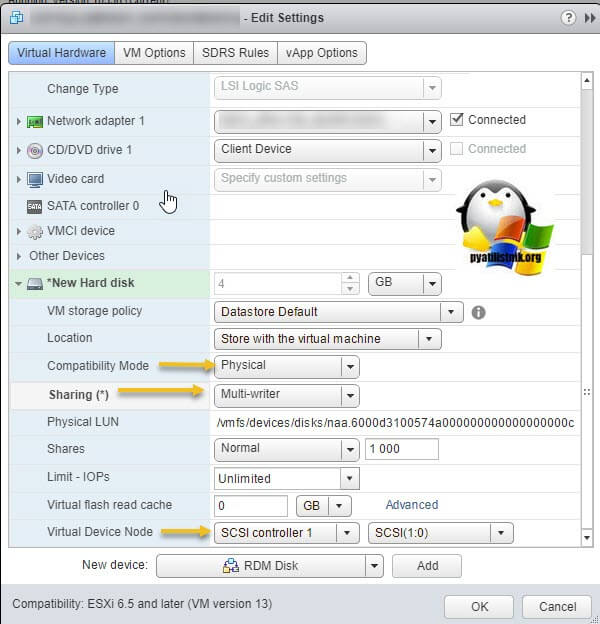

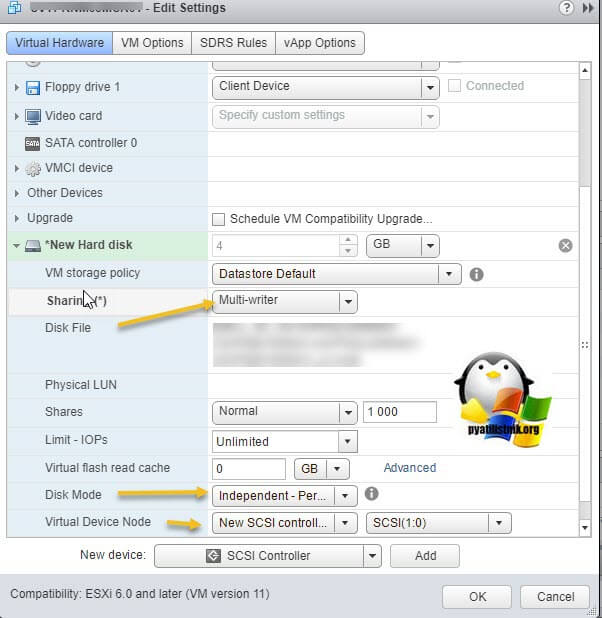

Откройте параметры нового виртуального диска. Для того, чтобы сделать его общим между виртуальными машинами VMware ESXI, вам необходимо выставить соответствующие настройки:

- Disk Provisioning — Делает толстый диск с занулением «Thick provision Eager zeroed thick disks», нужен для кластеризации, о типах дисков ESXI, читайте по ссылке.

- Sharing — тут вы как раз выбираете режим общего диска «Multi-Writer»

- Disk Mode — режим работы диска выставите «Independent Persistent» (Подробнее про режимы работы ESXI дисков), данный режим работы не позволит использовать vStorage APIs, что не даст создавать на таком диске снапшоты. Данный режим рекомендуется самим вендором VMware и его партнерами, такими как Oracle. Если бы мы разрешили создание снимков на этом диске, то это могло бы привести к потере данных. Так если у вас на этом диске быдет база SQL и вы будите использовать Veeam Backup, то у ваших резервных копий на уровне самого SQL могут быть проблемы при восстановлении из них, так как точка отсчета с которой нужно будет выстраивать цепочку бэкпов будет нарушена Veeam, который сдвинет точку бэкапа на себя. Если выставлен Independent Persistent, то в Veeam при создании бэкапа этой виртуальной машин можно исключить нужные диске, где стоят SQL или Oracle.

- Virtual Device Node — выберите наш новый LSI Logic SAS контроллер, работающий в режиме «SCSI Bus Sharing Virtual»

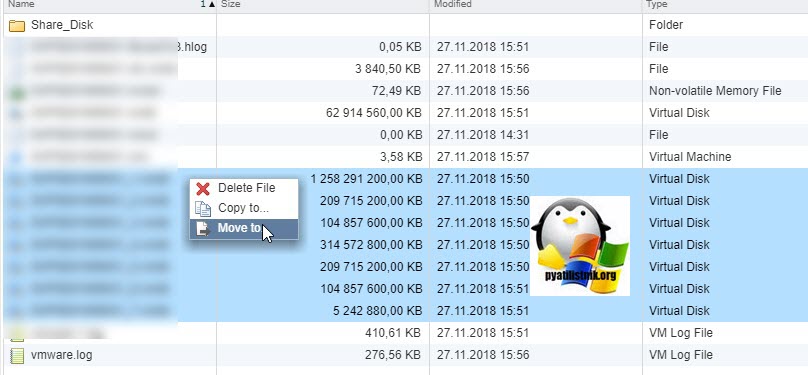

Далее я для своего удобства, хочу чтобы общие диски лежали в отдельной папке, а так как они по умолчанию создаются в папке с виртуальной машиной да и еще имеют имя дисков, как имя машины_цифра, я бы такое хотел поправить. Для этого я в конфигурации виртуальной машины удаляю все созданные диски, но я не ставлю галку «Delete files from datastore», то есть по сути на датасторе они остаются.

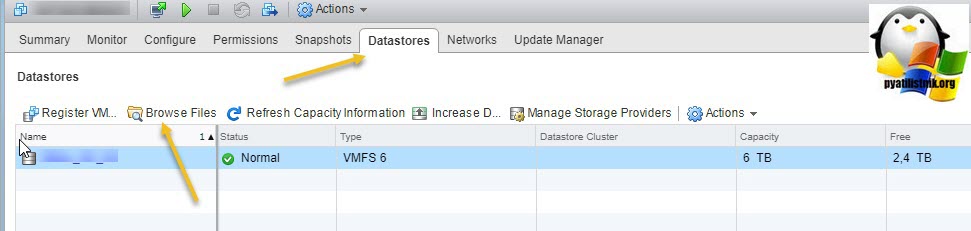

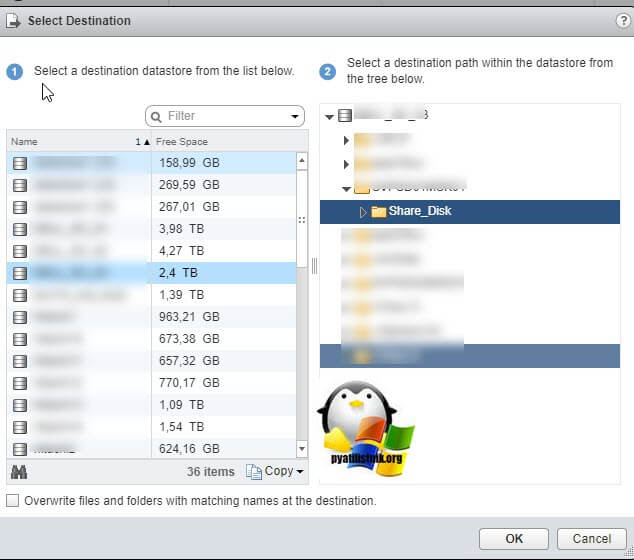

Далее я иду на датастор на котором находится виртуальная машина с общими дисками (Datastore — Browse Files).

Нахожу нужные мне Multi-Writer диски. Создаю новую папку

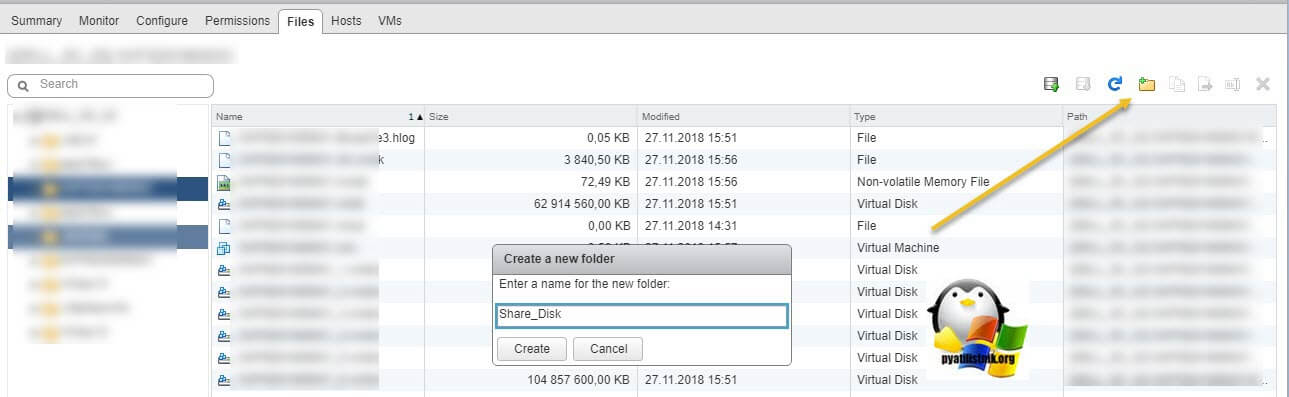

И перемещаю в новую папку общие диски, хочу отметить, что вы их можете переместить на любой общий между хостами ESXI датастор.

Я делаю «Move to» на тот же латасторе, но в новую папку. Этим я добьюсь, что буду видеть явным образом общие кластерные диски.

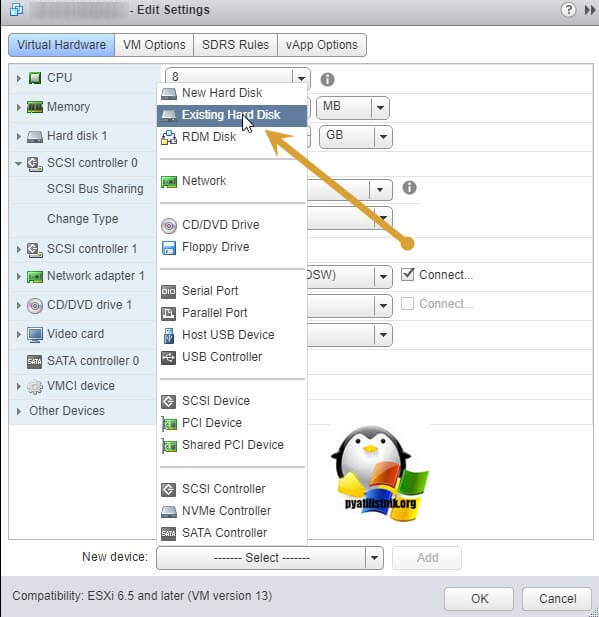

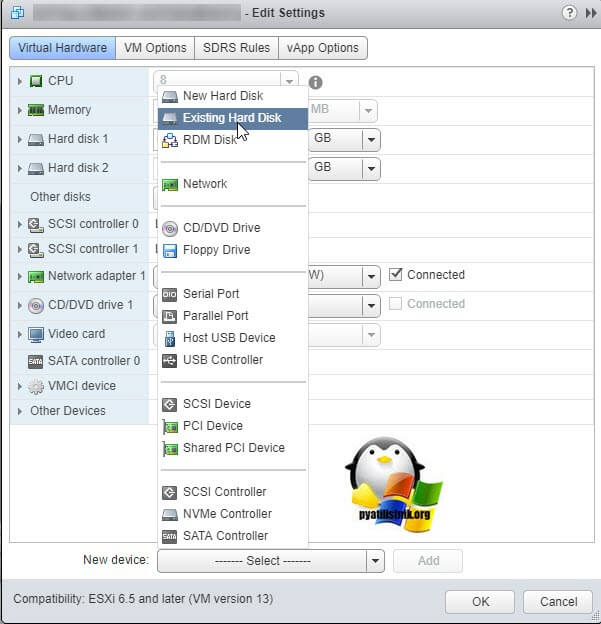

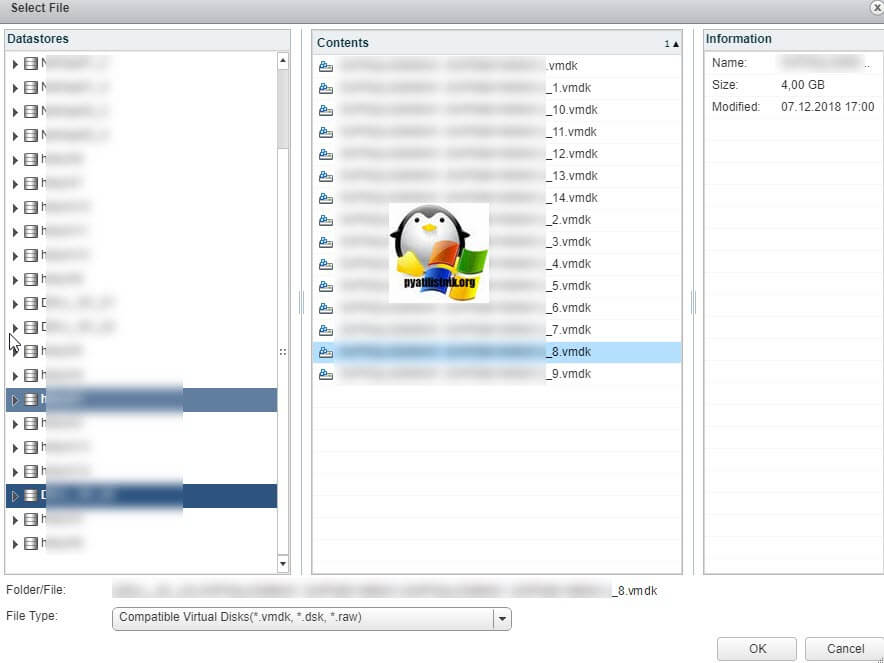

Так как я диски до этого удалил, для удобства, то мне их нужно заново добавить. Если вы до этого не удаляли, то сделайте эти действия только для второй виртуальной машины. Открываем настройки виртуальной машины и нажимаем добавить новое устройство, выбираем пункт «Existing Hard Disk», это у нас выбор существующего общего кластерного диска.

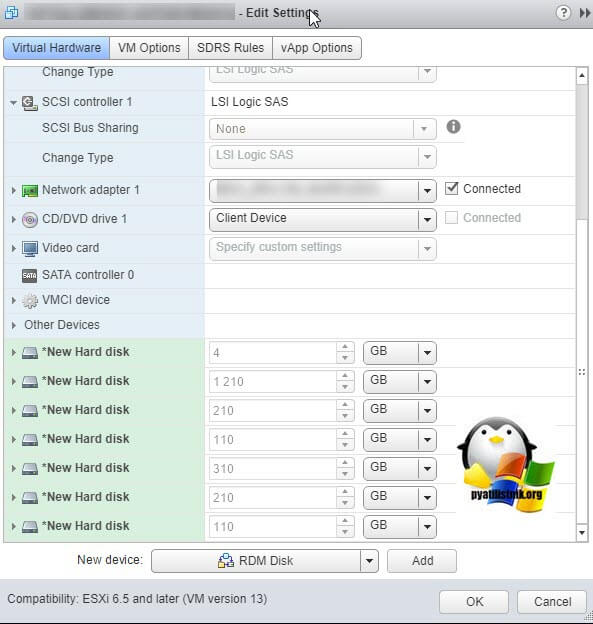

Указываем на каком датасторе у нас лежит Multi-Writer диск и выбираем нужный VMDK, в моем случае их семь.

Выставляем нужные параметры:

- Disk Provisioning — «Thick provision Eager zeroed thick disks»

- Sharing — «Multi-Writer»

- Disk Mode — «Independent Persistent»

- Virtual Device Node — выберите наш новый LSI Logic SAS контроллер, работающий в режиме «SCSI Bus Sharing Virtual»

Если такой диск не один, то добавляем все за один раз для экономии времени. Проделываем такое добавление общих дисков на всех виртуальных машинах, где планируется использовать Multi-Writer.

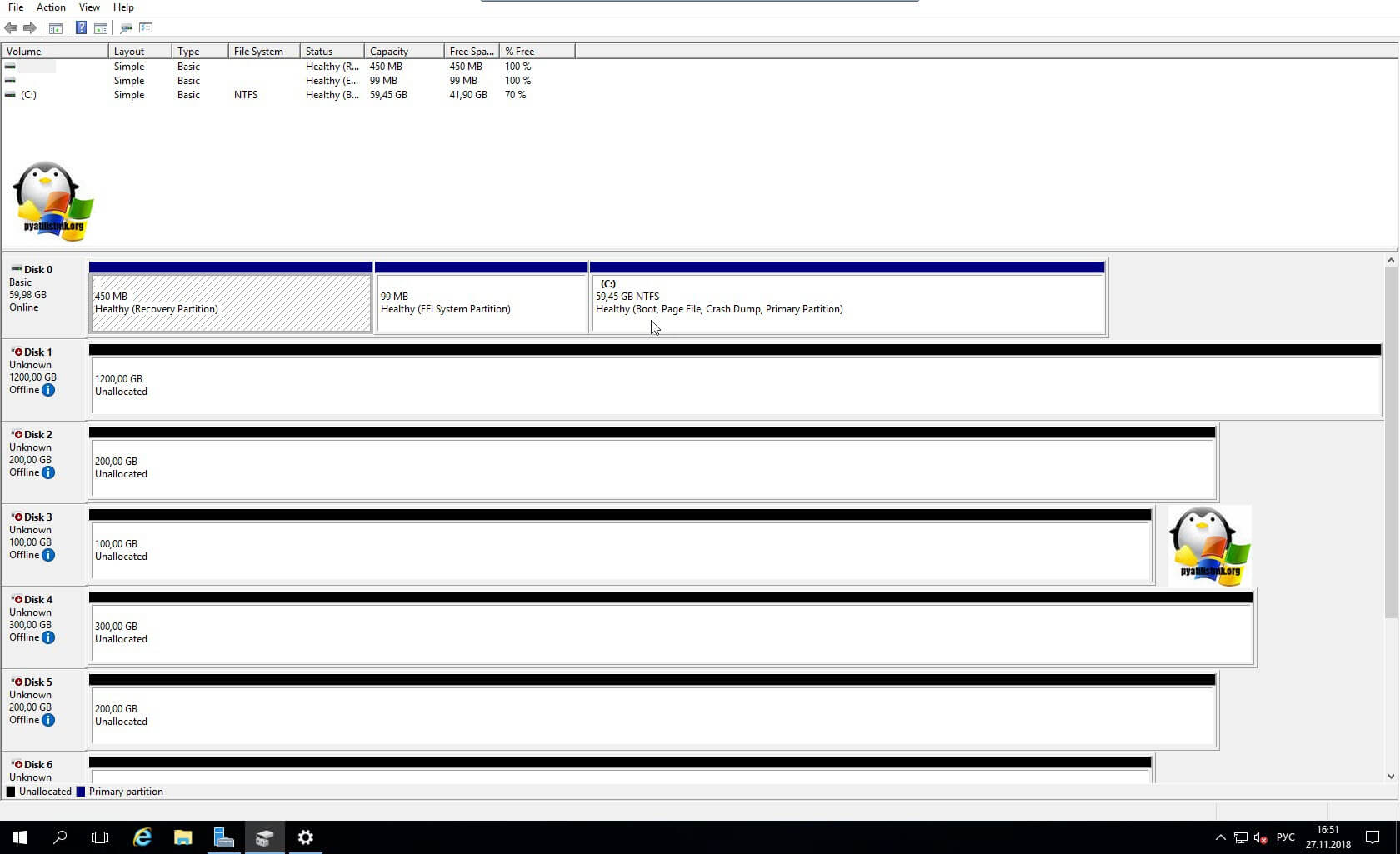

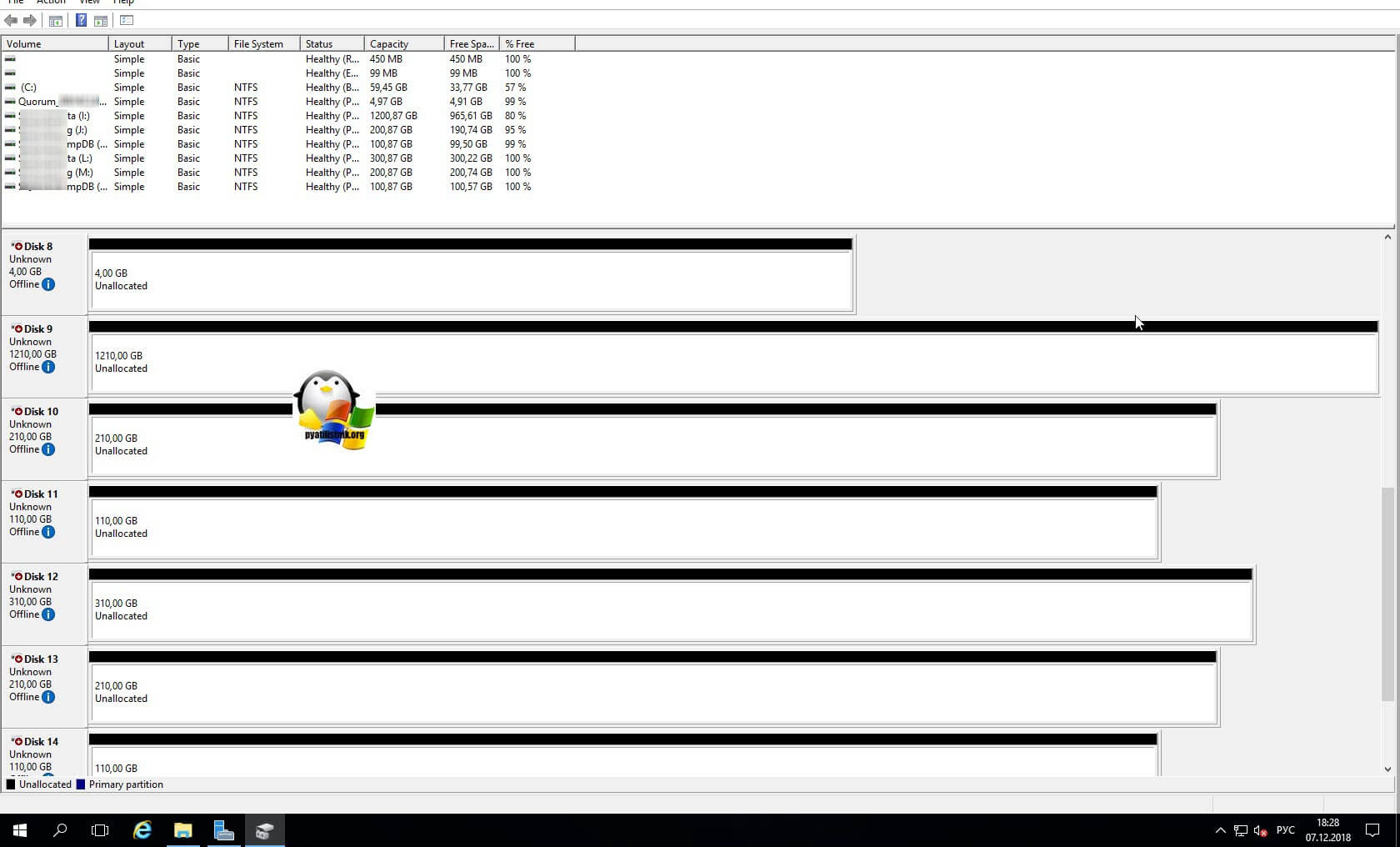

Далее уже в операционной системе Windows Server, зайдя в оснастку «Управление дисками» вы обнаружите ваши диски. Остается их только разметить в GPT формат и отдать под кластер.

Включение общего диска для ESXI 5.5 и ниже

В более ранних версиях гипервизора Vmware ESXI 5.5 и ниже, общий кластерный диск выключается таким образом. Вы заходите так же в свойства виртуальной машины и добавляете там новый SCSI Controller с типом работы «Virtual».

Затем вы создаете новый диск, указываете его размер и тип Thick Provision Eager Zeroed.

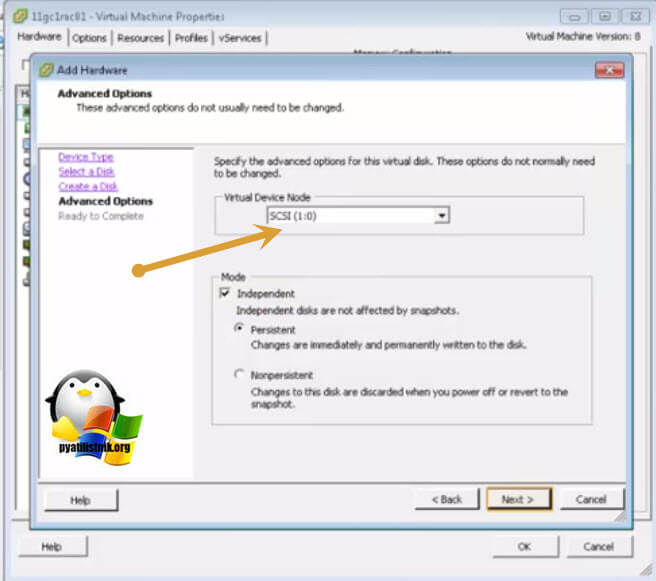

Далее Vmware ESXI 5.5 попросит вас выбрать Выбор LSI Logic SAS контроллер, обязательно укажите тот, что мы создали заранее и запомните порт SCSI к которому вы его подключаете в моем примере, это SCSI (1:0).

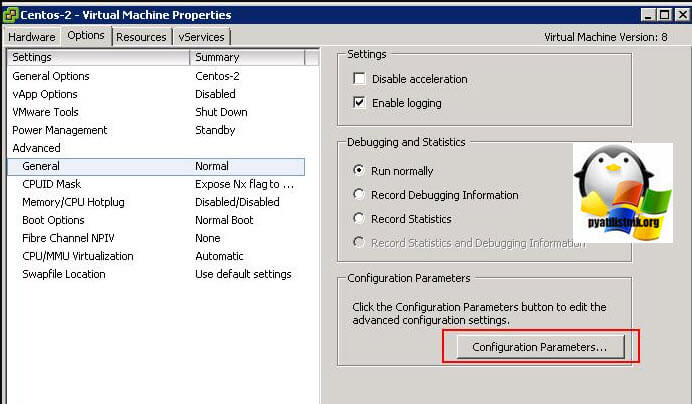

Далее в настройках виртуальной машины вам необходимо перейти на вкладку «Option — General» и нажать кнопку «Configuration Parameters».

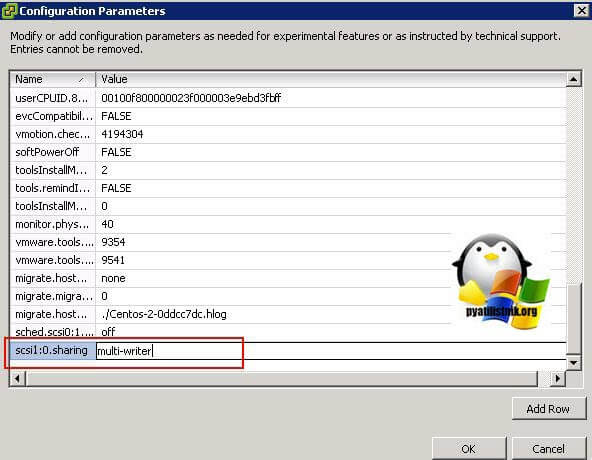

В самом конце для каждого общего диска пишем в имени номер SCSI порта SCSI1: 0.sharing в поле «Value» пишем multi-writer.

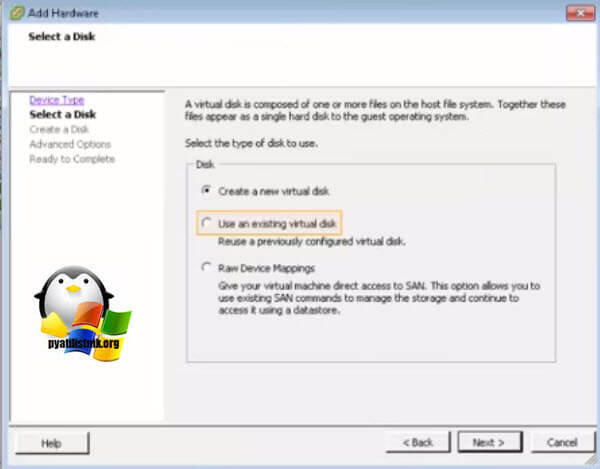

Для второй виртуальной машины делаем те же действия, единственное на этапе создания диска, выбираем пункт существующего «Use an existing virtual disk»

Через кнопку «Browse» указываем путь до него.

Выбираем сам VMDK диск. После чего не забываем так же прописать на вкладке «Option — General» и нажать кнопку «Configuration Parameters», для каждого общего диска пишем в имени номер SCSI порта SCSI1: 0.sharing в поле «Value» пишем multi-writer.

Vmware windows cluster disk

Доброго времени суток! Многоуважаемые читатели и гости, крупного IT блога Pyatilistnik.org. Я продолжаю цикл статей посвященный моему любимому гипервизору Vmware ESXI 6.5. В прошлый раз мы с вами начали изучать кластерные диски, и разобрали тему, где разобрали, что такое Multi-writer диск и как его применять в кластере Microsoft или Oracle. Сегодня я бы хотел поговорить, о еще одной реализации кластерных дисков под различные задачи, а именно о создании RDM дисков (Raw Device Mapping). Технология очень интересная и набирающая интерес у многих инженеров.

Что такое RDM диск (Raw Device Mappings)

Год назад, я вам уже вскользь рассказывал, о данной технологии, я вас учил подключать RDM диск в ESXI 5.5. Сегодня я постараюсь подробнейшим образом, прежде всего для себя, чтобы структурировать осознанную информация, рассказать, о назначении технологии, какие у нее есть ограничения и варианты внедрения.

Raw Device Mapping он же RDM — это способ обеспечения прямого доступа виртуальной машины к LUN (Logical Unit Number) в хранилище SAN (СХД). LUN, представленный виртуальной машине, может быть затем отформатирован в любой файловой системе, такой как NTFS или FAT для ОС Windows, и поэтому нет необходимости форматировать LUN с файловой системой VMFS, а затем размещать на ней vmdk.

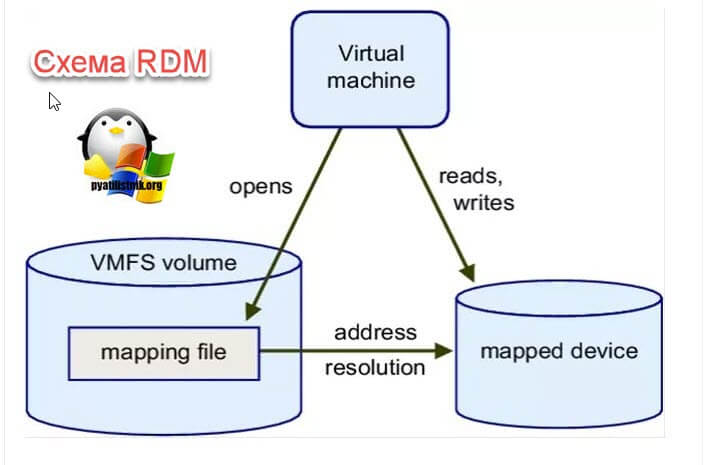

RDM можно рассматривать, как символическую ссылку из тома VMFS в Raw LUN (Мы с вами уже рассматривали применение символических ссылок, при переносе OST файла в Outlook). Когда RDM диск сопоставляется с виртуальной машиной, то создается файл сопоставления (Mapping File). Этот файл сопоставления выступает в качестве прокси для физического устройства и содержит метаданные, используемые для управления и перенаправления доступа к необработанному диску.

Когда виртуальная машина пытается получить доступ к Logical Unit Number, файл сопоставления считывается для получения ссылки на нужный LUN с системы хранения данных, а затем чтение и запись идут непосредственно к необработанному LUN, а не через файл сопоставления. Схематически данную реализацию можно представить вот так.

Где используются RDM диски

RDM предоставляет ряд преимуществ, но его нельзя использовать в любой ситуации.

- Raw Device Mappings диски, как видно из названия статьи, используют в кластерных решениях, например MSCS кластер, например между виртуальной машиной и физическим сервером или Oracle

- RDM диски можно использовать в некоторых продуктах резервного копирования, где софт требует именно локальные диски. Еще бывают ситуации, что наоборот с локальными дисками софт может не работать, и так например в Veeam Backup, можно такой вот проброшенный LUN замаскировать под ленточную библиотеку (VTL -Virtual tape library «https://en.wikipedia.org/wiki/Virtual_tape_library»)

- Когда есть необходимость в использовании iSCSI-устройства, чтобы ему можно было передать разные iSCSI-команды, например, чтобы управлять SAN-устройством из виртуальной машины, или делать снапшот на уровне системы хранения данных.

- Для достижения максимальной производительности, минуя накладные расходы гипервизора.

- Для настройки виртуальной машины для использования виртуализации идентификаторов N_Port (NPIV)

- Очень удобно без переустановки перенести все данные на таком LUN отформатированном, например, в файловой системе NTFS. Где виртуальная машина их сразу увидит, там можно избежать процесса виртуализирования P2V.

- Еще одним преимуществом можно выделить удобное имя для подключенного устройства. Когда вы используете RDM, вам не нужно ссылаться на устройство по имени устройства. Вы ссылаетесь на него по имени файла сопоставления, например: /vmfs/volumes/myVolume/myVMDirectory/myRawDisk.vmdk

- Есть динамическое разрешение имен — Хранит уникальную идентификационную информацию для каждого подключенного устройства. VMFS связывает каждый RDM с его текущим устройством SCSI, независимо от изменений физической конфигурации сервера, из-за изменений адаптера, изменений пути, перемещения устройства и т. д.

- Распределенная блокировка файлов — Позволяет использовать распределенную блокировку VMFS для необработанных SCSI-устройств. Распределенная блокировка на RDM делает безопасным использование общего необработанного LUN без потери данных, когда две виртуальные машины на разных серверах пытаются получить доступ к одному и тому же LUN.

- RDM должен сопоставляться с полным LUN; он не поддерживает частичные объекты хранения, такие как разделы диска. Кроме того, RDM работает не на всех устройствах. В качестве одного примера, RDM использует серийные номера устройств хранения для обеспечения правильной идентификации активов хранения, но некоторые устройства хранения — такие как некоторые блочные устройства хранения с прямым подключением и устройства RAID — не предоставляют серийный номер. Без серийного номера RDM недоступен для этих ресурсов хранения.

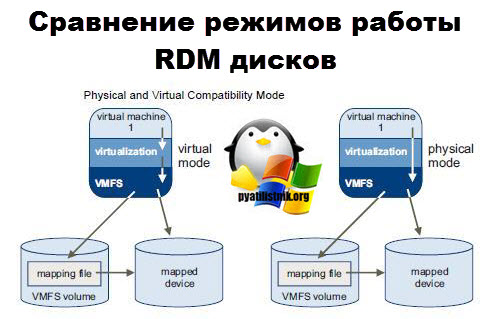

Режимы работы RDP дисков

Существует два варианта работы Raw Device Mappings дисков:

1. Физический (Physiacal)

2. Виртуальный (Virtual)

Перед тем, как я опишу вас оба режима работы RDM дисков, я напомню принцип работы VMFS томов с VMDK файлами виртуальных дисков. Если по простому, то VMDK диски, это наивысший уровень маршрутизации, там SCSI команды, которые генерирует виртуальная машина идут на компонент VMkernel. Далее VMkernel находит файл VMDK и смотрит его содержимое. Все, что находится во вне за пределами виртуальной машины, ей не доступно, это можно сравнить с изолированной Северной Кореей. По сути виртуалка получает некий кусок NFS или VMFS тома, предоставленной ей в виде VMDK файла, где все операции с ним строго контролирует гипервизор ESXI, в виду такой схемы мы имеем накладные расходы производительности.

Режим физической совместимости (RDM Physiacal Mode)

Данный режим еще называют Passthru RDM.

- Режим физической совместимости предлагает альтернативное сопоставление, которое обеспечивает прямой доступ к устройствам SCSI, что может быть полезно для приложений, которые в противном случае ожидают низкоуровневый доступ к диску.

- Физический режим определяет минимальную виртуализацию SCSI сопоставленного устройства, что обеспечивает наибольшую гибкость программного обеспечения для управления SAN. Хост передает все команды SCSI, за исключением команды REPORT LUNS, непосредственно на устройство хранения. Это может быть полезно при запуске программного обеспечения управления SAN внутри виртуальной машины, поскольку агентам управления SAN, как правило, требуется прямой доступ к устройству без перехвата команд SCSI хостом виртуализации. Примером приложения SAN, которому требуется RDM в физическом режиме, является пакет SnapManager NetApp.

- Снимки виртуальной машины недоступны, когда RDM используется в режиме физической совместимости.

- Виртуальные машин с дисками Raw Device Mappings вы не сможете клонировать

- До версии ESXI 6.0 включительно вы не могли в режиме Physiacal Mode производить Storage Vimotion, в версия ESXi 6.5 и выше она уже работает, хоть и со скрипом.

- Вы можете использовать этот режим для кластеризации между физическими серверами и виртуальными.

- VMFS5 поддерживает размер диска более 2 ТБ для RDM только в режиме физической совместимости. Эти ограничения применяются:

- Вы не можете переместить RDM размером более 2 ТБ в хранилища данных, отличные от VMFS5.

- Вы не можете преобразовать RDM размером более 2 ТБ в виртуальные диски или выполнять другие операции, связанные с преобразованием RDM в виртуальные диски. Такие операции включают в себя клонирование.

- Вы не сможете сделать шаблон виртуальной машины у которой есть RDM диски в режиме физической работы

Режим виртуальной совместимости (RDM Virtual Mode)

Режим виртуальной совместимости поддерживает подмножество команд SCSI, которые передаются через гипервизор для связи между гостевой ОС и отображенным RDM. В этом режиме VMkernel отправляет на подключенное устройство только READ и WRITE. Сопоставленное устройство отображается для гостевой операционной системы точно так же, как файл виртуального диска в томе VMFS. Хотя важно отметить, что если клонируется виртуальная машина с RDM в виртуальном режиме, содержимое RDM lun копируется в vmdk (так как сам необработанный lun не может быть клонирован хостом).

- Виртуальный режим определяет полную виртуализацию подключенного устройства.

- Реальные характеристики оборудования скрыты.

- Если вы используете сырой диск в виртуальном режиме, вы можете реализовать преимущества VMFS, такие как расширенная блокировка файлов для защиты данных и моментальные снимки для оптимизации процессов разработки.

- Виртуальный режим является более переносимым по отношению к аппаратным средствам хранения, чем физический режим, демонстрируя то же поведение, что и файл виртуального диска.

- Есть нюансы при расширении RDM диска в режиме виртуальной совместимости.

- В случае создания такого диска на хранилище VMFS (NFS — не поддерживается) создается mapping-файл (он тоже с расширением *-rdmp.vmdk), через который происходит маппирование виртуальной машине физического дискового устройства LUN. Устройство это маппируется особым образом — основные служебные операции по работе с ним (например, команда Open и другие служебные SCSI-команды) проходят через через слой виртуализации в гипервизоре, а команды по работе с данными (Read и Write) процессятся напрямую к устройству, минуя слой виртуализации. Под командами Read / Write в Raw Device Mappings подразумевается, что виртуалка будет его видеть, как обычный SCSI-диск. А так как, это обычный SCSI-диск, то с ним можно работать только, как с устройством хранения.

Кластеризация гостевых ОС

Распространенным вариантом использования RDM является кластеризация гостевых ОС (например, Microsoft Cluster Services) и кластеризация физического и виртуального. Существует несколько разных способов создания кластера с использованием виртуальных машин, с различными требованиями к использованию RDM.

CIB — Cluster In a Box — чаще всего используется для сценариев тестирования и разработки. Здесь у вас есть две виртуальные машины, работающие на одном хосте, настроенные как кластер. При использовании кластеризации Microsoft рекомендуется использовать RDM в режиме виртуальной совместимости.

CAB — Cluster Across Boxs — Когда виртуальные машины, составляющие кластер, находятся на разных хостах, тогда будет работать любой режим RDM, хотя рекомендуется использовать режим виртуальной совместимости.

Физически-виртуальный кластер — здесь необходимо использовать физический режим совместимости для RDM.

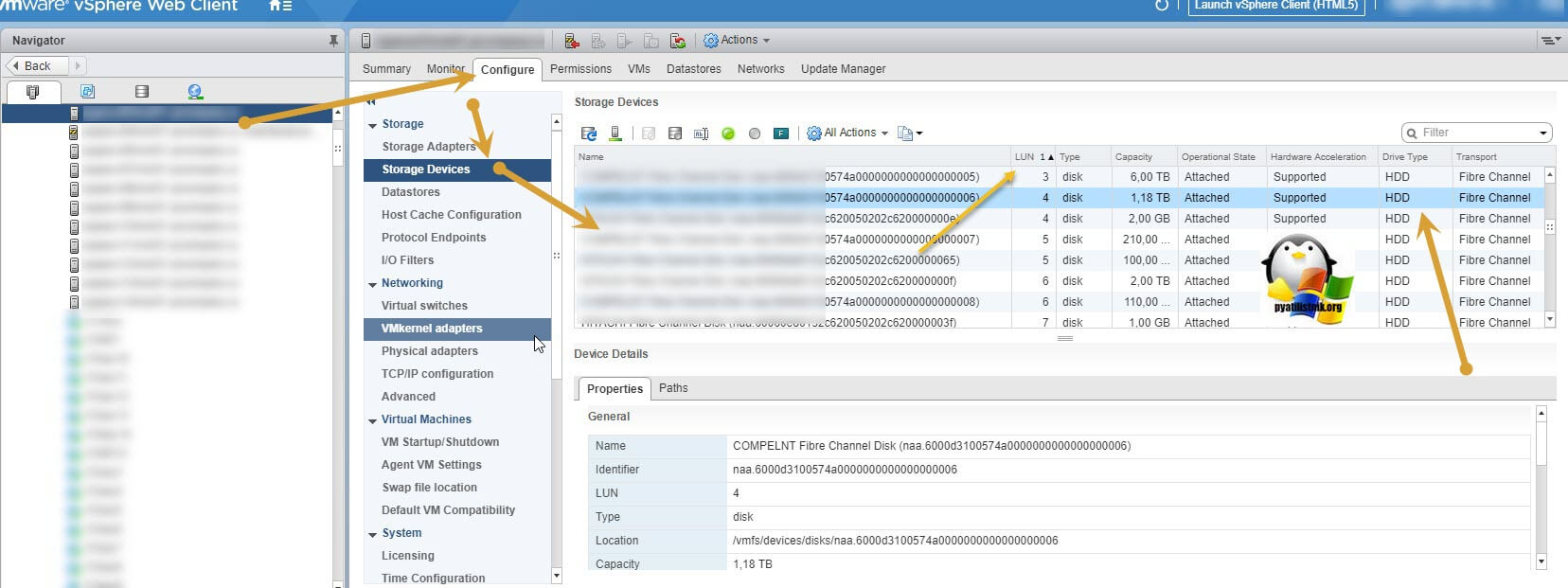

Как создать кластерный RDM диск в VMware ESXI 6.5

И так, предположим, что у меня есть две виртуальные машины, на борту которых установлена операционная система Windows Server 2016. Обе виртуальные машины расположены в рамках кластера ESXI, но естественно на разных хостах, предполагается, что к ним еще в будущем можно будет подключить дополнительный физический сервер на другой площадке. Исходя из этого мы создадим с вами Raw Device Mappings диски в режиме физической совместимости и отдадим их для постройки кластера MSCS или SQL AlwaysOn.

Перед тем, как мы с вами создадим RDM диски для наших виртуальных машин, нам нужно удостовериться, что все физические ESXI 6.5 хосты, видят LUN-ы и нужного размера. Для того, чтобы это проверить выберите нужны ESXI хост, перейдите в раздел «Configure — Storage Devices» и сопоставьте номера LUN представленные тут и на вашей системе хранения данных. Обратите внимание, что если у вас лун, который вы отдали с СХД, физически расположен на SSD, а в колонке «Drive Type» вы видите HDD вместо SSD, то я бы вам посоветовал прочитать заметку (Почему ESXI видит SSD как HDD)

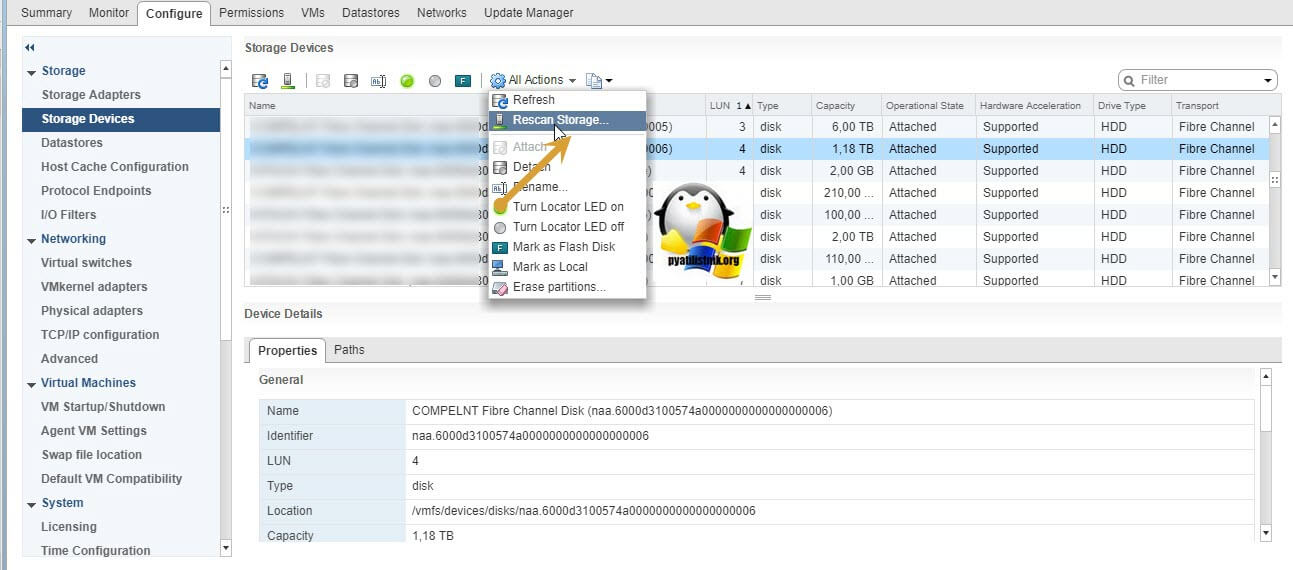

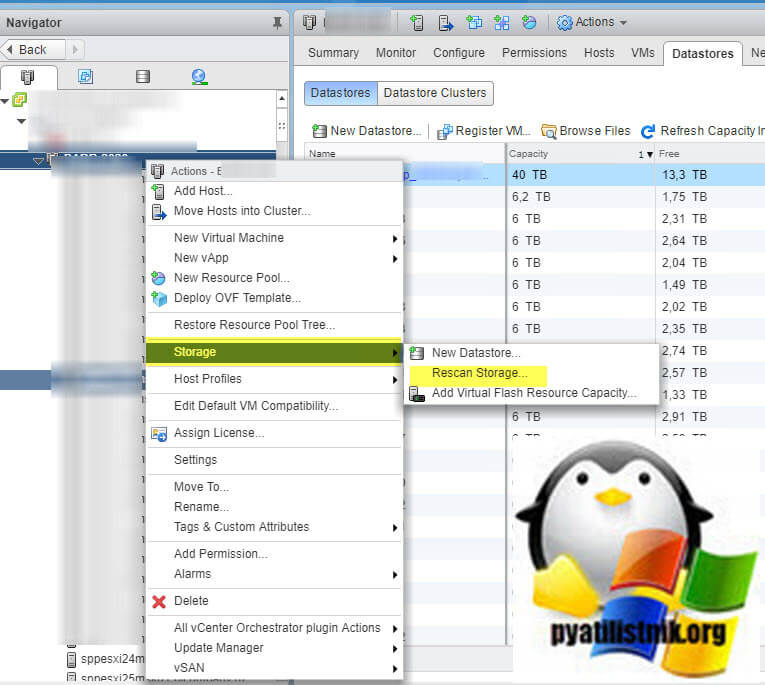

Если есть разногласия, то вам необходимо произвести повторное сканирование ваших подключённых устройств хранения (Storage Devices). Для этого выберите пункт «All Actions — Rescan Storage». Это может занять некоторое время, обязательно дождитесь окончания задания.

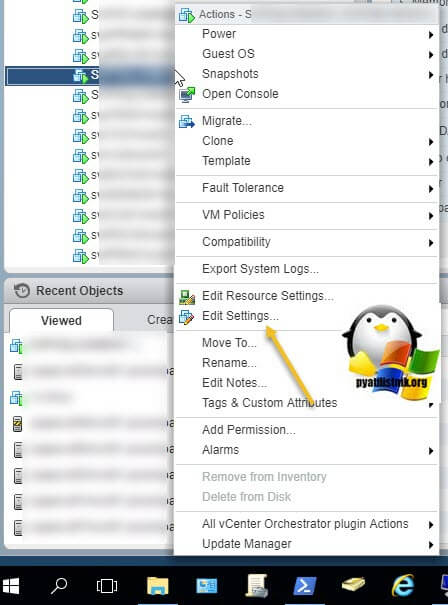

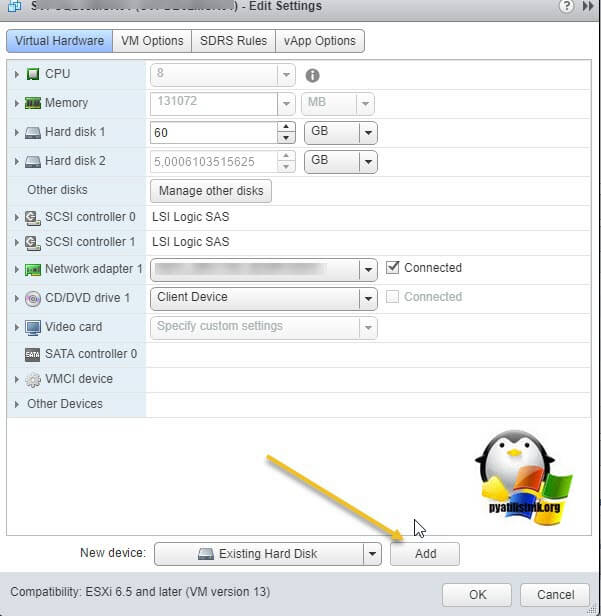

После того, как все LUN подключены, мы переходим с вами к редактированию настроек первой виртуальной машины. Для этого щелкните по ней правый кнопкой мыши и выберите пункт «Edit Settings».

Первым делом вы должны проверить, что у вас есть SCSI контроллер, который работает в режиме «None». Если его нет, то его нужно создать, делается это через пункт «New Device», где вы выбираете SCSI Controller.

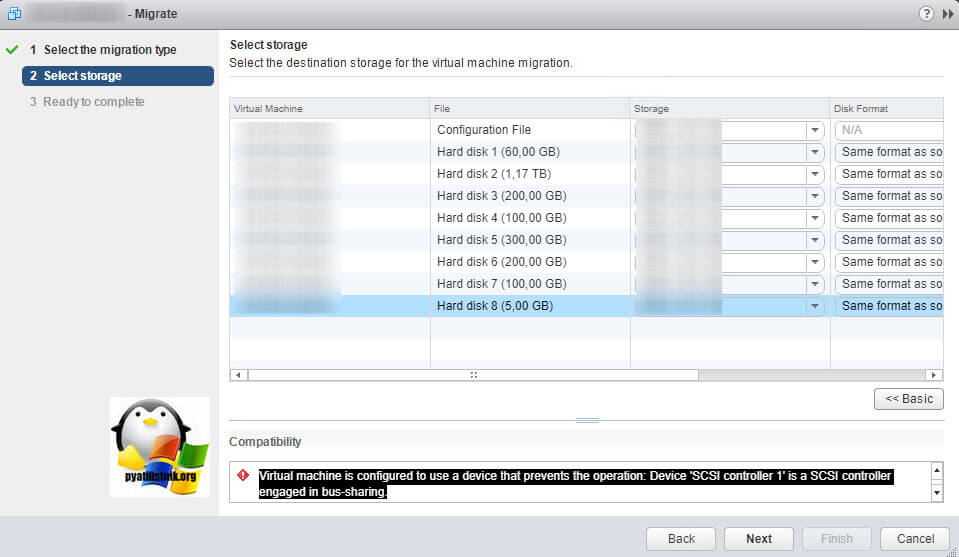

Почему именно должен быть режим «Note», если вы активируете «Виртуальный или физический», то у вас не будет возможности производить миграцию на уровне датасторов (Storage Vimotion), вы будите получать ошибку:

The disk extend operation failed: The virtual disk requires a feature not supported by this program. Hot-extend is currently supported only for VMFS flat virtual disks without snapshots opened in persistent mode.

Режимы работы SCSI Controller нужны для режима Multi-writer дисков. Еще одним ограничением SCSI контроллера, может выступать, что к нему можно подключить до 16 дисков, так что если у вас их больше вам придется добавить еще один.

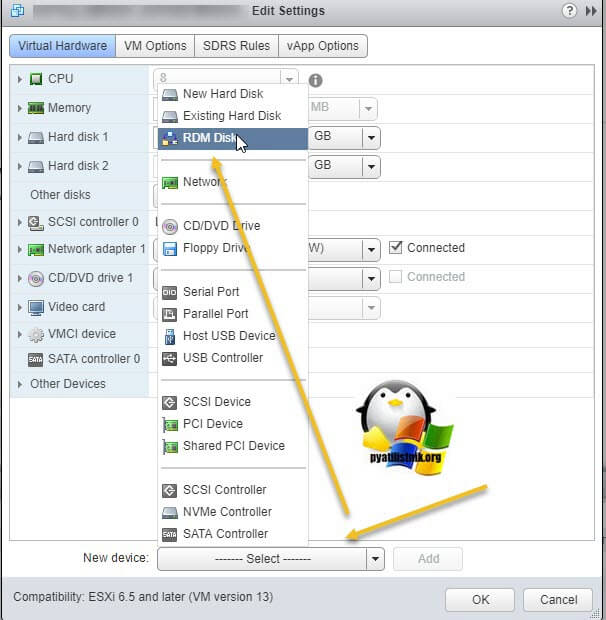

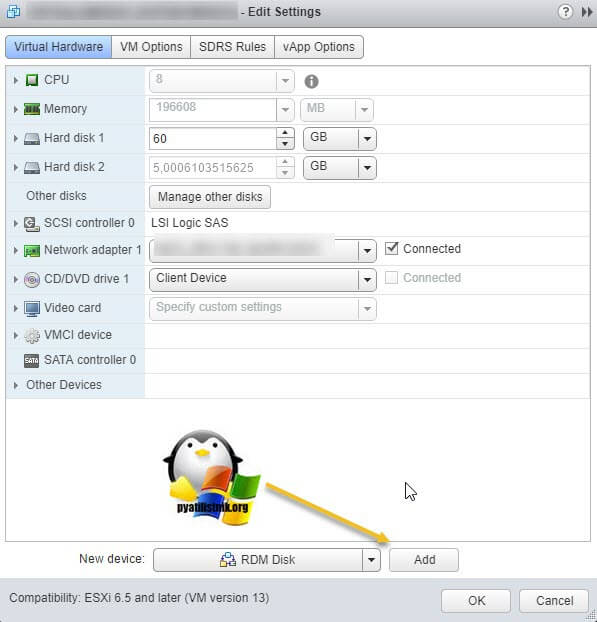

Далее вы таким же образом добавляете RDM Disk

Не забываем нажать кнопку «Add».

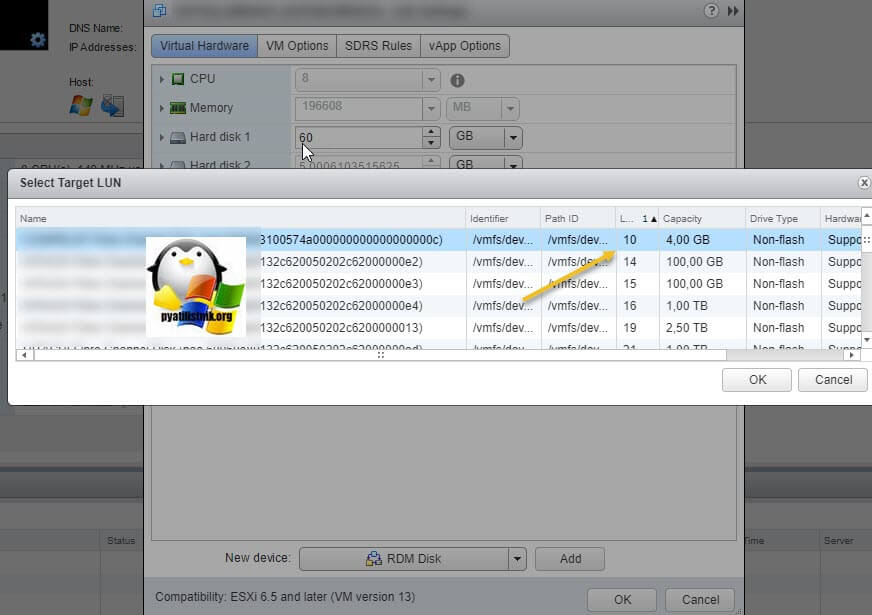

У вас появится окно «Select Target LUN», где вам необходимо выбрать нужный вам лун, тут можно их определить по имени, номеру и размеру. Тут будут представлены, только те, что не размечены на VMware ESXI.

Вот пример добавления RDM диска под кворум в кластере Microsoft. Обязательно выставите такие параметры:

- Compatibility Mode (Режим совместимости) — я выставил Pyasical, так как планирую сюда еще подключить и физический хост, и чтобы было меньше проблем при расширении диска.

- Sharing — я выставил режим Multi-writer, так как диск общий

- Virtual Device Node — выставил контроллер в режиме None, чтобы иметь возможность делать миграцию на уровне хранилища.

После чего я нажимаю кнопку добавить «Add».

Точно так же поступаем и с остальными кластерными дисками RDM.

Теперь переходим к настройкам второй виртуальной машины, которая будет участником кластера Microsoft. При необходимости добавьте ей SCSI контроллер в режиме работы None. Теперь через добавление нового оборудования выберите «Existing Hard Disk» (Существующий жесткий диск)

Не забываем нажать кнопку Add.

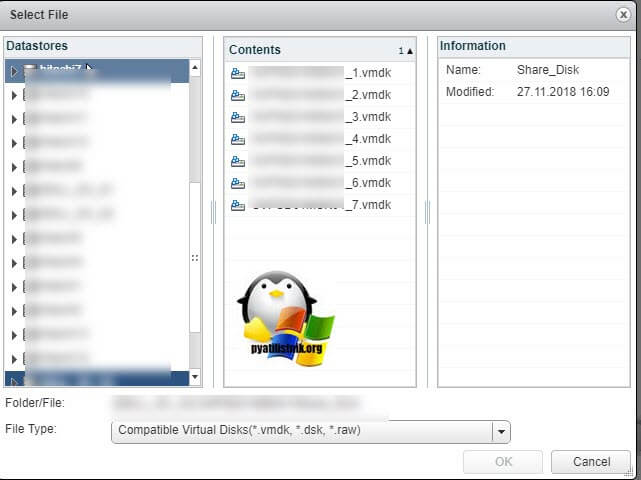

У вас откроется окно «Select File», где вам необходимо найти на ваших датасторах, папку с первой виртуальной машиной, в которой будут созданы RDM диски (Точки монтирования), выбрав которые вы подключите этот существующий кластерный диск.

Не забываем выставить пункты:

- Sharing — Multi-writer

- Disk mode — Independent-Persistent (Читать подробнее про типы дисков в ESXI)

В операционной системе Windows Server 2016, наши Raw Device Mappings диски, будут все доступны в оснастке «Управление дисками»

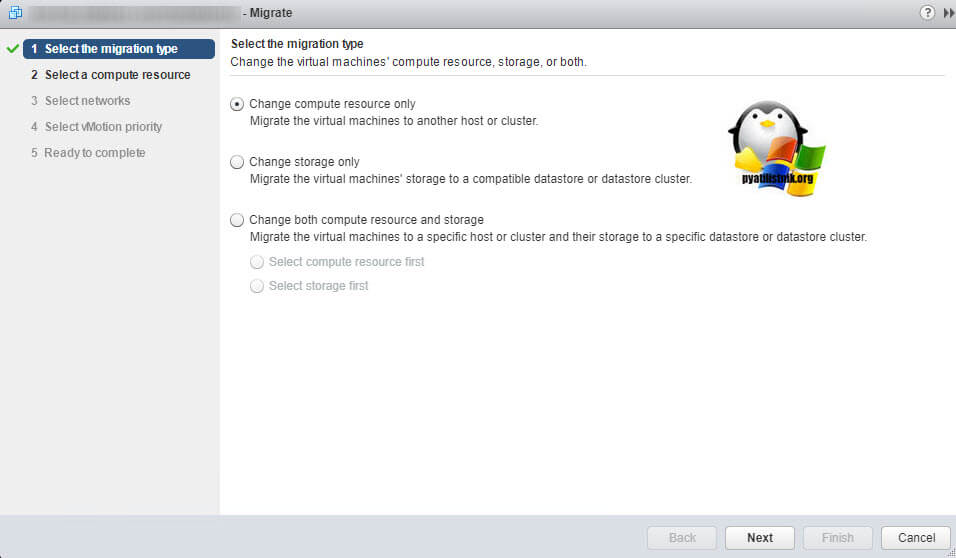

Нюансы Vmotion и Storage Vimotion

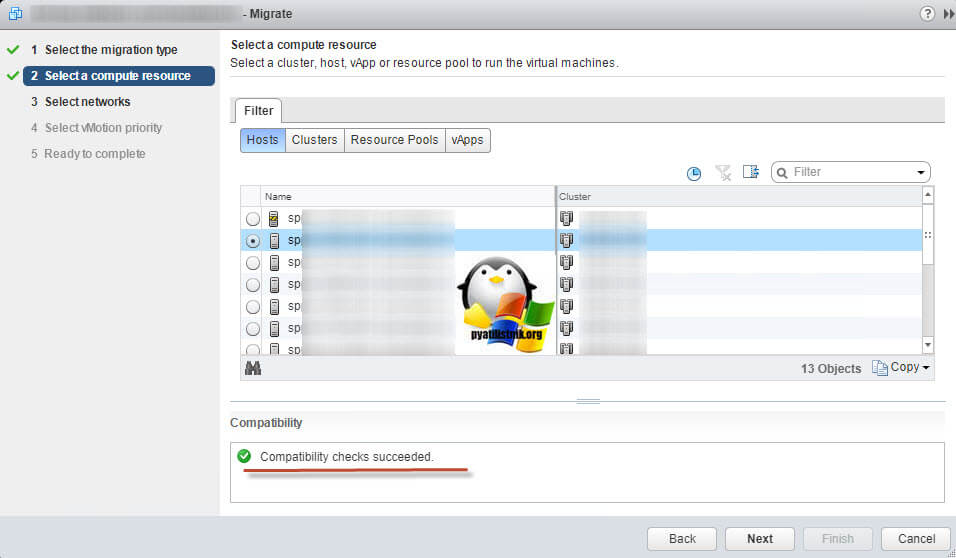

Так как я вам сказал, что у меня кластер ESXI 6.5, то все физические хосты у меня одинаковые, поэтому операция миграции виртуальной машины у меня выполняется без простоев. Напоминаю, этот тип миграции называется «Change compute resource only»

И удостоверьтесь, что в совместимости (Compatibility) у вас статус «Compatibility checks succeeded»

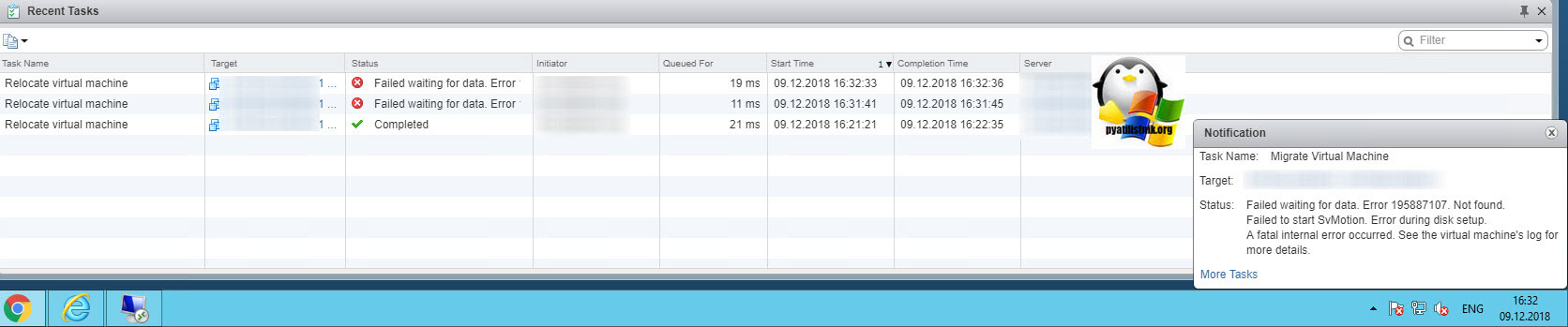

Вот отработавшее задание vMotion.

- Файлы виртуальной машины не перемещаются при переносе с использованием vMotion.

- Виртуальная машина перерегистрируется на хосте назначения.

- Любые RDM остаются в качестве RDM, когда виртуальная машина зарегистрирована на другом хосте. То есть никаких изменений в самой виртуальной машине не производится.

Теперь в случае со Storage Vmotion, если вы попытаетесь на живую перетащить вашу виртуальную машину с RDM дисками, то вы получите вот такую ошибку:

В данном случае у вас два варианта решения проблемы, это выключить виртуальную машину, так как у меня кластер, то от этого проблем не будет. После чего выполнить холодную миграцию. Второй вариант, это передать управление дисками второй виртуальной машине, потом удалить их на первой, после чего мигрировать, а затем их подключить заново. По мне так первый вариант проще.

При холодной миграции:

- Любые виртуальные диски без RDM физически перемещаются в место назначения.

- Файлы конфигурации виртуальной машины физически перемещаются в место назначения.

- Сами необработанные LUN нельзя перемещать, поскольку они представляют собой необработанные диски, представленные из SAN. Однако файлы указателей (RDM) могут быть перемещены при необходимости.

- При выполнении холодной миграции виртуальной машины с подключенными к ней RDM, содержимое необработанного LUN, сопоставленного с RDM, копируется в новый .vmdk файл в месте назначения, эффективно преобразуя или клонируя необработанный LUN в виртуальный диск. Это также относится к случаям, когда виртуальная машина не перемещается между хостами ESXI. В этом процессе ваш исходный необработанный LUN остается нетронутым. Однако виртуальная машина больше не читает и не пишет в нее. Вместо этого используется только что созданный виртуальный диск.

- Если вы хотите выполнить холодную миграцию виртуальной машины без клонирования или преобразования ее RDM, удалите их из конфигурации виртуальной машины перед миграцией. Вы можете удалить RDM с диска при его удалении (необработанное содержимое LUN не изменяется). Повторно добавьте их в конфигурацию после завершения.

- Для ESXi 5.x и более поздних версий: во время миграции вы можете использовать раздел Advanced мастера миграции и выбрать, хотите ли вы сохранить тот же формат файлов в месте назначения или преобразовать его в толстый / тонкий диск.

- Регистрация виртуальной машины меняется, но файлы остаются нетронутыми.

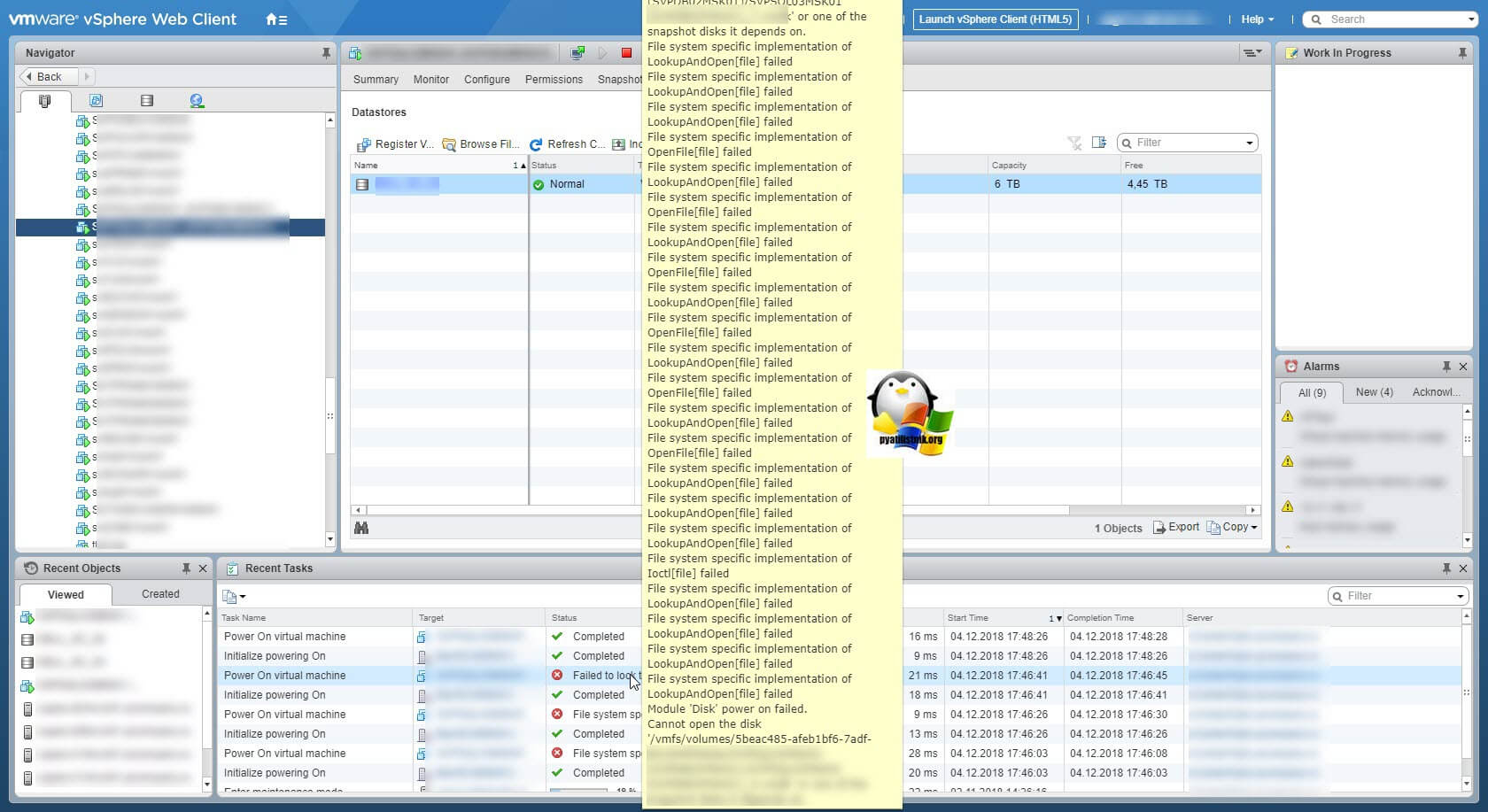

В момент включения, я потом получил на первой попытке вот такую ошибку:

Но через минуту она на второй раз завелась и все диски были нормально видны.

- При выполнении Storage vMotion файлы виртуальной машины физически перемещаются в хранилище данных назначения. Один и тот же хост сохраняет владение или регистрацию виртуальной машины после завершения Storage vMotion.

- Виртуальные диски и файлы указателей RDM виртуального режима можно переместить в хранилище данных назначения.

- Виртуальные диски могут быть преобразованы в диски с толстым или тонким предоставлением во время миграции, если место назначения не является хранилищем данных NFS.

- Файлы указателей RDM в физическом режиме можно переместить в хранилище данных назначения, но данные RDM в физическом режиме не могут быть перенесены на диск VMDK с помощью Storage vMotion, перенесутся только точки монтирования.

- В ESXi 5.x и более поздних версиях во время операции Storage vMotion данные RDM виртуального режима можно переносить на новые диски VMDK, выбрав либо толстую, либо тонкую настройку для типа диска в разделе «Дополнительно» мастера миграции.

- При переносе файлов указателя RDM в физическом режиме объемом более 2 ТБ с использованием Storage vMotion необходимо использовать веб-клиент vSphere.

- Данные RDM в физическом режиме могут быть перенесены на диски VMDK только посредством холодной миграции.

- Если вы не измените формат назначения на толстый или тонкий для RDM в расширенном разделе мастера миграции, только целевой файл RDM будет перенесен в целевое хранилище данных.

- При использовании виртуализации N-Port ID (NPIV) Storage vMotion не поддерживается.

- Если вы пытаетесь использовать Storage vMotion RDM виртуального режима с использованием расширенного метода, и файл сопоставления указателей RDM уже присутствует в целевом хранилище данных, Storage vMotion завершает работу быстро, но без перемещения данных. Это связано с тем, что Storage vMotion обнаруживает, что исходные и целевые хранилища данных для файла сопоставления совпадают, и поэтому приходит к выводу, что никакого перемещения не требуется.

Нюансы расширения RDM дисков

Теперь давайте поговорим, о том, как вы можете расширять RDM диски. Тут все будет зависеть от режима работы

- Physical compatibility mode — Не требует перезагрузки

- Virtual compatibility mode — Требует перезагрузки

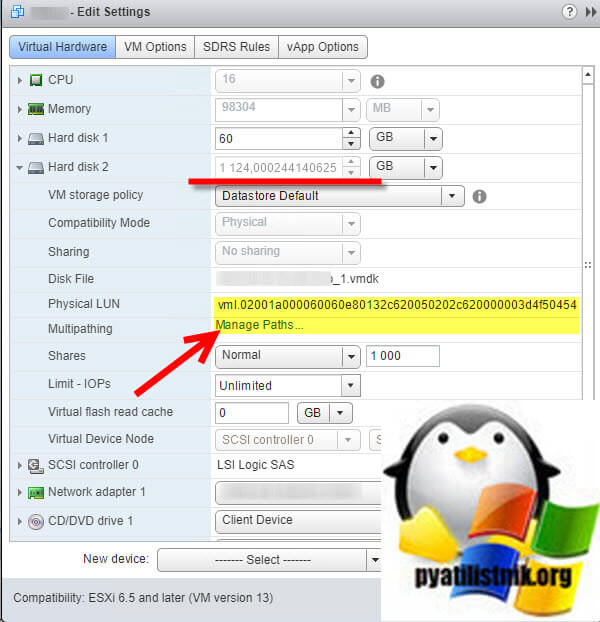

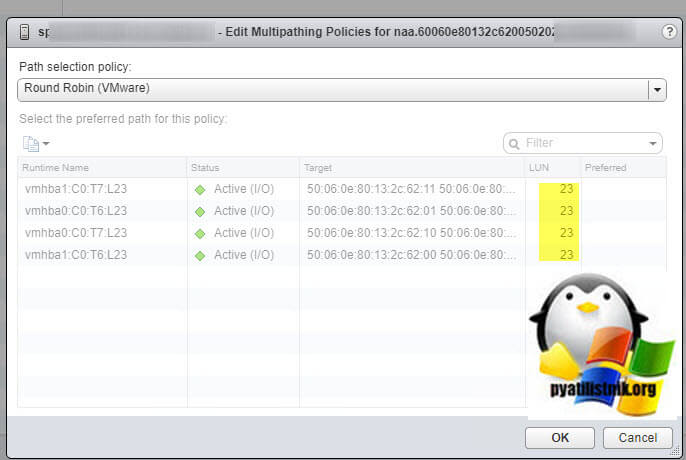

Расширение диска в режиме Physical compatibility mode. Откройте свойства виртуальной машины, выберите ваш RDM диск и разверните его дополнительные настройки. Найдите раздел «Physical LUN», под которым будет ссылка «Manage Paths«. Нажмите на нее.

Находим номер LUN. Он нам пригодится для поиска его на СХД, с которой презентуется LUN. Далее вы переходите на СХД, находите там LUN и расширяете его на нужный вам размер.

Далее вам необходимо произвести пересканирование ваших хранилищ (Storage — Reascan Storage).

Далее остается дождаться обновления информации, о размерах ваших хранилищ. После чего вы открываете уже внутри виртуальной машины оснастку по управлению дисками и производите его увеличение.

Если же мы говорим про режим Virtual compatibility mode, то тут вам придется полностью выключить виртуальную машину. Так же найти номер LUN вашего виртуального диска. После чего в свойствах виртуальной машины, вам необходимо удалить ваш RDM диск, НО ТОЛЬКО из настроек самой виртуальной машины (from the virtual machine). Далее в интерфейсе про управлению СХД, вы производите увеличение нужного LUN. Делаете rescan ваших хранилищ, после чего вы добавляете существующий RDM диск в нужной виртуальной машине (VM Settings > Add > Hard Disk > RDM >). Включаете ее и производите расширение раздела внутри гостевой операционной системы. По идее это все.