- Установка и включение дедупликации данных Install and enable Data Deduplication

- Установка дедупликации данных Install Data Deduplication

- Установка дедупликации данных с помощью диспетчера сервера Install Data Deduplication by using Server Manager

- Установка дедупликации данных с помощью PowerShell Install Data Deduplication by using PowerShell

- Включение дедупликации данных Enable Data Deduplication

- Определение рабочих нагрузок для дедупликации Determine which workloads are candidates for Data Deduplication

- Оценка дедупликации данных для рабочих нагрузок Evaluate workloads for Data Deduplication

- Включение дедупликации данных Enable Data Deduplication

- Включение дедупликации данных с помощью диспетчера сервера Enable Data Deduplication by using Server Manager

- Включение дедупликации данных с помощью PowerShell Enable Data Deduplication by using PowerShell

- Дополнительные рекомендации Other considerations

- Часто задаваемые вопросы Frequently asked questions (FAQ)

Установка и включение дедупликации данных Install and enable Data Deduplication

Область применения: Windows Server (Semi-Annual Channel), Windows Server 2016 Applies to Windows Server (Semi-Annual Channel), Windows Server 2016

В этой статье описано, как установить дедупликацию данных, оценить рабочие нагрузки для дедупликации, а также включить дедупликацию данных для отдельных томов. This topic explains how to install Data Deduplication, evaluate workloads for deduplication, and enable Data Deduplication on specific volumes.

Если вы планируете использовать дедупликацию данных в отказоустойчивом кластере, на каждом узле кластера должна быть установлена роль сервера дедупликации данных. If you’re planning to run Data Deduplication in a Failover Cluster, every node in the cluster must have the Data Deduplication server role installed.

Установка дедупликации данных Install Data Deduplication

Обновление KB4025334 содержит накопительный пакет исправлений, в том числе обеспечивающих надежность системы. Мы настоятельно рекомендуем установить его при использовании дедупликации данных в Windows Server 2016. KB4025334 contains a roll up of fixes for Data Deduplication, including important reliability fixes, and we strongly recommend installing it when using Data Deduplication with Windows Server 2016.

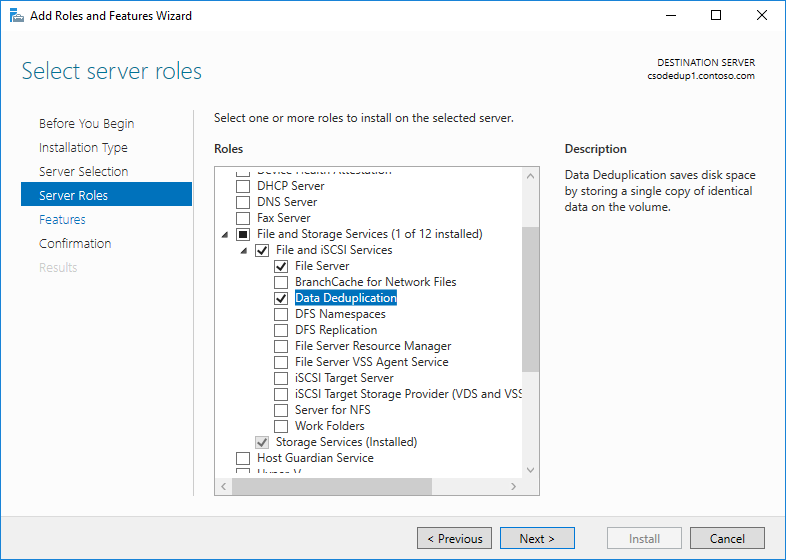

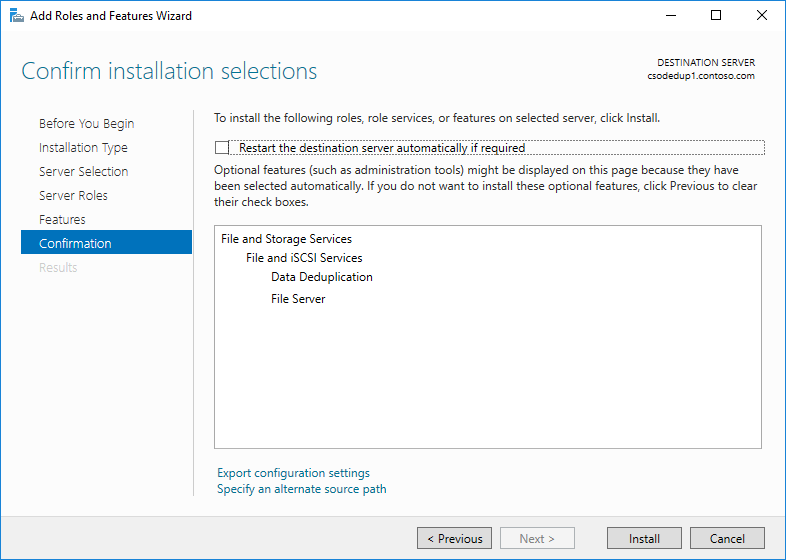

Установка дедупликации данных с помощью диспетчера сервера Install Data Deduplication by using Server Manager

- В мастере добавления ролей и компонентов выберите Роли сервера, а затем Дедупликация данных. In the Add Roles and Feature wizard, select Server Roles, and then select Data Deduplication.

- Нажимайте кнопку Далее, пока не будет активирована кнопка Установить, а затем щелкните Установить. Click Next until the Install button is active, and then click Install.

Установка дедупликации данных с помощью PowerShell Install Data Deduplication by using PowerShell

Чтобы установить дедупликацию данных, выполните следующую команду PowerShell от имени администратора: Install-WindowsFeature -Name FS-Data-Deduplication To install Data Deduplication, run the following PowerShell command as an administrator: Install-WindowsFeature -Name FS-Data-Deduplication

Чтобы установить дедупликацию данных на Nano Server: To install Data Deduplication in a Nano Server installation:

- Создайте установку Nano Server с установленным хранилищем, как описано в руководстве Приступая к работе с сервером Nano Server. Create a Nano Server installation with the Storage installed as described in Getting Started with Nano Server.

- На сервере под управлением Windows Server 2016 в любом режиме, отличном от Nano Server, или на персональном компьютере Windows с установленным пакетом средств удаленного администрирования сервера (RSAT) установите дедупликацию данных с явной ссылкой на экземпляр Nano Server (замените текст «MyNanoServer» реальным именем экземпляра Nano Server): From a server running Windows Server 2016 in any mode other than Nano Server, or from a Windows PC with the Remote Server Administration Tools (RSAT) installed, install Data Deduplication with an explicit reference to the Nano Server instance (replace ‘MyNanoServer’ with the real name of the Nano Server instance):

—ИЛИ—— OR —

Подключитесь к экземпляру Nano Server через систему удаленного взаимодействия PowerShell и установите дедупликацию данных с помощью DISM: Connect remotely to the Nano Server instance with PowerShell remoting and install Data Deduplication by using DISM:

Включение дедупликации данных Enable Data Deduplication

Определение рабочих нагрузок для дедупликации Determine which workloads are candidates for Data Deduplication

Дедупликация данных может очень эффективно снизить затраты, связанные с потреблением данных серверного приложения, уменьшая объем, занимаемый избыточными данными на дисках. Data Deduplication can effectively minimize the costs of a server application’s data consumption by reducing the amount of disk space consumed by redundant data. Прежде чем включать дедупликацию, очень важно определить характеристики рабочей нагрузки. Это позволит добиться максимальной производительности хранилища. Before enabling deduplication, it is important that you understand the characteristics of your workload to ensure that you get the maximum performance out of your storage. Существует два класса рабочих нагрузок, для которых стоит применять дедупликацию. There are two classes of workloads to consider:

- Рекомендуемые рабочие нагрузки — используют наборы данных, для которых дедупликация крайне эффективна. Такие нагрузки также используют схемы потребления ресурсов, которые совместимы с моделью постобработки, применяемой при дедупликации данных. Recommended workloads that have been proven to have both datasets that benefit highly from deduplication and have resource consumption patterns that are compatible with Data Deduplication’s post-processing model. Для следующих рабочих нагрузок включать дедупликацию данных рекомендуется всегда: We recommend that you always enable Data Deduplication on these workloads:

- файловые серверы общего назначения (GPFS) с такими общими ресурсами, как общие групповые папки, домашние папки пользователей, рабочие папки и общие ресурсы для разработки программного обеспечения; General purpose file servers (GPFS) serving shares such as team shares, user home folders, work folders, and software development shares.

- серверы инфраструктуры виртуальных рабочих столов (VDI); Virtualized desktop infrastructure (VDI) servers.

- Виртуализированные приложения резервного копирования, такие как Microsoft Data Protection Manager (DPM). Virtualized backup applications, such as Microsoft Data Protection Manager (DPM).

- Рабочие нагрузки, для которых дедупликация может дать преимущества, но только при соблюдении некоторых условий. Workloads that might benefit from deduplication, but aren’t always good candidates for deduplication. При работе с такими нагрузками необходимо сначала оценить применимость и эффективность дедупликации. Примеры таких нагрузок: For example, the following workloads could work well with deduplication, but you should evaluate the benefits of deduplication first:

- узлы Hyper-V общего назначения; General purpose Hyper-V hosts

- Серверы SQL Server SQL servers

- производственные серверы. Line-of-business (LOB) servers

Оценка дедупликации данных для рабочих нагрузок Evaluate workloads for Data Deduplication

Если вы используете рекомендуемые рабочие нагрузки, можно пропустить этот раздел и сразу включить дедупликацию данных. If you are running a recommended workload, you can skip this section and go to Enable Data Deduplication for your workload.

Чтобы определить, применимость дедупликации для рабочей нагрузки, ответьте на следующие вопросы. To determine whether a workload works well with deduplication, answer the following questions. Если вы не уверены в характеристиках рабочей нагрузки, можно выполнить пилотное развертывание дедупликации данных на тестовом наборе данных этой рабочей нагрузки. If you’re unsure about a workload, consider doing a pilot deployment of Data Deduplication on a test dataset for your workload to see how it performs.

Есть ли в наборе данных рабочей нагрузки достаточный объем дублирующихся данных, чтобы включение дедупликации дало ощутимый эффект? Does my workload’s dataset have enough duplication to benefit from enabling deduplication? Прежде чем включать дедупликацию данных для рабочей нагрузки, оцените объем дублирующихся данных в наборе данных, используя средство оценки экономии от дедупликации данных (DDPEval). Before enabling Data Deduplication for a workload, investigate how much duplication your workload’s dataset has by using the Data Deduplication Savings Evaluation tool, or DDPEval. После установки дедупликации данных это средство можно найти здесь: C:\Windows\System32\DDPEval.exe . After installing Data Deduplication, you can find this tool at C:\Windows\System32\DDPEval.exe . DDPEval поможет вам оценить потенциальный эффект оптимизации для непосредственно подключенных томов (включая локальные диски или общие тома кластера), а также для сопоставленных или несопоставленных сетевых папок. DDPEval can evaluate the potential for optimization against directly connected volumes (including local drives or Cluster Shared Volumes) and mapped or unmapped network shares. При выполнении DDPEval.exe будут возвращены выходные данные, аналогичные следующим: Data Deduplication Savings Evaluation Tool Running DDPEval.exe will return an output similar to the following: Data Deduplication Savings Evaluation Tool Copyright 2011-2012 Microsoft Corporation. All Rights Reserved. Evaluated folder: E:\Test Evaluated folder: E:\Test Processed files: 34 Processed files size: 12.03MB Optimized files size: 4.02MB Space savings: 8.01MB Space savings percent: 66 Optimized files size (no compression): 11.47MB Space savings (no compression): 571.53KB Space savings percent (no compression): 4 Files with duplication: 2 Files excluded by policy: 20 Files excluded by error: 0

Как выглядят шаблоны ввода-вывода рабочей нагрузки в наборе данных? Какова производительность для моей рабочей нагрузки? What do my workload’s I/O patterns to its dataset look like? What performance do I have for my workload? Дедупликация данных оптимизирует файлы, выполняя периодическое задание, а не во время сохранения файла на диск. Data Deduplication optimizes files as a periodic job, rather than when the file is written to disk. В связи с этим сначала следует оценить ожидаемые шаблоны рабочей нагрузки на чтение из дедуплицированного тома. As a result, it is important to examine is a workload’s expected read patterns to the deduplicated volume. Поскольку дедупликация данных перемещает содержимое файла в хранилище блоков и пытается как можно плотнее заполнять его файлами, более эффективно будут выполняться операции чтения из последовательных диапазонов файла. Because Data Deduplication moves file content into the Chunk Store and attempts to organize the Chunk Store by file as much as possible, read operations perform best when they are applied to sequential ranges of a file.

Рабочие нагрузки баз данных обычно имеют более случайный характер операций чтения, так как база данных не гарантирует оптимальную структуру данных для всех возможных выполняемых запросов. Database-like workloads typically have more random read patterns than sequential read patterns because databases do not typically guarantee that the database layout will be optimal for all possible queries that may be run. Данные из одного раздела хранилища блоков могут располагаться в разных частях тома, поэтому обращение к хранилищу данных может приводить к дополнительным задержкам. Because the sections of the Chunk Store may exist all over the volume, accessing data ranges in the Chunk Store for database queries may introduce additional latency. Высокопроизводительные рабочие нагрузки особенно чувствительны к таким задержкам, но это справедливо не для всех баз данных. High performance workloads are particularly sensitive to this extra latency, but other database-like workloads might not be.

Эти проблемы особенно важны для рабочих нагрузок, которые хранят данные на томах, состоящих из традиционных носителей с вращающимися дисками (жесткие диски или HDD). These concerns primarily apply to storage workloads on volumes made up of traditional rotational storage media (also known as Hard Disk drives, or HDDs). Любая инфраструктура флэш-памяти (твердотельные накопители или SSD) менее подвержена проблемам случайных операций ввода-вывода, так как флэш-память обеспечивает одинаковое время доступа ко всем расположениям на носителе. All-flash storage infrastructure (also known as Solid State Disk drives, or SSDs), is less affected by random I/O patterns because one of the properties of flash media is equal access time to all locations on the media. Таким образом, дедупликация будет сопряжена с разной величиной задержки при операциях чтения в зависимости от того, где хранятся наборы данных рабочей нагрузки: на носителях на основе флэш-памяти или на традиционных вращающихся дисках. Therefore, deduplication will not introduce the same amount of latency for reads to a workload’s datasets stored on all-flash media as it would on traditional rotational storage media.

Какие требования к ресурсам сервера предъявляет рабочая нагрузка? What are the resource requirements of my workload on the server? Так как дедупликация данных использует модель постобработки, она предполагает периодическое выделение значительных системных ресурсов для выполнения оптимизации и других заданий. Because Data Deduplication uses a post-processing model, Data Deduplication periodically needs to have sufficient system resources to complete its optimization and other jobs. Это означает, что рабочие нагрузки с определенными периодами простоя (например, в вечернее время или выходные дни) прекрасно подходят для дедупликации, в отличие от рабочих нагрузок, выполняемых круглосуточно изо дня в день. This means that workloads that have idle time, such as in the evening or on weekends, are excellent candidates for deduplication, and workloads that run all day, every day may not be. Но при этом дедупликацию можно успешно применить и для рабочих нагрузок без периодов простоя, если такие нагрузки не имеют высоких требований к ресурсам сервера. Workloads that have no idle time may still be good candidates for deduplication if the workload does not have high resource requirements on the server.

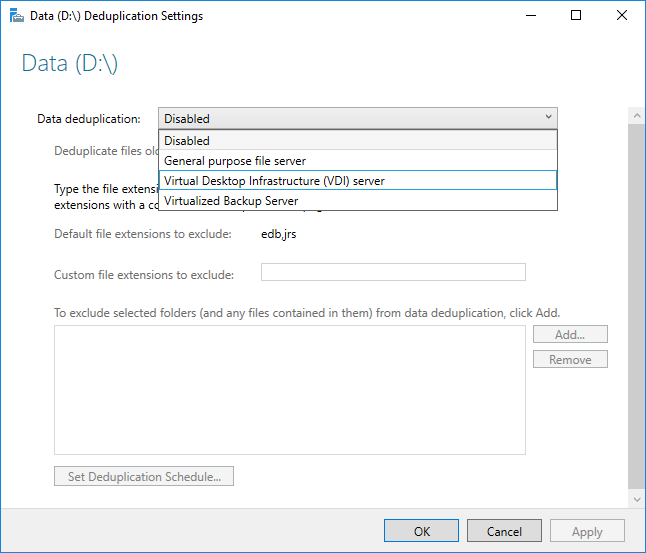

Включение дедупликации данных Enable Data Deduplication

Перед включением дедупликации данных следует выбрать тип использования, который соответствует вашей рабочей нагрузке. Before enabling Data Deduplication, you must choose the Usage Type that most closely resembles your workload. Существует три типа использования для дедупликации данных: There are three Usage Types included with Data Deduplication.

- По умолчанию — оптимальные настройки для файлового сервера общего назначения. Default — tuned specifically for general purpose file servers

- Hyper-V — настройки специально для серверов VDI. Hyper-V — tuned specifically for VDI servers

- Резервное копирование — оптимальные настройки для виртуализированных приложений резервного копирования, таких как Microsoft DPM. Backup — tuned specifically for virtualized backup applications, such as Microsoft DPM

Включение дедупликации данных с помощью диспетчера сервера Enable Data Deduplication by using Server Manager

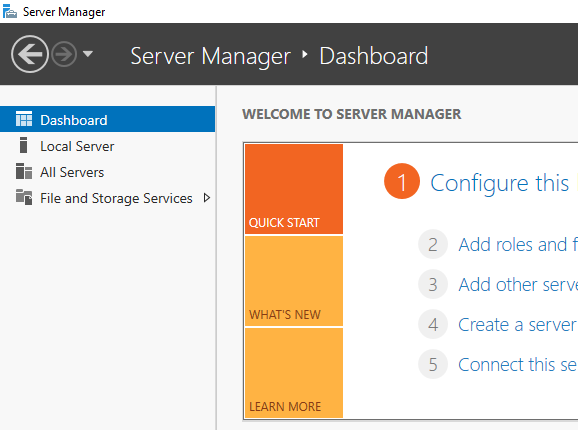

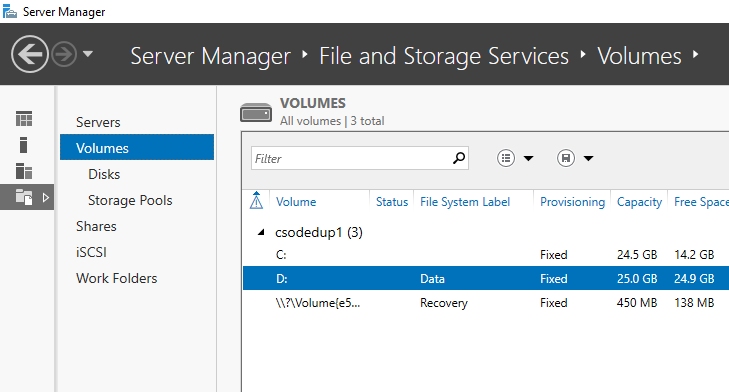

- Выберите службы файлов и хранилища в Диспетчер сервера. Select File and Storage Services in Server Manager.

- Во всплывающем меню Файловые службы и службы хранилища выберите Тома. Select Volumes from File and Storage Services.

- Щелкните правой кнопкой мыши нужный том и выберите пункт Настройка дедупликации данных. Right-click the desired volume and select Configure Data Deduplication.

- Выберите в раскрывающемся списке нужный тип использования и нажмите ОК. Select the desired Usage Type from the drop-down box and select OK.

- Если вы используете рекомендуемую рабочую нагрузку, на этом процесс окончен. If you are running a recommended workload, you’re done. Для других рабочих нагрузок изучите раздел Дополнительные вопросы. For other workloads, see Other considerations.

Дополнительные сведения об исключении определенных расширений файлов или папок, а также о создании расписания дедупликации (включая описание причин этих изменений), см. на странице Настройка дедупликации данных. You can find more information on excluding file extensions or folders and selecting the deduplication schedule, including why you would want to do this, in Configuring Data Deduplication.

Включение дедупликации данных с помощью PowerShell Enable Data Deduplication by using PowerShell

Выполните следующую команду PowerShell с правами администратора: With an administrator context, run the following PowerShell command:

Если вы используете рекомендуемую рабочую нагрузку, на этом процесс окончен. If you are running a recommended workload, you’re done. Для других рабочих нагрузок изучите раздел Дополнительные вопросы. For other workloads, see Other considerations.

Командлеты PowerShell для дедупликации данных, включая Enable-DedupVolume , можно запустить удаленно, добавив -CimSession параметр в сеанс CIM. The Data Deduplication PowerShell cmdlets, including Enable-DedupVolume , can be run remotely by appending the -CimSession parameter with a CIM Session. Это особенно полезно для удаленного выполнения командлетов PowerShell на экземпляре Nano Server. This is particularly useful for running the Data Deduplication PowerShell cmdlets remotely against a Nano Server instance. Чтобы создать новый сеанс CIM, выполните команду New-CimSession . To create a new CIM Session run New-CimSession .

Дополнительные рекомендации Other considerations

Если ваша рабочая нагрузка относится к категории рекомендуемых, этот раздел можно пропустить. If you are running a recommended workload, you can skip this section.

- Типы использования, доступные при дедупликации данных, предусматривают практические стандартные значения для рекомендуемых рабочих нагрузок, а также используются в качестве отправной точки для остальных рабочих нагрузок. Data Deduplication’s Usage Types give sensible defaults for recommended workloads, but they also provide a good starting point for all workloads. Для рабочих нагрузок, не входящих в категорию рекомендуемых, вы можете изменить дополнительные параметры дедупликации данных, чтобы повысить ее эффективность. For workloads other than the recommended workloads, it is possible to modify Data Deduplication’s advanced settings to improve deduplication performance.

- Если рабочая нагрузка характеризуется высокими требованиями к ресурсам сервера, задания дедупликации данных следует запланировать на период ожидаемого простоя рабочей нагрузки. If your workload has high resource requirements on your server, the Data Deduplication jobs should be scheduled to run during the expected idle times for that workload. Это особенно важно, если дедупликация выполняется на гиперконвергированном узле, ведь в рабочее время процессы дедупликации могут истощить ресурсы виртуальных машин. This is particularly important when running deduplication on a hyper-converged host, because running Data Deduplication during expected working hours can starve VMs.

- Если рабочая нагрузка не особо требовательна к ресурсам или быстрое выполнение заданий оптимизации важнее, чем обслуживание запросов рабочей нагрузки, вы можете настроить параметры выделения памяти, ЦП и приоритета для заданий дедупликации. If your workload does not have high resource requirements, or if it is more important that optimization jobs complete than workload requests be served, the memory, CPU, and priority of the Data Deduplication jobs can be adjusted.

Часто задаваемые вопросы Frequently asked questions (FAQ)

Я хочу выполнить дедупликацию данных в наборе данных для рабочей нагрузки X. Поддерживается ли это? I want to run Data Deduplication on the dataset for X workload. Is this supported? Мы полностью гарантируем целостность данных при применении дедупликации данных с любой рабочей нагрузкой, кроме включенных в список несовместимых с дедупликацией. Aside from workloads that are known not to interoperate with Data Deduplication, we fully support the data integrity of Data Deduplication with any workload. Для рекомендуемых рабочих нагрузок корпорация Майкрософт также гарантирует повышение производительности. Recommended workloads are supported by Microsoft for performance as well. Производительность других рабочих нагрузок в значительной мере зависит от того, какие действия они выполняют на сервере. The performance of other workloads depends greatly on what they are doing on your server. Необходимо определить, каким образом дедупликация данных повлияла на вашу рабочую нагрузку и допустимо ли такое влияние для этой нагрузки. You must determine what performance impacts Data Deduplication has on your workload, and if this is acceptable for this workload.

Каковы требования к размеру тома для дедуплицированных томов? What are the volume sizing requirements for deduplicated volumes? В Windows Server 2012 и Windows Server 2012 R2 размер тома следует выбирать осторожно, чтобы дедупликация данных выполнялась в соответствии со скоростью обновления данных в томе. In Windows Server 2012 and Windows Server 2012 R2, volumes had to be carefully sized to ensure that Data Deduplication could keep up with the churn on the volume. В большинстве случаев максимальный размер дедуплицированного тома для рабочей нагрузки с высокой скоростью обновления данных составляет 1–2 ТБ. Мы рекомендуем в любом случае не превышать размер 10 ТБ. This typically meant that the average maximum size of a deduplicated volume for a high-churn workload was 1-2 TB, and the absolute maximum recommended size was 10 TB. Эти ограничения устранены в Windows Server 2016. In Windows Server 2016, these limitations were removed. Дополнительные сведения см. в статье Новые возможности функции дедупликации данных. For more information, see What’s new in Data Deduplication.

Нужно ли изменять расписание или другие параметры дедупликации данных для рекомендуемых рабочих нагрузок? Do I need to modify the schedule or other Data Deduplication settings for recommended workloads? Нет, предоставленные типы использования были созданы для предоставления разумных значений по умолчанию для рекомендуемых рабочих нагрузок. No, the provided Usage Types were created to provide reasonable defaults for recommended workloads.

Каковы требования к памяти для дедупликации данных? What are the memory requirements for Data Deduplication? При дедупликации данных следует выделить по меньшей мере 300 МБ, а также дополнительно 50 МБ на каждый терабайт логических данных. At a minimum, Data Deduplication should have 300 MB + 50 MB for each TB of logical data. Например, если вы оптимизируете том размером 10 ТБ, для дедупликации следует выделить не менее 800 МБ памяти ( 300 MB + 50 MB * 10 = 300 MB + 500 MB = 800 MB ). For instance, if you are optimizing a 10 TB volume, you would need a minimum of 800 MB of memory allocated for deduplication ( 300 MB + 50 MB * 10 = 300 MB + 500 MB = 800 MB ). Дедупликация данных может выполняться и с меньшим объемом памяти, но такое ограничение ресурсов замедлит выполнение заданий этой функции. While Data Deduplication can optimize a volume with this low amount of memory, having such constrained resources will slow down Data Deduplication’s jobs.

Лучше всего, если для дедупликации данных будет выделено по 1 ГБ памяти на каждый 1 ТБ логических данных. Optimally, Data Deduplication should have 1 GB of memory for every 1 TB of logical data. Например, если вы оптимизируете том размером 10 ТБ, оптимальный объем памяти для дедупликации составит 10 ГБ ( 1 GB * 10 ). For instance, if you are optimizing a 10 TB volume, you would optimally need 10 GB of memory allocated for Data Deduplication ( 1 GB * 10 ). Такое соотношение обеспечит максимальную производительность для заданий дедупликации данных. This ratio will ensure the maximum performance for Data Deduplication jobs.

Каковы требования к объему хранилища для дедупликации данных? What are the storage requirements for Data Deduplication? В Windows Server 2016 дедупликация данных может поддерживать тома размером до 64 ТБ. In Windows Server 2016, Data Deduplication can support volume sizes up to 64 TB. Дополнительные сведения см. в статье What’s new in Data Deduplication (Новые возможности функции дедупликации данных). For more information, view What’s new in Data Deduplication.