- Будни администратора

- Замена неисправного диска в Storage Spaces Direct на Windows Server 2016

- Добавление серверов или дисков в локальные дисковые пространства Adding servers or drives to Storage Spaces Direct

- Добавление серверов Adding servers

- От двух до трех серверов: разблокирование трехстороннего зеркального отображения From 2 to 3 servers: unlocking three-way mirroring

- Вариант 1 Option 1

- Вариант 2 Option 2

- Предложение 3 Option 3

- От трех до четырех серверов: разблокирование двойной четности From 3 to 4 servers: unlocking dual parity

- Вариант 1 Option 1

- Вариант 2 Option 2

- Предложение 3 Option 3

- Пример Example

- Больше четырех серверов: повышение эффективности контроля четности Beyond 4 servers: greater parity efficiency

- Добавление серверов при использовании отказоустойчивости на уровне шасси или стоек Adding servers when using chassis or rack fault tolerance

- Добавление дисков Adding drives

- Оптимизация использования диска после добавления дисков или серверов Optimizing drive usage after adding drives or servers

Будни администратора

Итак, в наличии имеется пять дешевых серверов Supermicro с 8 D дисками по 2Tb, подключенных через RAID контроллер Adaptec 6805, одним диском SATA малого размера, подключенным напрямую к материнской плате. На каждом сервере по 2 гигабитные сетевые карты, 16 гигабайт оперативной памяти и по два процессора Xeon E5-2670.

По одному эти сервера для меня представляют мало пользы, но вместе, они представляют из себя сырой объем в 80 терабайт, что уже может быть вкусно для файлового хранилища, без требований к скорости.

Попробую собрать из этого отказоустойчивое хранилище с использованием технологии Storage Spaces Direct. Забегая вперед, скажу что нечетное количество серверов нам понадобится для того, чтобы не заводить в кластере свидетеля. Нечетное количество нод позволяет работать кластеру без свидетеля.

На момент написания статьи в доступе был релиз Windows Server 2016 TP4. Его я и установил на все пять серверов.

ОС определила все оборудование, имеющееся на борту, за исключением SAS контроллера с идентификатором PCI\VEN_8086&DEV_1D6B&CC_0107, что соответствует Intel(R) C600 Series Chipset SAS RAID, который мне сейчас не понадобится.

RAID контроллер позволяет презентовать подключенные к нему диски в виде JBOD, что в нашем случае идеальный вариант.

Первая проблема, которую пришлось решать довольно старая, с которой я столкнулся еще в Windows 2008. Представленные диски ОС видит как набор маленьких RAID массивов:

Get-PhysicalDisk | FT FriendlyName, Mediatype, BusType -autosize

Такую шину S2D не поддерживает. Решить это дело в моем случае помог тот же прием, что и раньше — в реестре исправить тип шины на SATA для нужного типа контроллера:

[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\arcsas\Parameters]

«BusType»=dword:0000000b

вместо

«BusType»=dword:00000008

Делаем эту операцию на всех нодах, перегружаем их. Устанавливаем нужный нам для кластерного файлсервера роли и компоненты:

Проверяем работу интерфейсов. В моем случае с двумя сетевыми картами, сделал две сети — клиентскую и кластерную. В идеале, нужно иметь 4 сетевых интерфейса на каждой ноде, создать два switch independent тима и подключить их в два независимых свича, исключив отказ сетевого оборудования:

Get-NetAdapter | FT Name, InterfaceDescription, LinkSpeed -autosize

Name InterfaceDescription LinkSpeed

—- ——————— ———

HEARTBEAT Intel(R) I350 Gigabit Network Connection #2 1 Gbps

LAN Intel(R) I350 Gigabit Network Connection 1 Gbps

Собираем кластер из 5 нод:

Включаем функционал S2D:

Enable-ClusterStorageSpacesDirect

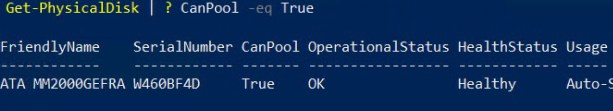

Смотрим какие локальные диски на нодах могут быть помещены в пул:

Get-PhysicalDisk | ? CanPool -eq $true

У меня это по 8 локальных физических дисков на каждом из 5 серверов:

Проверяем работоспособность подсистемы StorageSubSystem

Get-StorageSubSystem *cluster*

FriendlyName HealthStatus OperationalStatus

———— ———— ——————

Clustered Windows Storage on s-ssdcl1 Healthy OK

——

Собираем пул:

Если у нас в пуле было бы три диска, то их можно собрать только в уровень Mirror:

New-StoragePool -StorageSubSystemName s-ssdcl1.tnt-tv.ru -FriendlyName StorageSpacesDirect -WriteCacheSizeDefault 0 -ProvisioningTypeDefault Fixed -ResiliencySettingNameDefault Mirror -PhysicalDisks (Get-StorageSubSystem -Name s-mos1-w16.tnt-tv.ru | Get-PhysicalDisk)

Так как дисков у нас сильно побольше, создаем пул Parity, который возможен от 4 и более дисков:

New-StoragePool -StorageSubSystemName s-ssdcl1.tnt-tv.ru -FriendlyName StorageSpacesDirect -WriteCacheSizeDefault 0 -ProvisioningTypeDefault Fixed -ResiliencySettingNameDefault Parity -PhysicalDisks (Get-StorageSubSystem -Name s-ssdcl1.tnt-tv.ru | Get-PhysicalDisk)

——

Обозначаем тир:

Тиринг нужен, при наличии разнородных носителей (SSD, SAS, SATA). Tier-зеркало (актуальный для SSD носителей) создается так:

New-StorageTier -StoragePoolFriendlyName «StorageSpacesDirect» -FriendlyName «MirrorTier» -MediaType SSD -ResiliencySettingName Mirror

В нашем случае, можно создавать тир, а можно обойтись и без него, так как диски все одинаковые. Я обозначил Parity тир больше для проформы:

New-StorageTier -StoragePoolFriendlyName «StorageSpacesDirect» -FriendlyName «ParityTier» -MediaType HDD -ResiliencySettingName Parity

——

Создаем VHD с рабочей емкостью:

Для создания VHD, лично мне удобно пользоваться GUI Failover Clustering.

В повершелле это выглядит так. Если несколько тиров:

New-Volume -StoragePoolFriendlyName «StorageSpacesDirect» -FriendlyName «FailSafeData» -AccessPath «S:» -ResiliencySettingName «Parity» -ProvisioningType «Fixed» -StorageTiers (Get-StorageTier -FriendlyName «ParityTier») -StorageTierSizes 55000GB -FileSystem NTFS

Если один тир, можно просто:

New-Volume -StoragePoolFriendlyName «StorageSpacesDirect» -FriendlyName «FailSafeData» -Size 100GB -ResiliencySettingName «Mirror» -FileSystem NTFS -AccessPath «S: «-ProvisioningType Fixed

Выделил опцию Enclosure awareness — это поможет прозрачно отработать отказ одного из серверов в кластере. Тем не менее сразу теряю емкость 5 дисков (одной ноды).

Полезную емкость у диска выбрал меньшую, чем может дать мой набор дисков. Рекомендуется держать неразмеченный кусок, как кеш для перестроений при замене отказавших дисков:

Проверил отказоустойчивость отключением любого из серверов, и вытаскиванием двух любых дисков — хранилище доступно и работает!

Напоследок несколько заметок по работе с готовым S2D.

Проверить отказоустойчивость:

Get-StoragePool -FriendlyName «StorageSpacesDirect» | FL FriendlyName, Size, FaultDomainAwarenessDefault

Удаление в обратном порядке:

смотрим какие есть виртуальные диски (тут я его удалил из оснастки, но видно что он не удален раельно а только Detached)

Get-VirtualDisk

FriendlyName ResiliencySettingName OperationalStatus HealthStatus IsManualAttach Size

———— ——————— —————— ———— ————— —-

StorageSpacesDirect Parity Detached Unknown True 402 GB

Удаляем диск

Remove-VirtualDisk «StorageSpacesDirect»

Если нужно, изменяем свойство пула IsReadonly на False (иначе не сможем удалить пул):

Set-StoragePool «StorageSpacesDirect» -IsReadOnly $False

Удаляем пул

Remove-StoragePool «StorageSpacesDirect»

Замена неисправного диска в Storage Spaces Direct на Windows Server 2016

В прошлой статье мы рассказывали о новой технологии организации распределенного хранения, появившейся в Windows Server 2016 – Storage Spaces Direct (S2D). S2D позволяет организовать на локальных дисках серверов кластера отказоустойчивое распределенное виртуальное хранилище данных (см. статью). В этой статье мы разберемся, как обнаружить и заменить вышедший из строя физический диск в кластере S2D.

Напомню, в S2D можно организовать диск в хранилище типа Mirror (напоминает RAID 1): в конфигурации с 2 дисками (не рекомендовано) такое хранилище может пережить выход из строя любого диска, если дисков в пуле более 3 – без последствий одновременно из строя могут выйти 2 любых диска. Второй тип массива – Parity (похож на RAID 5). В конфигурации из трех дисков массив может без последствий «потерять» один диск, при семи дисках – одновременно из строя могу выйти до 2 дисков.

Проверить состояние подсистемы хранения кластера S2D можно с помощью команды:

Get-StorageSubSystem *Cluster* | Get-StorageJob

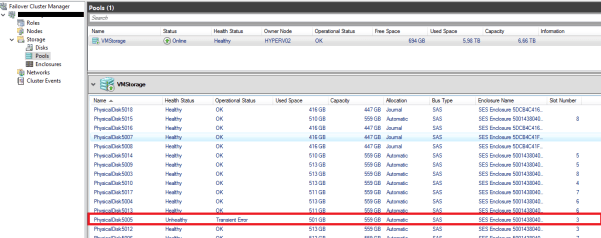

Неисправность одного из дисков пула хранения в GUI можно обнаружить в консоли Failover Cluster Manager (Storage ->Storage Pool). Как вы видите, один из дисков физических пула находится в состоянии Unhealthy.

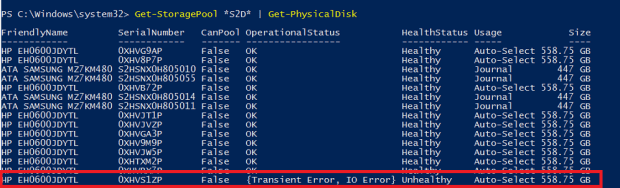

Информацию о состоянии дисков пула можно получить с помощью PowerShell:

Get-StoragePool *S2D* | Get-PhysicalDisk

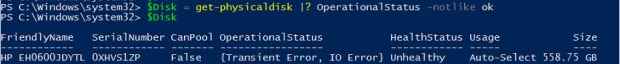

Сохраним объект проблемного диска в переменную, например так:

$Disk = Get-PhysicalDisk |? OperationalStatus -Notlike ok

Запретим дальнейшие попытки записи на данный диск:

Set-PhysicalDisk -InputObject $Disk -Usage Retired

Попробуем исключить данный неисправный диск из пула хранения.:

Get-StoragePool *S2D* | Remove-PhysicalDisk –PhysicalDisk $Disk

Скорее всего появится предупреждение, что данное устройство не отвечает.

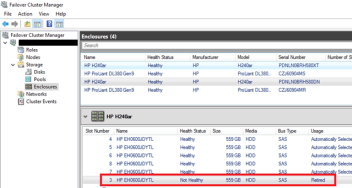

Чтобы было проще идентифицировать диск в серверной стойке, включим LED подсветку диска:

Get-PhysicalDisk |? OperationalStatus -Notlike OK | Enable-PhysicalDiskIdentification

Теперь идет в серверную комнату и находим проблемный диск с помощью включенной ранее подсветки.

Выполняем замену неисправного диска на новый.

Теперь подсветку можно отключить:

Get-PhysicalDisk |? OperationalStatus -like OK | Disable-PhysicalDiskIdentification

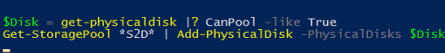

Проверим, определила ли ОС новый диск:

$Disk = Get-PhysicalDisk | ? CanPool –eq True

Добавим новый диск в пул:

Get-StoragePool *S2D* | Add-PhysicalDisk –PhysicalDisks $Disk –Verbose

На этом все, S2D автоматически запустит процедуру перераспределения данных между дисками (в Windows Server 2012 Storage Spaces необходимо было запускать команду Repair-VirtualDisk вручную). Длительность синхронизации данных зависит от емкости диска и нагрузки на пул (в моем стенде заняло около 30 минут). После этого можно еще раз проверить статус пула.

Добавление серверов или дисков в локальные дисковые пространства Adding servers or drives to Storage Spaces Direct

Применяется к: Windows Server 2019, Windows Server 2016 Applies to: Windows Server 2019, Windows Server 2016

В этом разделе описывается добавление серверов или дисков в локальные дисковые пространства. This topic describes how to add servers or drives to Storage Spaces Direct.

Добавление серверов Adding servers

Добавление серверов, которое часто называют горизонтальным масштабированием, позволяет увеличить емкость, повысить производительность хранилища и улучшить эффективность хранения. Adding servers, often called scaling out, adds storage capacity and can improve storage performance and unlock better storage efficiency. Если ваше развертывание гиперконвергентное, добавление серверов также поможет увеличить объем вычислительных ресурсов для рабочих нагрузок. If your deployment is hyper-converged, adding servers also provides more compute resources for your workload.

Горизонтальное масштабирование обычных развертываний легко достигается путем добавления серверов. Typical deployments are simple to scale out by adding servers. Регистрация состоит всего из двух этапов. There are just two steps:

Запустите мастер проверки кластера с помощью оснастки отказоустойчивого кластера или командлета Test-Cluster в PowerShell (запустите его от имени администратора). Run the cluster validation wizard using the Failover Cluster snap-in or with the Test-Cluster cmdlet in PowerShell (run as Administrator). Включите новый сервер , который вы хотите добавить. Include the new server you wish to add.

Это позволит убедиться в том, что новый сервер работает под управлением Windows Server 2016 Datacenter Edition, присоединен к тому же домену доменных служб Active Directory, что и существующие серверы, имеет все необходимые роли и компоненты и для него правильно настроено сетевое взаимодействие. This confirms that the new server is running Windows Server 2016 Datacenter Edition, has joined the same Active Directory Domain Services domain as the existing servers, has all the required roles and features, and has networking properly configured.

Если вы повторно используете диски, содержащие старые данные или метаданные, которые вам больше не нужны, очистите их с помощью оснастки Управление дисками или командлета Reset-PhysicalDisk. If you are re-using drives that contain old data or metadata you no longer need, clear them using Disk Management or the Reset-PhysicalDisk cmdlet. При обнаружении старых данных или метаданных диски не объединяются в пул. If old data or metadata is detected, the drives aren’t pooled.

Чтобы завершить добавление сервера, выполните следующую команду в кластере: Run the following cmdlet on the cluster to finish adding the server:

Автоматическое добавление в пул возможно только в том случае, если имеется только один пул. Automatic pooling depends on you having only one pool. Если вы обработали стандартную конфигурацию для создания нескольких пулов, вам потребуется вручную добавить новые диски в предпочтительный пул с помощью Add- Drive. If you’ve circumvented the standard configuration to create multiple pools, you will need to add new drives to your preferred pool yourself using Add-PhysicalDisk.

От двух до трех серверов: разблокирование трехстороннего зеркального отображения From 2 to 3 servers: unlocking three-way mirroring

При наличии двух серверов можно создать только тома с двухсторонним зеркалированием (сопоставимо с распределенными массивами RAID-1). With two servers, you can only create two-way mirrored volumes (compare with distributed RAID-1). При наличии трех серверов вы можете создать трехсторонние зеркальные тома для улучшенной отказоустойчивости. With three servers, you can create three-way mirrored volumes for better fault tolerance. Мы рекомендуем по возможности использовать трехстороннее зеркалирование. We recommend using three-way mirroring whenever possible.

Двусторонние зеркальные тома невозможно обновить на месте до трехстороннего зеркального отображения. Two-way mirrored volumes cannot be upgraded in-place to three-way mirroring. Вместо этого вы можете создать новый том и перенести (скопировать, например с помощью реплики хранения) в него свои данные, а затем удалить старый том. Instead, you can create a new volume and migrate (copy, such as by using Storage Replica) your data to it, and then remove the old volume.

Приступить к созданию томов с трехсторонним зеркалированием можно несколькими способами. To begin creating three-way mirrored volumes, you have several good options. Вы можете использовать любой из них по своему усмотрению. You can use whichever you prefer.

Вариант 1 Option 1

Укажите значение PhysicalDiskRedundancy= 2 для каждого создаваемого тома. Specify PhysicalDiskRedundancy = 2 on each new volume upon creation.

Вариант 2 Option 2

Вместо этого можно указать значение PhysicalDiskRedundancyDefault = 2 для объекта ResiliencySetting пула с именем Mirror. Instead, you can set PhysicalDiskRedundancyDefault = 2 on the pool’s ResiliencySetting object named Mirror. После этого все новые зеркальные тома будут автоматически использовать трехстороннее зеркальное отображение, даже если это не указано. Then, any new mirrored volumes will automatically use three-way mirroring even if you don’t specify it.

Предложение 3 Option 3

Задайте значение PhysicalDiskRedundancy= 2 для шаблона StorageTier под названием Capacity, а затем создайте тома, указав уровень. Set PhysicalDiskRedundancy = 2 on the StorageTier template called Capacity, and then create volumes by referencing the tier.

От трех до четырех серверов: разблокирование двойной четности From 3 to 4 servers: unlocking dual parity

При наличии четырех серверов можно использовать двойную четность, также часто называемую помехоустойчивым кодированием (сопоставимо с распределенными массивами RAID-6). With four servers, you can use dual parity, also commonly called erasure coding (compare to distributed RAID-6). При этом обеспечивается та же двойная отказоустойчивость, что и при трехстороннем зеркалировании, но с повышенным уровнем эффективности. This provides the same fault tolerance as three-way mirroring, but with better storage efficiency. Дополнительные сведения см. в разделе Отказоустойчивость и экономичность хранения. To learn more, see Fault tolerance and storage efficiency.

Если вы начинаете с небольшого развертывания, у вас есть несколько вариантов для создания томов двойной четности. If you’re coming from a smaller deployment, you have several good options to begin creating dual parity volumes. Вы можете использовать любой из них по своему усмотрению. You can use whichever you prefer.

Вариант 1 Option 1

Укажите значения PhysicalDiskRedundancy = 2 и ResiliencySettingName = Parity при создании каждого нового тома. Specify PhysicalDiskRedundancy = 2 and ResiliencySettingName = Parity on each new volume upon creation.

Вариант 2 Option 2

Установите значение PhysicalDiskRedundancy = 2 для объекта ResiliencySetting пула с именем Parity. Set PhysicalDiskRedundancy = 2 on the pool’s ResiliencySetting object named Parity. После этого для всех новых томов будет использоваться двойная четность, даже если это не указано. Then, any new parity volumes will automatically use dual parity even if you don’t specify it

При наличии четырех серверов можно также начинать использовать четность с зеркальным ускорением, при которой для отдельного тома применяется как зеркалирование, так и контроль четности. With four servers, you can also begin using mirror-accelerated parity, where an individual volume is part mirror and part parity.

Для этого необходимо изменить шаблоны StorageTier так, чтобы она включала уровни Performance и Capacity, которые были бы созданы, если бы вы предварительно выполнили командлет Enable-ClusterS2D на четырех серверах. For this, you will need to update your StorageTier templates to have both Performance and Capacity tiers, as they would be created if you had first run Enable-ClusterS2D at four servers. В частности, должны иметь тип MediaType устройств хранения (например, твердотельные или жесткие диски) и значение PhysicalDiskRedundancy= 2. Specifically, both tiers should have the MediaType of your capacity devices (such as SSD or HDD) and PhysicalDiskRedundancy = 2. Уровень Performance должен иметь значение ResiliencySettingName = Mirror, а уровень Capacity — значение ResiliencySettingName = Parity. The Performance tier should be ResiliencySettingName = Mirror, and the Capacity tier should be ResiliencySettingName = Parity.

Предложение 3 Option 3

Возможно, будет проще просто удалить существующий шаблон, а затем создать два новых. You may find it easiest to simply remove the existing tier template and create the two new ones. Это не повлияет на существующие тома, созданные с помощью шаблона уровня. это просто шаблон. This will not affect any pre-existing volumes which were created by referring the tier template: it’s just a template.

Вот и все! That’s it! Теперь вы готовы создать тома с зеркально ускоренной четностью, ссылаясь на эти шаблоны уровней. You are now ready to create mirror-accelerated parity volumes by referencing these tier templates.

Пример Example

Больше четырех серверов: повышение эффективности контроля четности Beyond 4 servers: greater parity efficiency

При использовании более чем четырех серверов с контролем четности эффективность новых томов может быть еще выше. As you scale beyond four servers, new volumes can benefit from ever-greater parity encoding efficiency. Например, при количестве серверов от шести до семи эффективность повышается с 50,0 % до 66,7 %, так становится возможным использовать код Рида-Соломона 4+2 (а не 2+2). For example, between six and seven servers, efficiency improves from 50.0% to 66.7% as it becomes possible to use Reed-Solomon 4+2 (rather than 2+2). Чтобы получить такую эффективность, не нужно предпринимать дополнительных действий. Оптимальное кодирование определяется автоматически при каждом создании тома. There are no steps you need to take to begin enjoying this new efficiency; the best possible encoding is determined automatically each time you create a volume.

Однако ранее существовавшие тома не будут преобразовываться в новые с расширенной кодировкой. However, any pre-existing volumes will not be «converted» to the new, wider encoding. Одна из веских причин этого в том, что для этого потребовались бы сложные вычислительные операции буквально с каждым битом, имеющимся в среде. One good reason is that to do so would require a massive calculation affecting literally every single bit in the entire deployment. Чтобы обеспечить более эффективную кодировку существующих данных, их можно перенести в новые тома. If you would like pre-existing data to become encoded at the higher efficiency, you can migrate it to new volume(s).

Добавление серверов при использовании отказоустойчивости на уровне шасси или стоек Adding servers when using chassis or rack fault tolerance

Если в развертывании применяется отказоустойчивость на уровне шасси или стоек, необходимо указать шасси или стойку для новых серверов, прежде чем добавлять их в кластер. If your deployment uses chassis or rack fault tolerance, you must specify the chassis or rack of new servers before adding them to the cluster. Таким образом вы сообщаете локальным дисковым пространствам, как лучше распределять данные для достижения максимальной отказоустойчивости. This tells Storage Spaces Direct how best to distribute data to maximize fault tolerance.

Создайте временный домен сбоя для узла, открыв сеанс PowerShell с повышенными привилегиями, а затем используя следующую команду, где — это имя нового узла кластера: Create a temporary fault domain for the node by opening an elevated PowerShell session and then using the following command, where is the name of the new cluster node:

Переместите этот временный домен сбоя в корпус или стойку, где новый сервер находится в реальном мире, как указано в

Добавьте сервер в кластер, как описано в разделе Добавление серверов. Add the server to the cluster as described in Adding servers. Когда новый сервер присоединяется к кластеру, он автоматически связывается (по имени) с доменом-заполнителем сбоя. When the new server joins the cluster, it’s automatically associated (using its name) with the placeholder fault domain.

Добавление дисков Adding drives

Добавление дисков (также известное как вертикальное масштабирование) позволяет увеличить объем хранилища, а также повысить его производительность. Adding drives, also known as scaling up, adds storage capacity and can improve performance. При наличии доступных слотов можно добавить диски в каждый сервер, чтобы увеличить емкость хранения, не добавляя серверы. If you have available slots, you can add drives to each server to expand your storage capacity without adding servers. Диски для хранения кэша и основных данных можно добавлять независимо друг от друга в любое время. You can add cache drives or capacity drives independently at any time.

Мы настоятельно рекомендуем использовать одинаковую конфигурации хранилища для всех серверов. We strongly recommend that all servers have identical storage configurations.

Чтобы произвести вертикальное масштабирование, подключите диски и проверьте, обнаруживает ли их система Windows. To scale up, connect the drives and verify that Windows discovers them. Они должны отображаться в выходных данных командлета Get-PhysicalDisk в PowerShell со свойством CanPool, имеющим значение True. They should appear in the output of the Get-PhysicalDisk cmdlet in PowerShell with their CanPool property set to True. Если они отображаются как CanPool = False, вы можете узнать, почему, изучив свойство CannotPoolReason. If they show as CanPool = False, you can see why by checking their CannotPoolReason property.

В течение короткого промежутка времени подходящие диски будут автоматически запрошены Локальные дисковые пространства, добавлены в пул носителей, а тома будут автоматически перераспределяться по всем дискам. Within a short time, eligible drives will automatically be claimed by Storage Spaces Direct, added to the storage pool, and volumes will automatically be redistributed evenly across all the drives. После этого можно приступать к расширению существующих или созданию дополнительных томов. At this point, you’re finished and ready to extend your volumes or create new ones.

Если диски не отображаются, вручную проверьте наличие изменений в оборудовании. If the drives don’t appear, manually scan for hardware changes. Это можно сделать с помощью диспетчера устройств в меню Действие. This can be done using Device Manager, under the Action menu. Если диски содержат старые данные или метаданные, рекомендуем переформатировать их. If they contain old data or metadata, consider reformatting them. Это можно сделать с помощью оснастки Управление дисками или командлета Reset-PhysicalDisk. This can be done using Disk Management or with the Reset-PhysicalDisk cmdlet.

Автоматическое добавление в пул возможно только в том случае, если имеется только один пул. Automatic pooling depends on you having only one pool. Если вы обработали стандартную конфигурацию для создания нескольких пулов, вам потребуется вручную добавить новые диски в предпочтительный пул с помощью Add- Drive. If you’ve circumvented the standard configuration to create multiple pools, you will need to add new drives to your preferred pool yourself using Add-PhysicalDisk.

Оптимизация использования диска после добавления дисков или серверов Optimizing drive usage after adding drives or servers

Со временем при добавлении или удалении дисков распределение данных между дисками в пуле может стать нечетным. Over time, as drives are added or removed, the distribution of data among the drives in the pool can become uneven. В некоторых случаях это может привести к полному заполнению некоторых дисков, в то время как другие диски в пуле значительно более низкие. In some cases, this can result in certain drives becoming full while other drives in pool have much lower consumption.

Для обеспечения равномерного выделения места на диске в пуле Локальные дисковые пространства автоматически оптимизирует использование диска после добавления дисков или серверов в пул (это процесс вручную для систем дисковых пространств, использующих общие корпусы SAS). To help keep drive allocation even across the pool, Storage Spaces Direct automatically optimizes drive usage after you add drives or servers to the pool (this is a manual process for Storage Spaces systems that use Shared SAS enclosures). Оптимизация начинается через 15 минут после добавления нового диска в пул. Optimization starts 15 minutes after you add a new drive to the pool. Оптимизация пула выполняется как фоновая операция с низким приоритетом, поэтому ее выполнение может занять несколько часов или дней, особенно если вы используете большие жесткие диски. Pool optimization runs as a low-priority background operation, so it can take hours or days to complete, especially if you’re using large hard drives.

Оптимизация использует два задания — одно с именем optimize , а другое — перебалансировка . Вы можете отслеживать ход выполнения с помощью следующей команды: Optimization uses two jobs — one called Optimize and one called Rebalance — and you can monitor their progress with the following command:

Пул носителей можно оптимизировать вручную с помощью командлета optimize-StoragePool . You can manually optimize a storage pool with the Optimize-StoragePool cmdlet. Ниже приведен пример. Here’s an example: